Disclaimer: все дальнейшие рассуждения, настройки и выбранные методы тестирования могут быть ошибочны. Никакого отношения к компаниям Lenovo, Huawei, Broadcom мы не имеем.

Цели тестирования:

- определить производительность системы хранения данных (СХД) в кластере HyperMetro и её изменение при различных вариантах отказа оборудования;

- оценить влияние на производительность и доступность программно-аппаратного комплекса (ПАК) фирменного MPIO-драйвера (драйвер балансировки подключения по нескольким путям ввод-вывода) Huawei Ultrapath;

- протестировать функциональность SmartVirtualization СХД Huawei Dorado 5000V6 – способность выдавать через себя дисковые разделы других СХД.

Дополнительно была проведена проверка работоспособности одного из серверов системы управления базами данных (СУБД) Oracle DB при отказе узла кластера HyperMetro. Для этого сервер был временно перенесён в кластер HyperMetro без прерывания его работы, а по окончании тестирования возвращён обратно.

Оборудование было предоставлено системным интегратором, который также составил и выполнил программу и методику испытаний. Тестирование осуществлялось при помощи программы VDBench, имитировалась нагрузка, аналогичная создаваемой основным сервером СУБД Oracle DB в ежедневной эксплуатации. Профиль нагрузки приведён в Приложении 1.

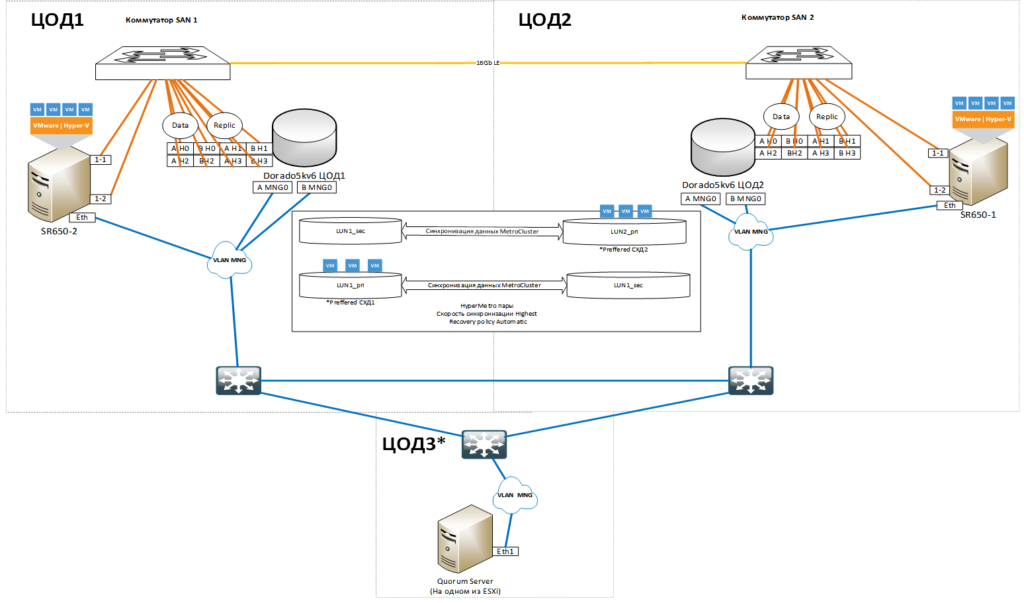

Для проведения тестирования был собран стенд, имитирующий размещение оборудования в двух пространственно-разнесённых центрах обработки данных, установлено и настроено программное обеспечение (ПО) и развёрнуты тестовые виртуальные машины. Схема стенда и описание используемого ПО приводятся в Приложении 2.

Первичное конфигурирование системы проводилось с использованием штатных MPIO-драйверов среды виртуализации VMware ESXi. Драйвер оказывает решающее влияние на производительность системы и её отказоустойчивость, поэтому было проведено две серии тестов – со штатными драйверами VMware, и с фирменными драйверами Huawei Ultrapath от изготовителя СХД. Перед началом тестирования выживаемости кластера при различных вариантах отказов оборудования и влияние отказов на производительность был выполнен эталонный замер производительности системы в штатном режиме работы. Методика замера и результаты приведены в Приложении 3.

После определения исходного уровня производительности системы, была выполнена оценка изменения производительности при отказе удалённой системы хранения (Приложение 4), локальной системы хранения (Приложение 5) и дирижёра кластера (Quorum Server). С целью проверки выживаемости, в тестовую среду был мигрирован сервер СУБД Oracle DB (DEV03). Оценивалось влияние на работоспособность и доступность сервера отказ одной из реплик хранилища. Результаты приведены в Приложении 6.

Следующим этапом стала оценка влияния на производительность и доступность системы использование MPIO-драйвера Huawei Ultrapath. В процессе подготовки стенда выяснилось, что драйвер существует только для версии VMware ESXi 6.7U3, а на стенде развёрнута VMware ESXi 7. Для проведения работ был подготовлен и подключен новый сервер с требуемой версией ESXi, описание стенда приведено в Приложении 7.

Поскольку среда поменялась, были проведены замеры производительности системы в штатном режиме (Приложение 8). Затем выполнены замеры производительности при отказе удалённого хранилища (Приложение 9) и локального (Приложение 10).

После проведения серии опытов по определению производительности работы и отказоустойчивости кластера, была выполнена оценка функционала виртуализации СХД (SmartVirualization) и сделаны замеры производительности работы системы при прямом подключении к серверу раздела СХД EMC VNX5700 и подключении его через функцию виртуализации СХД Huawei Dorado 5000 V6. Схема стенда и результаты тестирования приведены в Приложении 11.

Дополнительно была выполнена оценка влияния процесса создания и удаления моментальных снимков (снапшотов, snapshots) виртуальных машин (ВМ) на производительность работы ВМ при использовании традиционных томов VMFS (Приложение 12), при использовании виртуальных томов VVOL (Приложение 13), а также влияние на производительность процедуры установки обновлений управляющего ПО СХД (Приложение 14).

Краткое резюме по этапам тестирования производительности приведено в таблице:

| № | Краткое описание демо-стенда | Имитируемый отказ | Оценка влияния на работоспособность | Оценка влияния на производительность | Оценка загруженности линка между площадками |

| 1. | Кластер Huawei HyperMetro из двух СХД Dorado5000v6, режим работы Local Preffered, режим восстановления Auto, скорость репликации Highest В качестве серверного оборудования используется два сервера с ESXi 7.0 в кластере VMware HA с 14-ю ВМ VDbench, имитирующими нагрузку. В качестве MPIO используется штатный MPIO-драйвер VMware. Оборудование установлено комплектами (1 СХД + 1 сервер + 1 FC коммутатор) на двух площадках, соединенных по сети SAN одним оптическим линком SM 16Gb/s |

Отказ Quorum | Отсутствует | Отсутствует | – |

| 2. | Отказ СХД №1 | Кратковременная приостановка ввода-вывода на 13 секунд, без перехода хранилищ VMFS VMware в состояние недоступности | При обрыве синхронизации томов Huawei HyperMetro рост производительности (IOPS) на 8%, без существенных изменений во времени отклика. При старте синхронизации томов Huawei HyperMetro уменьшение производительности (IOPS) на 8%, без существенных изменений во времени отклика. Время синхронизации 1час 18 минут. |

До 1Gb/s при имитации нагрузки. До 4Gb/s при синхронизации реплик томов Huawei HyperMetro |

|

| 3. | Отказ СХД №2 | При отказе кратковременная приостановка ввода-вывода на 13 секунд, без перехода хранилищ VMFS VMware в состояние недоступности | При обрыве синхронизации томов Huawei HyperMetro деградация производительности (IOPS) на 50% на 17 секунд, после чего рост производительности (IOPS) на 8%, без существенных изменений во времени отклика. При старте синхронизации томов Huawei HyperMetro уменьшение производительности (IOPS) на 8%, без существенных изменений во времени отклика. Время синхронизации 1 час 12 минут. |

До 1Gb/s при имитации нагрузки. До 4Gb/s при синхронизации реплик томов Huawei HyperMetro |

|

| 4. | Влияние отказа СХД №1 на ВМ dev03 c работающей БД Oracle | Кратковременная приостановка ввода-вывода на 13 секунд, без последующего прерывания в работе БД и тестовых отчетов | – | До 1Gb/s при имитации нагрузки. До 4Gb/s при синхронизации реплик томов Huawei HyperMetro |

|

| 5. | Кластер Huawei Hyper-Metro из двух СХД Dorado5000v6, режим работы Local Preffered, режим восстановления Auto, скорость репликации Highest. В качестве серверного оборудования используется один сервер с ESXi 6.7U3 и семью ВМ VDbench, имитирующими нагрузку. В качестве MPIO используется MPIO-драйвер Huawei UltraPath. Оборудование установлено комплектами (1 СХД + 1 сервер + 1 FC коммутатор) на двух площадках, соединенных по сети SAN одним оптическим линком SM 16Gb/s |

Отказ Quorum | Отсутствует | Отсутствует | – |

| 6. | Отказ СХД №1 | При отказе кратковременная приостановка ввода-вывода на 13 секунд, без перехода хранилищ VMFS VMware в состояние недоступности | Во время недоступности реплики тома Huawei HyperMetro отмечен рост производительности операций ввода-вывода (IOPS) на 2%, без существенных изменений во времени отклика. При старте синхронизации томов Huawei HyperMetro уменьшение производительности IOPS на 16%, без существенных изменений во времени отклика. Время синхронизации 51 минута. |

До 1Gb/s при имитации нагрузки. До 4Gb/s при синхронизации реплик томов кластера Huawei HyperMetro |

|

| 7. | Отказ СХД №2 | При отказе кратковременная приостановка ввода-вывода на 13 секунд, без перехода хранилищ VMFS VMware в состояние недоступности | При обрыве синхронизации томов Huawei HyperMetro рост производительности (IOPS) на 16%, без существенных изменений во времени отклика. При старте синхронизации томов Huawei HyperMetro уменьшение производительности (IOPS) на 16%, без существенных изменений во времени отклика. Время синхронизации 51 минута. |

До 1Gb/s при имитации нагрузки. До 4Gb/s при синхронизации реплик томов кластера Huawei HyperMetro |

Результаты тестирования функции виртуализации внешних систем хранения (Smart Virtualization) CХД Huawei Dorado V6 приведены в таблице:

| Краткое описание демо-стенда | Оценка влияния на работоспособность | Оценка влияния на производительность |

| СХД с исходными данными – существующая VNX5700 с одним тестовым LUN на 8TB. СХД, осуществляющая виртуализацию – Dorado5000v6. В качестве серверного оборудования используется один сервер с ESXi 7.0 и семью ВМ VDbench, имитирующими нагрузку. В качестве MPIO используется штатный MPIO-драйвер VMware. |

Отсутствует | a. Зафиксировано незначительное увеличение времени отклика на 2% с 5,72 до 5,86, также зафиксированы всплески во времени отклика; b. Зафиксировано незначительное ухудшение производительности (IOPS) на 2% с 4881 до 4764. |

Результаты тестирования процесса создания и удаления моментальных снимков ВМ (снапшотов) на CХД Huawei Dorado V6 с томами VMFS:

| Краткое описание демо-стенда | Оценка влияния на работоспособность | Оценка влияния на производительность и времени создания/удаления снапшота |

| Кластер Huawei Hyper-Metro из двух СХД Dorado5000v6, режим работы Local Preffered, режим восстановления Auto, скорость репликации Highest. В качестве серверного оборудования используется один сервер с ESXi 7.0 в кластере VMware HA одной ВМ VDbench имитирующими нагрузку. Используются VMFS6 VMware Datastore. В качестве MPIO используется штатный MPIO-драйвер VMware. Оборудование установлено комплектами (1 СХД + 1 сервер + 1 FC коммутатор) на двух площадках, соединенных по сети SAN одним оптическим линком SM 16Gb |

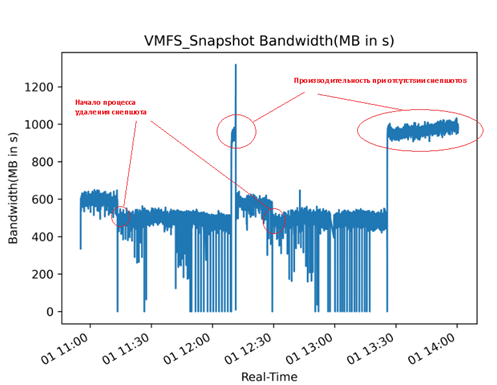

В процессе удаления снапшота -многочисленные кратковременные приостановки ввода-вывода на 1 секунду, без потери доступности диска ВМ В конце процесса удаления происходят кратковременные приостановки ввода-вывода на 6 секунд без потери доступности диска ВМ |

a. Время создания снапшота под нагрузкой на тестовой ВМ с диском на 5TB занимает 6 минут, после полного завершения процесса создания зафиксирована деградация производительности(MB/s) на 38%. b. Время удаления снапшота под нагрузкой на тестовой ВМ с диском на 5TB и изменением не менее 200GB данных на нем занимает 56 минут, при этом: i. С начала запуска процесса удаления зафиксирована деградация производительности(MB/s) на 10%. ii. После завершения процесса удаления зафиксирован рост производительности(MB/s) на 48%. |

Результаты тестирования процесса создания и удаления моментальных снимков ВМ на CХД Huawei Dorado V6 с томом VVOL:

| Краткое описание демо-стенда | Оценка влияния на работоспособность | Оценка влияния на производительность и времени создания/удаления снапшота |

| СХД Dorado5000v6, обновленная до версии 6.0.1 SPH5. Huawei VASA провайдер версии 2.1.19, зарегистрированный на VMware vCenter версии 6.7U3j. В качестве серверного оборудования используется один сервер с ESXi 6.7U3 с одной ВМ VDbench, имитирующей нагрузку. Используются VMware VVOL Datastore, c политикой хранения ВМ на дисках SSD. В качестве MPIO используется MPIO Huawei UltraPath. Оборудование (1 СХД + 1 сервер) установлено на одной площадке и подключено к одному FC – коммутатору |

Текущая версии 2.1.19 VASA провайдера работает нестабильно, с периодическим переходом состояния регистрации данного провайдера в статус Disconnected. При этом: a. ВМ остается доступна, но любые операции с ней невозможны; b. VVOL Datastore переходит в состояние Inaccessible. |

В начале процесса создания снапшота и по завершении процесса удаления снапшота зафиксирована приостановка ввода-вывода на ВМ Slave07 на 7 секунд. Время создания и удаления снапшотов с ОЗУ: a. Создание занимает 1 час 12 минут и 27 секунд; b. Удаление занимает 9 секунд. Время создания и удаления снапшотов без ОЗУ: a. Создание занимает 14 секунд; b. Удаление занимает 18 миллисекунд. |

Выводы по итогам тестирования

- Технология HyperMetro-кластера (двух удалённых на большое расстояние систем хранения данных, на одной из которых размещается основная копия данных, на второй – её реплика) может быть использована в продуктивной среде для обеспечения непрерывности работы прикладных задач в случае аварийного выключения основного ЦОДа или основной системы хранения.

- Потери производительности при отказе одной из систем незначительны, а в случае отказа удалённой системы производительность возрастает. Потери производительности на синхронизацию данных после восстановления доступности систем не превышают 20%. Пауза длительностью 13-14 секунд в момент пропадания одной из реплик не привела к отказу в обслуживании СУБД Oracle DB, что является подтверждением возможности использования технологии для обеспечения непрерывности работы информационной системы.

- Со штатными MPIO-драйверами VMware показывает лучшую производительность в операциях чтения-записи на том. Использование MPIO-драйвера Huawei UltraPath возможно только в случае если все системы хранения данных предприятия будут производства Huawei. С оборудованием других производителей драйвер не работает.

- Функция виртуализации других систем хранения не даёт никаких преимуществ в производительности перед прямым подключением этих систем и, в основном, может быть использована для миграции данных из сторонних СХД на Dorado 5000 V6.

- Процесс создания, а особенно наличия моментального снимка ВМ (снапшота) оказывает существенное влияние на производительность работы системы, которая падает почти в два раза. Поэтому снапшоты рекомендуется создавать в периоды наименьшей загрузки системы и не оставлять дольше, чем это необходимо.

- По сравнению с классической технологией VMFS, технология VVOLs (Virtual Volumes) для VMware показала лучшие результаты в операциях чтения-записи на том, уменьшение времени создания и удаления снапшотов ВМ без оперативной памяти. Однако создание снапшотов ВМ с оперативной памятью занимает весьма продолжительное время, также зафиксирована нестабильная работа управляющей службы тома (VASA-провайдера). Текущая реализация VVOLs в продукте Huawei для VMware не может быть рекомендована к использованию для продуктивных систем.

- Интерфейс управления СХД Dorado 5000 V6 дружелюбен и интуитивно понятен.

- Конструктивно СХД Dorado 5000 V6 имеет большую длину, из-за чего может быть установлена только в определённых слотах стандартной серверной стойки. Также она имеет высокую теплопроизводительность и нуждается в хорошем охлаждении. Это следует учитывать при выборе и оснащении места размещения СХД.

- В целом, технология метрокластера и система хранения Huawei Dorado 5000 V6 заслуживает положительной оценки и может рекомендована к внедрению в продуктивную среду.

Приложения

Приложение 1. Профиль нагрузки Oracle СУБД DB

Исходя из полученных перед началом тестирования отчетов AWR с существующих СУБД Oracle DB заказчика установлен следующий профиль нагрузки для VDbench:

- 93% операций ввода-вывода на диск совершается с размером блока 8KB при соотношении чтения/записи 73% к 27%;

- 7% операций ввода-вывода на диск совершается с размером блока 512b при соотношении чтения/записи 16% к 84%.

Приложение 2. Описание тестового стенда c штатным MPIO-драйвером ESXi

Тестовый стенд имитирует собой два независимых центра обработки данных, объединенных темной оптикой. В каждом центре обработки данных установлен следующий комплект оборудования:

- одна СХД Huawei Dorado5000 v6;

- один сервер Lenovo SR650 (2xCPU, 768GB RAM, 4x10GbE, 2x32Gb FC) с ОС VMware ESXi, 7.0.0, 16324942;

- один коммутатор SAN с двенадцатью 16 или 32Gb MM SFP+, c одним одномодовым SFP+;

- семь ВМ VDbench (8vCPU, 24GB RAM, 16GB disk, 4x600GB тестовые диски с контроллерами VMware Paravirtual SCSI).

Дополнительно на существующем оборудовании заказчика разворачивается две ВМ:

- одна для управления VDbench;

- одна для сервера Quorum кластера Huawei HyperMetro.

Серверное оборудование обновляется последними версиями прошивок и на ESXi устанавливаются версии драйверов в соответствии с таблицами совместимости Huawei.

На коммутаторах SAN настраивается зонирование, обеспечивающее связь.

Описание настроек кластера Huawei HyperMetro для VMware:

- Все NVMe-диски собираются в один StoragePool RAID5 с политикой резервирования дисков High;

- Создается HyperMetro-домен из двух СХД Huawei с Quorum сервером доступным через порты управления обоих контроллеров. Для данного домена создается отдельный пользователь на СХД. Обе СХД осуществляют репликацию через 4 выделенных порта для репликации;

- Создаются две пары LUN на СХД:

- На первой СХД – LUN1_pri и LUN2_sec по 21TB;

- На второй СХД – LUN1_sec и LUN2_pri по 21TB;

- Из которых собирается две пары HyperMetro, в которых LUN1 назначается роль Preffered на первой СХД, а LUN2 роль Preffered на второй СХД. Скорость репликации Highest. Политика восстановления Automatic.

- Созданные LUN презентуются хостам с одинаковым LUN ID (10 для LUN1, 11 для LUN2), которые настраиваются таким образом, чтобы пути к СХД, расположенной на одной площадке с сервером были выбраны как активные, а пути к уделенной СХД как резервные. Для презентации LUN хостам используются 4 выделенных порта для данных:

- На первой СХД:

- Сервер SR650-2

- HyperMetro Working Mode: Local preferred mode

- OS Setting: VMware ESXi

- Host Access Mode: Asymmetric

- Preferred Path for HyperMetro: Yes

- Сервер SR650-1

- HyperMetro Working Mode: Local preferred mode

- OS Setting: VMware ESXi

- Host Access Mode: Asymmetric

- Preferred Path for HyperMetro: No

- На второй СХД:

- Сервер SR650-2

- HyperMetro Working Mode: Local preferred mode

- OS Setting: VMware ESXi

- Host Access Mode: Asymmetric

- Preferred Path for HyperMetro: No

- Сервер SR650-1

- HyperMetro Working Mode: Local preferred mode

- OS Setting: VMware ESXi

- Host Access Mode: Asymmetric

- Preferred Path for HyperMetro: Yes

- На ESXi выполняются следующие настройки политик работы с путями к Huawei:

- esxcli storage nmp psp roundrobin deviceconfig set –device=naa.6ac8d34100ec7478024b9dc900000000 –iops=1 –type iops

- esxcli storage nmp psp roundrobin deviceconfig set –device=naa.6ac8d34100ec7478024bb11000000001 –iops=1 –type iops

- esxcli storage nmp satp rule add -V HUAWEI -M XSG1 -s VMW_SATP_ALUA -P VMW_PSP_RR -c tpgs_on

- Сервер SR650-2

- Сервер SR650-2

- На первой СХД:

- Гипервизоры ESXi собираются в кластер со следующими параметрами:

- HA: Enabled

- Proactive HA: Disabled

- Host Failure: Restart VMs. Using VM restart priority ordering.

- Host Isolation: VMs on isolated hosts will remain powered on.

- Datastore with Permanent Device Loss: Power off and restart VMs. Datastore protection enabled. Always attempt to restart VMs.

- Datastore with All Paths Down: Power off and restart VMs (Agressive restart policy). Datastore protection enabled. Always attempt to restart VMs.

- Guest not heartbeating: Disabled VM and application monitoring disabled.

- Тестовые диски ВМ размещаются на Preffered LUN локальной СХД. Нумерация ВМ с 1 по 7 на SR650-1 и с 8 по 14 на SR650-2.

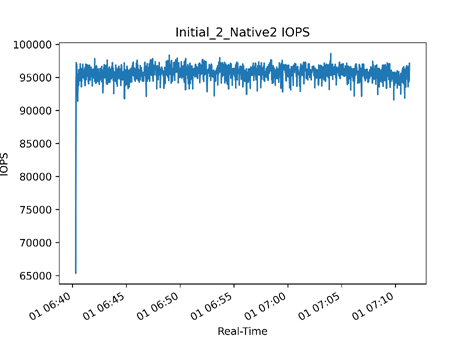

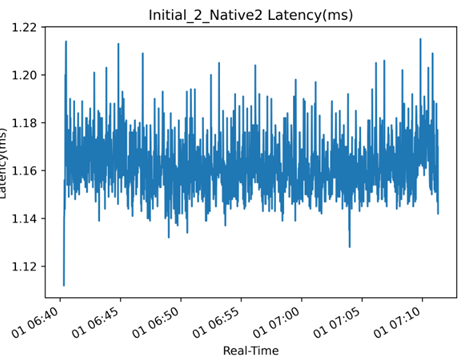

Приложение 3. Первоначальное тестирование

В ходе первоначального тестирования проводилось наполнение дисков тестовых ВМ vdbench случайными данными и определялся служебный параметр – число потоков vdbench (в конфигурации профиля нагрузки заказчика), при котором достигается нагрузка с максимально оптимальным сочетанием IOPS/Latency. В ходе первоначального тестирования данный параметр устанавливается равным 2.

Таблица тестирования с различным числом потоков.

| BlockSize | Thread | AverageIOPS | AverageLatency | AverageMBsec |

| 7654 | 1 | 78150,6 | 0,701 | 570,48 |

| 7654 | 2 | 99126,7 | 1,123 | 723,6 |

| 7654 | 4 | 98605,5 | 2,262 | 719,79 |

| 7654 | 8 | 98385,3 | 4,543 | 718,2 |

| 7654 | 16 | 98543,1 | 9,07 | 719,35 |

| 7654 | 32 | 98018,9 | 18,246 | 715,51 |

| 7654 | 64 | 98403 | 36,309 | 718,34 |

| 7654 | 128 | 98415,7 | 72,211 | 718,44 |

Графики IOPS, Bandwidth, latency для числа потоков = 2:

Приложение 4. Производительность при использовании Native MPIO. Имитация отказа СХД №1 (удалённой)

Для текущего теста стенд описан в Приложении 2. Выбор служебных параметров VDbench описан в Приложении 3.

Протокол теста:

- В 12:55 запущен VDbench со следующими параметрами производительности 96k IOPS 700MB/s в конфигурации профиля нагрузки заказчика (Oracle DB) на 14-ти ВМ.

- В 12:56 сервер Quorum отключен, в интерфейсе СХД зафиксировано появление ошибки о недоступности Quorum:

- Деградации производительности не обнаружено.

- В 12:57 сервер Quorum включен, в интерфейсе СХД зафиксировано отсутствие ошибки о недоступности Quorum:

- Деградации производительности не обнаружено.

- В 12:59 путем полного отключения электропитания сымитирован отказ СХД №1, зафиксировано:

- Пути на гипервизорах ESXi до СХД №1 перешли в состояние Dead, пути до СХД№2 ранее находившиеся в статусе Active перешли в статус Active (I/O);

- Полная приостановка ввода-вывода к дискам ВМ на 13 секунд;

- После возобновления ввода-вывода, зафиксирован рост производительности (IOPS) на 8% с 96000 до 104000, при этом значительных колебаний времени отклика от диска не обнаружено.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| 12:59:26.014 | 238 | 96402.0 | 703.56 | 7652 | 69.05 | 1.155 | 1.173 | 1.114 | 12.39 | 15.92 | 0.437 | 111.3 | 6.5 | 4.7 |

| 12:59:27.015 | 239 | 96186.0 | 700.89 | 7640 | 68.75 | 1.159 | 1.177 | 1.118 | 19.19 | 13.03 | 0.460 | 111.5 | 6.6 | 4.7 |

| 12:59:28.020 | 240 | 86945.0 | 633.90 | 7644 | 68.72 | 1.173 | 1.195 | 1.125 | 16.35 | 17.77 | 0.490 | 111.4 | 6.0 | 4.4 |

| 12:59:29.025 | 241 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 12:59:30.023 | 242 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.1 | 0.1 |

| 12:59:31.015 | 243 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.9 | 0.2 | 0.1 |

| 12:59:32.014 | 244 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 12:59:33.014 | 245 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.9 | 0.2 | 0.1 |

| 12:59:34.014 | 246 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.2 | 0.1 |

| 12:59:35.031 | 247 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.3 | 0.2 | 0.1 |

| 12:59:36.014 | 248 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.7 | 0.2 | 0.1 |

| 12:59:37.014 | 249 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.1 | 0.1 |

| 12:59:38.014 | 250 | 2.0 | 0.02 | 8192 | 100.00 | 10042.836 | 10042.836 | 0.000 | 10045.04 | 0.00 | 3.118 | 112.0 | 0.2 | 0.1 |

| 12:59:39.014 | 251 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.2 | 0.1 |

| 12:59:40.019 | 252 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.3 | 0.1 |

| 12:59:41.015 | 253 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 12:59:42.015 | 254 | 11047.0 | 80.94 | 7682 | 68.43 | 140.968 | 101.568 | 226.351 | 14076.31 1 | 4048.29 | 1390.169 | 111.9 | 1.1 | 0.7 |

| 12:59:43.016 | 255 | 100545.0 | 733.95 | 7654 | 68.99 | 1.108 | 1.255 | 0.780 | 19.75 | 3.90 | 0.588 | 111.4 | 8.3 | 6.0 |

| 12:59:44.016 | 256 | 91473.0 | 667.75 | 7654 | 69.05 | 1.217 | 1.391 | 0.830 | 20.95 | 9.48 | 0.685 | 111.4 | 6.4 | 4.3 |

| 12:59:45.015 | 257 | 91835.0 | 670.14 | 7651 | 69.01 | 1.214 | 1.391 | 0.818 | 19.02 | 10.46 | 0.687 | 111.5 | 6.5 | 4.6 |

| 12:59:46.014 | 258 | 90526.0 | 661.20 | 7658 | 68.85 | 1.229 | 1.411 | 0.829 | 16.14 | 8.76 | 0.668 | 111.3 | 6.2 | 4.6 |

| 12:59:47.015 | 259 | 90086.0 | 657.10 | 7648 | 68.74 | 1.237 | 1.424 | 0.825 | 18.70 | 10.24 | 0.657 | 111.4 | 6.1 | 4.5 |

| 12:59:48.015 | 260 | 88138.0 | 643.92 | 7660 | 68.80 | 1.264 | 1.455 | 0.842 | 14.07 | 10.72 | 0.775 | 111.4 | 6.3 | 4.6 |

| 12:59:49.014 | 261 | 91090.0 | 664.66 | 7651 | 69.03 | 1.221 | 1.401 | 0.821 | 15.42 | 12.40 | 0.653 | 111.2 | 6.3 | 4.6 |

| 12:59:52.016 | 264 | 105677.0 | 770.99 | 7650 | 68.83 | 1.053 | 1.196 | 0.739 | 12.72 | 11.37 | 0.539 | 111.3 | 6.6 | 4.9 |

| 12:59:53.016 | 265 | 104723.0 | 764.27 | 7652 | 69.07 | 1.062 | 1.206 | 0.739 | 13.57 | 9.37 | 0.551 | 111.2 | 6.6 | 4.9 |

| 12:59:54.015 | 266 | 105205.0 | 768.82 | 7662 | 69.30 | 1.056 | 1.195 | 0.741 | 14.78 | 11.34 | 0.534 | 111.0 | 6.7 | 4.8 |

| 12:59:55.015 | 267 | 104017.0 | 759.17 | 7653 | 69.18 | 1.068 | 1.210 | 0.749 | 15.91 | 10.77 | 0.589 | 111.1 | 7.0 | 5.0 |

| 12:59:56.014 | 268 | 103686.0 | 757.00 | 7655 | 69.04 | 1.072 | 1.215 | 0.755 | 13.57 | 11.52 | 0.552 | 111.2 | 6.9 | 5.0 |

| 12:59:57.016 | 269 | 107111.0 | 782.09 | 7656 | 68.99 | 1.036 | 1.172 | 0.734 | 17.46 | 11.47 | 0.515 | 111.0 | 7.1 | 5.1 |

| 12:59:58.014 | 270 | 103990.0 | 758.44 | 7647 | 69.12 | 1.069 | 1.211 | 0.749 | 16.36 | 9.87 | 0.590 | 111.1 | 6.9 | 5.0 |

- В 13:05 было подано электропитание на СХД№1, через 10 минут система автоматически запустилась. В 13:17:37 автоматически запустилась синхронизация LUN’ов кластера HyperMetro (Режим работы Automatic, скорость репликации Highest), в результате чего было зафиксировано:

- Снижение производительности (IOPS) на 8% с 104000 до 96000, при этом значительных колебаний времени отклика от диска не обнаружено;

- Незначительные колебания загруженности процессора на контроллерах СХД с 25-30% до 40-45%;

- Загруженность линка SAN между площадками составляет не более 4Gb/s.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| 13:17:30.014 | 1322 | 101611.0 | 741.62 | 7653 | 69.12 | 1.095 | 1.242 | 0.768 | 14.87 | 10.93 | 0.641 | 111.3 | 6.6 | 4.9 |

| 13:17:31.014 | 1323 | 104194.0 | 760.59 | 7654 | 68.98 | 1.069 | 1.212 | 0.751 | 16.57 | 10.13 | 0.586 | 111.4 | 6.7 | 5.0 |

| 13:17:32.017 | 1324 | 104374.0 | 762.50 | 7660 | 69.09 | 1.066 | 1.207 | 0.752 | 13.44 | 11.18 | 0.579 | 111.3 | 6.7 | 5.0 |

| 13:17:33.014 | 1325 | 104904.0 | 766.10 | 7657 | 69.18 | 1.060 | 1.200 | 0.748 | 11.59 | 10.88 | 0.548 | 111.2 | 6.6 | 4.9 |

| 13:17:34.018 | 1326 | 107587.0 | 785.03 | 7651 | 69.28 | 1.034 | 1.165 | 0.739 | 18.69 | 9.75 | 0.482 | 111.3 | 6.8 | 5.1 |

| 13:17:35.014 | 1327 | 104917.0 | 765.87 | 7654 | 69.25 | 1.062 | 1.199 | 0.751 | 13.45 | 6.15 | 0.517 | 111.4 | 6.8 | 5.0 |

| 13:17:36.014 | 1328 | 103844.0 | 758.33 | 7657 | 69.12 | 1.072 | 1.212 | 0.758 | 13.74 | 11.79 | 0.582 | 111.3 | 6.6 | 4.9 |

| 13:17:37.016 | 1329 | 96590.0 | 705.16 | 7655 | 69.18 | 1.154 | 1.251 | 0.936 | 13.51 | 106.12 | 0.820 | 111.4 | 6.4 | 4.8 |

| 13:17:38.018 | 1330 | 94504.0 | 689.36 | 7648 | 69.06 | 1.177 | 1.271 | 0.967 | 18.19 | 12.54 | 0.562 | 111.3 | 6.3 | 4.8 |

| 13:17:39.015 | 1331 | 96133.0 | 700.53 | 7641 | 69.16 | 1.159 | 1.247 | 0.961 | 12.28 | 11.37 | 0.545 | 111.4 | 6.4 | 4.7 |

| 13:17:40.015 | 1332 | 97036.0 | 708.51 | 7656 | 69.18 | 1.148 | 1.233 | 0.957 | 17.74 | 15.50 | 0.544 | 111.4 | 6.3 | 4.7 |

| 13:17:41.015 | 1333 | 95551.0 | 698.03 | 7660 | 69.16 | 1.166 | 1.256 | 0.966 | 13.43 | 16.47 | 0.534 | 111.4 | 6.2 | 4.6 |

| 13:17:42.014 | 1334 | 97038.0 | 709.13 | 7662 | 69.30 | 1.147 | 1.234 | 0.953 | 11.96 | 11.48 | 0.492 | 111.3 | 6.4 | 4.8 |

| 13:17:43.014 | 1335 | 97437.0 | 711.88 | 7660 | 69.05 | 1.142 | 1.227 | 0.953 | 12.31 | 12.38 | 0.513 | 111.3 | 6.5 | 4.9 |

| 13:17:44.017 | 1336 | 96876.0 | 706.24 | 7644 | 68.84 | 1.150 | 1.237 | 0.957 | 14.21 | 11.61 | 0.572 | 111.4 | 6.4 | 4.7 |

- В 14:35 был завершен процесс синхронизации LUN’ов кластера HyperMetro, в результате чего было зафиксировано возвращение путей на ESXi в исходное состояние:

- Пути на гипервизорах ESXi до СХД №2 перешли в состояние Active на сервере площадки 1 и Active (I/O) на сервере площадки 2, пути до СХД №1 перешли в состояние Active на сервере площадки 2 и Active (I/O) на сервере площадки 1;

- Загруженность линка SAN между площадками сократилась до 1Gb/s.

Суммарные графики IOPS, Bandwidth, latency во время отключения/включения СХД:

Графики IOPS, Bandwidth, latency во время отключения/включения СХД для ВМ:

Графики IOPS, Bandwidth, latency во время отключения/включения СХД для ВМ:

Типовой график загрузки контроллеров СХД (*Далее аналогичен при аналогичных тестах):

Типовой график загрузки SAN-линка между ЦОДами (*Далее аналогичен при аналогичных тестах):

Приложение 5. Производительность при использовании Native MPIO-драйвера. Имитация отказа СХД №2 (локальной)

Для текущего теста стенд описан в Приложении 2. Выбор служебных параметров VDbench описан в Приложении 3.

Протокол теста:

- В 15:13 запущен VDbench со следующими параметрами производительности 96k IOPS 700MB/s в конфигурации профиля нагрузки заказчика (Oracle DB) на 14-ти ВМ.

- В 15:16 путем полного отключения электропитания сымитирован отказ СХД №2, зафиксировано:

- Пути на гипервизорах ESXi до СХД №2 перешли в состояние Dead, пути до СХД№1 ранее находившиеся в статусе Active перешли в статус Active (I/O);

- Полная приостановка ввода-вывода к дискам ВМ на 13 секунд c последующей деградацией производительности (IOPS) на 50% на 17 секунд, после чего зафиксирован рост производительности (IOPS) на 8%, с 96000 до 106000. При этом значительных колебаний времени отклика от диска не обнаружено.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| Отказ 1 СХД в 15_16: Пути к данной СХД в данного момента в Dead:!!!!! Зафиксировано полное прекращение в передаче данных на 13 сек + деградация производительности min 50% на 15 сек+ из-за остановки репликации выросли IOPS с 96к до 105к (5-6%) | ||||||||||||||

| 15:16:53.017 | 185 | 94874.0 | 693.06 | 7659 | 69.16 | 1.176 | 1.199 | 1.125 | 14.79 | 14.51 | 0.495 | 111.6 | 6.1 | 4.5 |

| 15:16:54.017 | 186 | 96669.0 | 705.09 | 7648 | 68.98 | 1.153 | 1.170 | 1.114 | 14.93 | 14.67 | 0.421 | 111.4 | 6.2 | 4.6 |

| 15:16:55.022 | 187 | 60090.0 | 438.43 | 7650 | 69.25 | 1.137 | 1.155 | 1.095 | 12.40 | 11.47 | 0.408 | 111.6 | 4.3 | 3.1 |

| 15:16:56.019 | 188 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.9 | 0.6 | 0.2 |

| 15:16:57.018 | 189 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 15:16:58.020 | 190 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.2 | 0.2 | 0.0 |

| 15:16:59.017 | 191 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.8 | 0.3 | 0.1 |

| 15:17:00.014 | 192 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.3 | 0.1 |

| 15:17:01.015 | 193 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.2 | 0.1 |

| 15:17:02.014 | 194 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.1 | 0.1 |

| 15:17:03.015 | 195 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.2 | 0.1 |

| 15:17:04.015 | 196 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 3.2 | 0.2 |

| 15:17:05.016 | 197 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 15:17:06.016 | 198 | 2.0 | 0.02 | 8192 | 100.00 | 11054.691 | 11054.691 | 0.000 | 11055.16 | 0.00 | 0.669 | 112.0 | 0.2 | 0.1 |

| 15:17:07.017 | 199 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.9 | 0.4 | 0.1 |

| 15:17:08.014 | 200 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 15:17:09.015 | 201 | 13305.0 | 96.91 | 7637 | 68.68 | 117.420 | 86.574 | 185.063 | 14254.26 | 14244.93 | 1278.477 | 112.0 | 1.2 | 0.9 |

| 15:17:10.014 | 202 | 61166.0 | 445.22 | 7632 | 68.79 | 0.908 | 1.021 | 0.659 | 8.91 | 2.90 | 0.362 | 111.5 | 4.2 | 2.9 |

| 15:17:11.014 | 203 | 58715.0 | 429.17 | 7664 | 69.08 | 0.947 | 1.064 | 0.687 | 19.29 | 10.61 | 0.451 | 111.6 | 3.8 | 2.7 |

| 15:17:12.015 | 204 | 48181.0 | 352.08 | 7662 | 69.22 | 1.157 | 1.326 | 0.777 | 11.10 | 6.41 | 0.595 | 111.9 | 3.5 | 2.5 |

| 15:17:13.015 | 205 | 49064.0 | 357.81 | 7646 | 68.89 | 1.135 | 1.298 | 0.774 | 14.19 | 10.56 | 0.582 | 111.6 | 3.4 | 2.5 |

| 15:17:14.016 | 206 | 47923.0 | 349.58 | 7648 | 68.88 | 1.163 | 1.325 | 0.804 | 8.49 | 4.40 | 0.566 | 111.7 | 3.4 | 2.5 |

| 15:17:15.014 | 207 | 46836.0 | 341.46 | 7644 | 68.99 | 1.189 | 1.354 | 0.820 | 11.37 | 11.38 | 0.587 | 111.6 | 3.5 | 2.5 |

| 15:17:16.013 | 208 | 46971.0 | 342.83 | 7653 | 68.70 | 1.185 | 1.354 | 0.816 | 13.04 | 5.33 | 0.622 | 111.7 | 3.3 | 2.4 |

| 15:17:17.016 | 209 | 47583.0 | 347.41 | 7655 | 68.82 | 1.624 | 1.344 | 2.242 | 17.88 | 21548.43 | 98.781 | 111.7 | 3.3 | 2.4 |

| 15:17:18.017 | 210 | 47237.0 | 344.66 | 7650 | 69.20 | 1.180 | 1.354 | 0.788 | 13.15 | 10.46 | 0.614 | 111.7 | 3.2 | 2.3 |

| 15:17:19.019 | 211 | 49585.0 | 361.47 | 7644 | 68.56 | 1.123 | 1.289 | 0.760 | 10.32 | 3.04 | 0.560 | 111.7 | 3.5 | 2.6 |

| 15:17:20.014 | 212 | 49637.0 | 362.10 | 7649 | 69.24 | 1.122 | 1.282 | 0.761 | 12.91 | 11.44 | 0.606 | 111.7 | 3.4 | 2.5 |

| 15:17:21.014 | 213 | 50359.0 | 367.72 | 7656 | 69.36 | 1.106 | 1.260 | 0.757 | 7.62 | 4.06 | 0.528 | 111.7 | 3.3 | 2.4 |

| 15:17:22.014 | 214 | 58828.0 | 429.43 | 7654 | 68.87 | 0.947 | 1.067 | 0.681 | 10.69 | 10.81 | 0.448 | 111.7 | 3.8 | 2.9 |

| 15:17:23.014 | 215 | 58530.0 | 427.21 | 7653 | 69.08 | 0.950 | 1.071 | 0.681 | 14.20 | 10.13 | 0.448 | 111.6 | 3.9 | 2.8 |

| 15:17:24.013 | 216 | 58600.0 | 427.09 | 7642 | 68.84 | 0.949 | 1.071 | 0.680 | 11.47 | 7.85 | 0.443 | 111.6 | 3.8 | 2.8 |

| 15:17:25.014 | 217 | 58475.0 | 427.66 | 7668 | 69.35 | 0.952 | 1.071 | 0.684 | 12.22 | 11.27 | 0.423 | 111.7 | 3.7 | 2.8 |

| 15:17:26.014 | 218 | 103778.0 | 757.13 | 7650 | 69.07 | 9.756 | 9.695 | 9.893 | 16382.82 | 16375.18 | 377.169 | 111.3 | 7.5 | 5.4 |

| 15:17:27.014 | 219 | 107946.0 | 787.68 | 7651 | 68.96 | 1.032 | 1.163 | 0.741 | 20.63 | 12.38 | 0.543 | 111.4 | 6.9 | 5.0 |

| 15:17:28.014 | 220 | 109805.0 | 802.00 | 7658 | 69.19 | 1.013 | 1.139 | 0.730 | 15.82 | 11.08 | 0.474 | 111.2 | 7.1 | 5.3 |

- В 15:25 было подано электропитание на СХД №2, через 10 минут система автоматически запустилась. В 15:38:13 автоматически запустилась синхронизация LUN’ов кластера HyperMetro (Режим работы Automatic, скорость репликации Highest). В результате было зафиксировано:

- Снижение производительности (IOPS) на 8% с 108000 до 96000, при этом значительных колебаний времени отклика от диска не обнаружено;

- Незначительные колебания загруженности процессора на контроллерах СХД с 25-30% до 40-45%;

- Загруженность SAN-линка между площадками составляет не более 4Gb/s.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| 15:38:12.014 | 1464 | 109911.0 | 802.30 | 7654 | 69.25 | 1.012 | 1.136 | 0.733 | 17.64 | 10.69 | 0.489 | 111.2 | 6.9 | 5.1 |

| 15:38:13.014 | 1465 | 108887.0 | 795.15 | 7657 | 68.85 | 1.019 | 1.142 | 0.748 | 22.16 | 10.58 | 0.487 | 111.2 | 6.9 | 5.2 |

| 15:38:14.014 | 1466 | 98237.0 | 717.75 | 7661 | 68.91 | 1.135 | 1.215 | 0.957 | 18.98 | 104.32 | 0.786 | 111.3 | 6.5 | 4.8 |

| 15:38:15.015 | 1467 | 101881.0 | 744.26 | 7660 | 68.88 | 1.094 | 1.168 | 0.930 | 11.77 | 17.60 | 0.453 | 111.4 | 6.7 | 5.0 |

| 15:38:16.018 | 1468 | 99834.0 | 729.18 | 7658 | 68.81 | 1.113 | 1.192 | 0.939 | 16.94 | 10.62 | 0.507 | 111.1 | 6.4 | 4.8 |

| 15:38:17.016 | 1469 | 100105.0 | 730.63 | 7653 | 69.23 | 1.111 | 1.188 | 0.938 | 12.70 | 11.56 | 0.464 | 111.2 | 6.7 | 5.0 |

| 15:38:18.015 | 1470 | 102534.0 | 748.59 | 7655 | 69.11 | 1.085 | 1.157 | 0.922 | 13.86 | 15.01 | 0.429 | 111.2 | 6.7 | 5.0 |

| 15:38:19.021 | 1471 | 98524.0 | 719.60 | 7658 | 69.15 | 1.130 | 1.212 | 0.946 | 25.30 | 14.14 | 0.684 | 111.4 | 6.5 | 4.8 |

| 15:38:20.014 | 1472 | 101369.0 | 740.74 | 7662 | 68.84 | 1.099 | 1.172 | 0.936 | 16.39 | 10.96 | 0.495 | 111.3 | 6.6 | 4.9 |

| 15:38:21.017 | 1473 | 101855.0 | 744.00 | 7659 | 68.90 | 1.093 | 1.168 | 0.927 | 14.93 | 12.20 | 0.455 | 111.3 | 6.8 | 5.0 |

| 15:38:22.014 | 1474 | 102042.0 | 745.22 | 7657 | 69.15 | 1.092 | 1.164 | 0.931 | 11.53 | 108.98 | 0.583 | 111.4 | 6.6 | 5.0 |

| 15:38:23.014 | 1475 | 103521.0 | 755.01 | 7647 | 68.81 | 1.076 | 1.147 | 0.921 | 13.21 | 34.92 | 0.414 | 111.5 | 6.8 | 5.0 |

| 15:38:24.014 | 1476 | 100112.0 | 730.22 | 7648 | 68.81 | 1.112 | 1.190 | 0.940 | 15.23 | 11.89 | 0.509 | 111.3 | 6.7 | 5.0 |

| 15:38:25.013 | 1477 | 97903.0 | 714.41 | 7651 | 68.80 | 1.137 | 1.221 | 0.951 | 12.59 | 10.92 | 0.539 | 111.3 | 6.5 | 4.9 |

| 15:38:26.014 | 1478 | 101654.0 | 742.79 | 7661 | 68.92 | 1.096 | 1.169 | 0.932 | 13.16 | 12.98 | 0.464 | 111.4 | 6.8 | 5.1 |

| 15:38:27.017 | 1479 | 101877.0 | 744.94 | 7667 | 68.85 | 1.091 | 1.164 | 0.929 | 17.60 | 11.23 | 0.479 | 111.2 | 6.7 | 5.0 |

| 15:38:28.014 | 1480 | 101590.0 | 741.21 | 7650 | 68.83 | 1.097 | 1.173 | 0.930 | 18.98 | 15.49 | 0.460 | 111.4 | 6.7 | 5.1 |

| 15:38:29.014 | 1481 | 101667.0 | 742.08 | 7653 | 69.34 | 1.095 | 1.169 | 0.928 | 17.03 | 10.30 | 0.431 | 111.4 | 6.5 | 4.9 |

| 15:38:30.014 | 1482 | 99765.0 | 728.72 | 7659 | 69.24 | 1.116 | 1.193 | 0.941 | 18.51 | 18.07 | 0.494 | 111.3 | 6.6 | 4.9 |

| 15:38:31.014 | 1483 | 100979.0 | 737.48 | 7658 | 69.07 | 1.103 | 1.179 | 0.934 | 15.31 | 11.18 | 0.510 | 111.4 | 6.7 | 5.0 |

| 15:38:32.014 | 1484 | 100805.0 | 735.41 | 7649 | 69.09 | 1.103 | 1.177 | 0.937 | 13.43 | 10.71 | 0.455 | 111.2 | 6.8 | 5.0 |

| 15:38:33.013 | 1485 | 93638.0 | 682.77 | 7645 | 69.10 | 1.190 | 1.208 | 1.148 | 15.30 | 104.14 | 0.566 | 111.4 | 6.4 | 4.7 |

| 15:38:34.014 | 1486 | 93641.0 | 684.09 | 7660 | 69.22 | 1.190 | 1.210 | 1.146 | 14.91 | 12.23 | 0.428 | 111.4 | 6.1 | 4.5 |

| 15:38:35.016 | 1487 | 94415.0 | 689.97 | 7662 | 69.14 | 1.181 | 1.200 | 1.139 | 14.04 | 11.42 | 0.388 | 111.5 | 6.5 | 4.9 |

| 15:38:36.014 | 1488 | 91479.0 | 667.40 | 7650 | 68.87 | 1.216 | 1.242 | 1.159 | 18.53 | 12.08 | 0.476 | 111.3 | 6.5 | 4.8 |

| 15:38:37.015 | 1489 | 92628.0 | 676.44 | 7657 | 68.93 | 1.203 | 1.224 | 1.156 | 14.73 | 12.86 | 0.515 | 111.4 | 6.4 | 4.8 |

| 15:38:38.018 | 1490 | 93541.0 | 682.33 | 7648 | 68.93 | 1.190 | 1.214 | 1.137 | 11.57 | 13.76 | 0.413 | 111.4 | 6.3 | 4.8 |

| 15:38:39.015 | 1491 | 92434.0 | 674.36 | 7649 | 68.88 | 1.206 | 1.231 | 1.150 | 11.33 | 11.21 | 0.432 | 111.4 | 6.5 | 4.9 |

- В 16:50 был завершен процесс синхронизации LUN’ов кластера HyperMetro, в результате чего было зафиксировано возвращение путей на ESXi в исходное состояние:

- Пути на гипервизорах ESXi до СХД №2 перешли в состояние Active на сервере площадки 1 и Active (I/O) на сервере площадки 2, пути до СХД №1 перешли в состояние Active на сервере площадки 2 и Active (I/O) на сервере площадки 1;

- Загруженность SAN – линка между площадками сократилась до 1Gb/s.

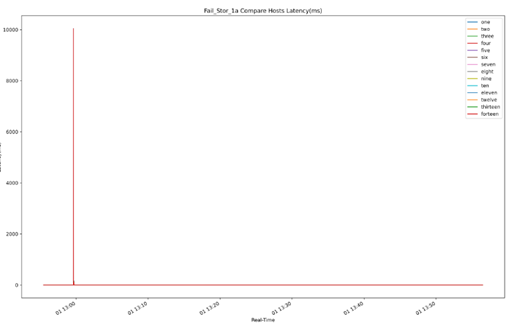

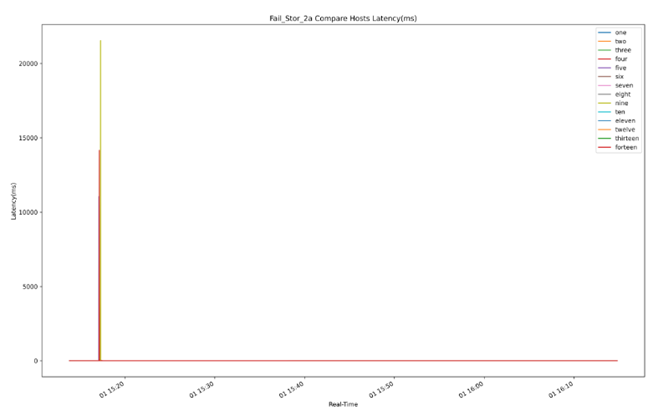

Суммарные графики IOPS, Bandwidth, latency во время отключения/включения СХД:

Графики IOPS, Bandwidth, latency во время отключения/включения СХД для ВМ:

Приложение 6. Протокол теста «Native MPIO. Влияние отказа СХД на существующую ВМ c СУБД Oracle DB (dev03)»

Для текущего теста стенд описан в Приложении 2. Выбор служебных параметров VDbench описан в Приложении 3.

Протокол теста:

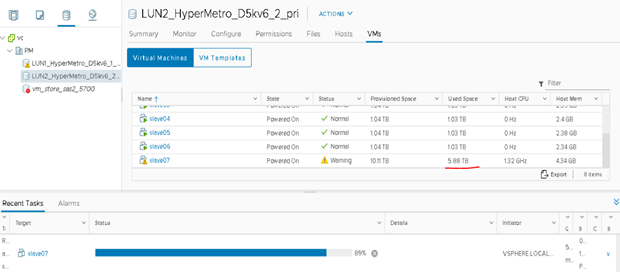

- В тестовый стенд на сервер SR650-01 и LUN LUN2_HyperMetro_D5kv6_2_pri мигрирована ВМ dev03 с СУБД Oracle DB. Preffered СХД для данного кластерного LUN является СХД №2.

- В 14:21 запущена тестовая нагрузка на ВМ dev03, дополнительно запущен VDbench для фиксации времени приостановки дискового ввода-вывода в конфигурации профиля нагрузки заказчика (Oracle DB) на 14-ти ВМ.

- В 14:34 путем полного отключения электропитания сымитирован отказ СХД №2, зафиксировано:

- Пути на гипервизорах ESXi до СХД №2 перешли в состояние Dead, пути до СХД №1 ранее находившиеся в статусе Active перешли в статус Active (I/O);

- Полная приостановка ввода-вывода к дискам ВМ на 14 секунд;

- После приостановки ввода-вывода на ВМ dev03 СУБД Oracle DBосталась доступна и работоспособна, повреждения данных не обнаружено; тестовая нагрузка продолжила свою работу, ошибок с экстренным завершением процесса не обнаружено.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| Зафиксировано полное прекращение в передаче данных на 14 сек + из-за остановки репликации выросли IOPS с 76к до 80к (5-6%) | rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | |

| 14:34:33.014 | 766 | 77452.0 | 565.76 | 7659 | 68.89 | 1.433 | 1.525 | 1.229 | 16.73 | 16.62 | 0.636 | 111.0 | 6.2 | 4.3 |

| 14:34:34.015 | 767 | 78134.0 | 570.54 | 7656 | 69.12 | 1.425 | 1.513 | 1.226 | 17.43 | 17.44 | 0.593 | 111.3 | 6.1 | 4.3 |

| 14:34:35.014 | 768 | 76334.0 | 557.61 | 7659 | 68.74 | 1.422 | 1.513 | 1.221 | 16.75 | 15.26 | 0.630 | 111.2 | 6.0 | 4.2 |

| 14:34:36.018 | 769 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.2 | 0.0 |

| 14:34:37.016 | 770 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 14:34:38.015 | 771 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.9 | 0.1 | 0.1 |

| 14:34:39.015 | 772 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.1 | 0.1 |

| 14:34:40.015 | 773 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.1 | 0.1 |

| 14:34:41.015 | 774 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.1 | 0.0 |

| 14:34:42.014 | 775 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 14:34:43.015 | 776 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.2 | 0.1 |

| 14:34:44.018 | 777 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 14:34:45.014 | 778 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.2 | 0.1 |

| 14:34:46.017 | 779 | 2.0 | 0.02 | 8192 | 100.00 | 10329.86 | 10329.86 | 0.000 | 10599.42 | 0.00 | 381.206 | 112.0 | 0.1 | 0.1 |

| 14:34:47.015 | 780 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.1 | 0.4 | 0.1 |

| 14:34:48.018 | 781 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 112.0 | 0.4 | 0.1 |

| 14:34:49.015 | 782 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 111.9 | 0.1 | 0.1 |

| 14:34:50.015 | 783 | 62506.0 | 456.91 | 7665 | 68.83 | 26.578 | 18.360 | 44.73 | 14318.94 | 14310.57 | 596.654 | 111.3 | 5.9 | 4.2 |

| 14:34:51.015 | 784 | 76590.0 | 559.14 | 7655 | 68.93 | 1.454 | 1.695 | 0.919 | 28.34 | 19.53 | 0.916 | 111.3 | 6.3 | 4.1 |

| 14:34:52.015 | 785 | 72472.0 | 529.05 | 7654 | 69.12 | 1.534 | 1.793 | 0.955 | 24.86 | 9.46 | 0.965 | 111.2 | 5.7 | 3.9 |

| 14:34:53.015 | 786 | 75317.0 | 548.99 | 7643 | 68.93 | 1.477 | 1.725 | 0.927 | 17.12 | 10.96 | 0.906 | 111.2 | 5.8 | 4.1 |

| 14:34:54.015 | 787 | 75051.0 | 547.70 | 7652 | 68.85 | 1.481 | 1.727 | 0.936 | 19.03 | 9.31 | 0.854 | 111.2 | 5.7 | 4.1 |

| 14:34:55.015 | 788 | 76383.0 | 558.08 | 7661 | 68.87 | 1.456 | 1.698 | 0.918 | 19.41 | 9.59 | 0.858 | 111.2 | 5.8 | 4.1 |

| 14:34:56.020 | 789 | 76235.0 | 556.80 | 7658 | 68.98 | 1.456 | 1.696 | 0.922 | 14.63 | 11.01 | 0.844 | 111.0 | 5.8 | 4.0 |

| 14:34:57.015 | 790 | 79820.0 | 582.22 | 7648 | 68.89 | 1.391 | 1.619 | 0.887 | 30.95 | 11.03 | 0.847 | 111.0 | 6.0 | 4.2 |

| 14:34:58.014 | 791 | 76184.0 | 556.41 | 7658 | 69.14 | 1.456 | 1.695 | 0.922 | 20.97 | 11.47 | 0.931 | 111.0 | 5.9 | 4.1 |

| 14:34:59.014 | 792 | 79511.0 | 579.27 | 7639 | 68.84 | 1.399 | 1.626 | 0.897 | 16.27 | 10.90 | 0.813 | 111.2 | 5.9 | 4.3 |

| 14:35:00.015 | 793 | 78815.0 | 574.70 | 7645 | 68.89 | 1.412 | 1.642 | 0.904 | 32.47 | 10.91 | 0.954 | 111.3 | 6.0 | 4.2 |

| 14:35:01.014 | 794 | 74434.0 | 542.82 | 7646 | 69.07 | 1.496 | 1.743 | 0.945 | 44.25 | 13.47 | 1.105 | 111.4 | 5.3 | 3.8 |

| 14:35:02.014 | 795 | 80366.0 | 586.02 | 7646 | 68.95 | 1.386 | 1.611 | 0.886 | 20.47 | 8.37 | 0.792 | 111.3 | 6.0 | 4.3 |

| 14:35:03.014 | 796 | 79506.0 | 580.18 | 7651 | 69.18 | 1.399 | 1.623 | 0.897 | 31.43 | 13.34 | 0.880 | 111.3 | 5.7 | 4.1 |

| 14:35:04.014 | 797 | 81454.0 | 594.74 | 7656 | 69.01 | 1.368 | 1.587 | 0.880 | 17.65 | 10.80 | 0.776 | 111.4 | 5.9 | 4.1 |

| 14:35:05.014 | 798 | 81264.0 | 592.75 | 7648 | 69.25 | 1.368 | 1.584 | 0.882 | 19.98 | 11.16 | 0.786 | 111.2 | 6.1 | 4.3 |

| 14:35:06.014 | 799 | 84296.0 | 615.75 | 7659 | 69.15 | 1.320 | 1.526 | 0.858 | 24.94 | 11.49 | 0.747 | 111.2 | 6.2 | 4.4 |

| 14:35:07.014 | 800 | 85549.0 | 624.10 | 7649 | 69.11 | 1.298 | 1.501 | 0.843 | 16.47 | 11.47 | 0.746 | 111.1 | 6.3 | 4.3 |

| 14:35:08.018 | 801 | 82676.0 | 603.84 | 7658 | 69.24 | 1.345 | 1.557 | 0.869 | 23.27 | 12.93 | 0.836 | 111.1 | 6.2 | 4.4 |

| 14:35:09.016 | 802 | 84485.0 | 616.35 | 7649 | 68.89 | 1.317 | 1.524 | 0.858 | 39.73 | 11.36 | 0.863 | 111.2 | 6.2 | 4.4 |

- В 14:43 было подано электропитание на СХД №2, через 10 мин. система автоматически запустилась. В 15:53:41 автоматически запустилась синхронизация LUN’ов кластера HyperMetro (Режим работы Automatic, скорость репликации Highest). В ходе синхронизации влияния на работу БД и тестовой нагрузки на ВМ dev03 не обнаружено.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| в 14_53 зафиксировано падение IOPS на 5-7 % в связи со автоматическим стартом репликации | rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | |

| 14:53:28.014 | 1901 | 85905.0 | 627.53 | 7659 | 68.94 | 1.291 | 1.421 | 1.003 | 17.18 | 11.06 | 0.573 | 110.9 | 6.7 | 4.8 |

| 14:53:29.018 | 1902 | 86278.0 | 629.41 | 7649 | 68.90 | 1.287 | 1.416 | 1.002 | 14.23 | 12.00 | 0.676 | 111.1 | 6.6 | 4.7 |

| 14:53:30.015 | 1903 | 80197.0 | 586.02 | 7662 | 69.27 | 1.378 | 1.525 | 1.047 | 36.36 | 11.01 | 0.846 | 110.5 | 6.3 | 4.4 |

| 14:53:31.017 | 1904 | 80349.0 | 585.77 | 7644 | 69.23 | 1.382 | 1.528 | 1.054 | 29.98 | 16.35 | 0.773 | 111.1 | 6.2 | 4.4 |

| 14:53:32.014 | 1905 | 85962.0 | 627.20 | 7650 | 68.96 | 1.291 | 1.420 | 1.002 | 19.68 | 10.99 | 0.559 | 110.9 | 6.6 | 4.7 |

| 14:53:33.014 | 1906 | 85299.0 | 622.45 | 7651 | 69.24 | 1.300 | 1.430 | 1.007 | 16.98 | 12.72 | 0.588 | 110.9 | 6.6 | 4.8 |

| 14:53:34.014 | 1907 | 84296.0 | 615.09 | 7651 | 69.02 | 1.318 | 1.453 | 1.019 | 18.83 | 12.32 | 0.673 | 111.1 | 6.5 | 4.6 |

| 14:53:35.017 | 1908 | 85573.0 | 624.84 | 7656 | 69.05 | 1.298 | 1.430 | 1.002 | 24.95 | 9.27 | 0.686 | 111.1 | 6.7 | 4.8 |

| 14:53:36.015 | 1909 | 85720.0 | 625.84 | 7655 | 68.92 | 1.291 | 1.424 | 0.996 | 17.06 | 9.95 | 0.598 | 110.6 | 6.5 | 4.6 |

| 14:53:37.014 | 1910 | 86422.0 | 631.12 | 7657 | 68.98 | 1.282 | 1.411 | 0.997 | 15.46 | 11.66 | 0.546 | 110.8 | 6.8 | 4.7 |

| 14:53:38.014 | 1911 | 86236.0 | 628.65 | 7643 | 68.91 | 1.287 | 1.418 | 0.998 | 16.42 | 15.14 | 0.612 | 111.0 | 6.5 | 4.7 |

| 14:53:39.015 | 1912 | 83296.0 | 608.22 | 7656 | 68.84 | 1.334 | 1.473 | 1.027 | 17.33 | 10.41 | 0.596 | 111.1 | 6.4 | 4.6 |

| 14:53:40.014 | 1913 | 85417.0 | 623.29 | 7651 | 68.99 | 1.301 | 1.431 | 1.012 | 13.00 | 11.98 | 0.565 | 111.1 | 6.4 | 4.5 |

| 14:53:41.018 | 1914 | 80172.0 | 584.75 | 7647 | 68.90 | 1.386 | 1.504 | 1.125 | 15.32 | 101.36 | 0.720 | 111.1 | 5.9 | 4.2 |

| 14:53:42.015 | 1915 | 73494.0 | 536.91 | 7660 | 69.20 | 1.511 | 1.617 | 1.274 | 45.47 | 12.39 | 0.857 | 111.1 | 5.6 | 4.0 |

| 14:53:43.014 | 1916 | 77079.0 | 562.07 | 7646 | 68.86 | 1.439 | 1.534 | 1.230 | 21.57 | 11.14 | 0.613 | 110.9 | 6.0 | 4.2 |

| 14:53:44.014 | 1917 | 77324.0 | 564.64 | 7656 | 68.90 | 1.433 | 1.523 | 1.232 | 15.40 | 15.38 | 0.593 | 110.8 | 5.8 | 4.2 |

| 14:53:45.014 | 1918 | 78073.0 | 570.74 | 7665 | 69.37 | 1.422 | 1.510 | 1.222 | 13.08 | 12.14 | 0.595 | 111.0 | 5.9 | 4.2 |

| 14:53:46.014 | 1919 | 77735.0 | 567.53 | 7655 | 69.01 | 1.431 | 1.519 | 1.235 | 13.86 | 10.32 | 0.598 | 111.3 | 6.0 | 4.3 |

| 14:53:47.021 | 1920 | 78392.0 | 571.75 | 7647 | 69.19 | 1.417 | 1.502 | 1.224 | 13.76 | 17.08 | 0.570 | 111.0 | 5.9 | 4.3 |

| 14:53:48.017 | 1921 | 78783.0 | 575.25 | 7656 | 69.24 | 1.409 | 1.496 | 1.213 | 16.02 | 11.19 | 0.574 | 111.0 | 5.9 | 4.2 |

| 14:53:49.014 | 1922 | 77437.0 | 566.00 | 7664 | 69.26 | 1.433 | 1.523 | 1.229 | 15.17 | 11.29 | 0.612 | 110.9 | 5.9 | 4.3 |

| 14:53:50.014 | 1923 | 75609.0 | 552.28 | 7659 | 68.97 | 1.470 | 1.567 | 1.253 | 38.23 | 10.97 | 0.816 | 111.1 | 5.8 | 4.1 |

| 14:53:51.014 | 1924 | 75656.0 | 552.43 | 7656 | 68.64 | 1.466 | 1.564 | 1.250 | 25.93 | 11.87 | 0.770 | 111.1 | 5.6 | 4.0 |

| 14:53:52.016 | 1925 | 78307.0 | 571.76 | 7656 | 68.94 | 1.421 | 1.515 | 1.214 | 34.71 | 12.02 | 0.767 | 111.1 | 5.9 | 4.2 |

| 14:53:53.015 | 1926 | 78138.0 | 570.70 | 7658 | 68.75 | 1.427 | 1.520 | 1.222 | 12.92 | 11.53 | 0.642 | 111.5 | 5.8 | 4.1 |

| 14:53:54.014 | 1927 | 79053.0 | 577.49 | 7659 | 68.92 | 1.406 | 1.496 | 1.206 | 14.39 | 12.78 | 0.574 | 111.1 | 5.9 | 4.2 |

| 14:53:55.014 | 1928 | 78583.0 | 574.25 | 7662 | 68.85 | 1.410 | 1.503 | 1.205 | 18.64 | 15.31 | 0.612 | 110.8 | 6.0 | 4.3 |

- В 16:15 был завершен процесс синхронизации LUN’ов кластера HyperMetro, в результате чего было зафиксировано возвращение путей на ESXi в исходное состояние:

- Пути на гипервизорах ESXi до СХД №2 перешли в состояние Active на сервере площадки 1 и Active (I/O) на сервере площадки 2, пути до СХД №1 перешли в состояние Active на сервере площадки 2 и Active (I/O) на сервере площадки 1.

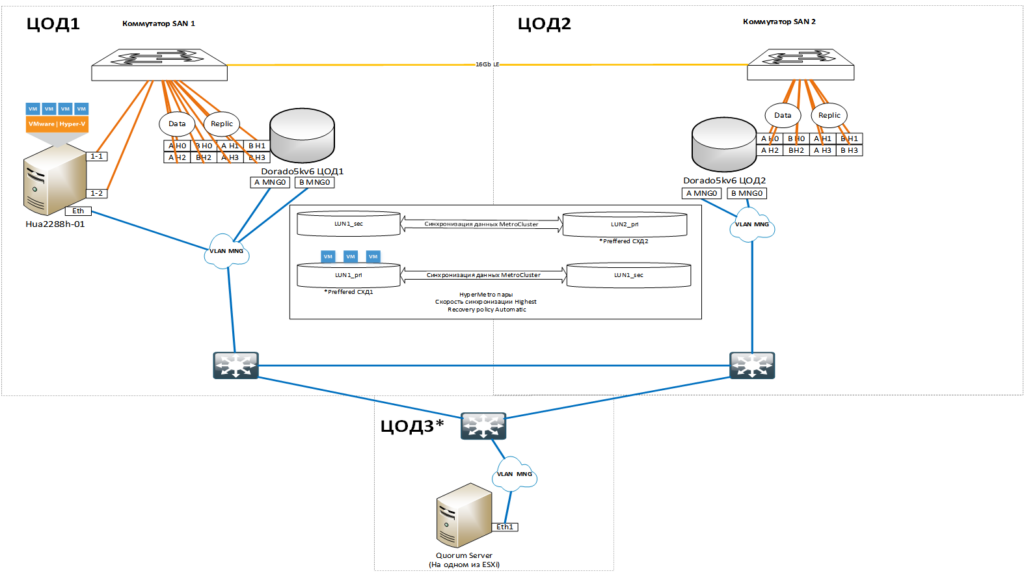

Приложение 7. Описание тестового стенда c MPIO-драйвером Huawei UltraPath

Тестовый стенд имитирует два независимых центра обработки данных, объединенных темной оптикой. В каждом центре обработки данных установлен следующий комплект оборудования:

- одна СХД Huawei Dorado5000 v6;

- один коммутатор SAN с двенадцатью 16 или 32Gb MM SFP+, c одним одномодовым SFP+;

- сервер установлен только в ДЦ №2 в следующей конфигурации:

- один сервер Huawei 2288H V5 (2288H V5 10GE SFP+) (1xCPU, 768GB RAM, 1x10GbE, 2x32Gb FC) с ОС VMware ESXi, 6.7.0, 15160138).

- на ESXi установлен драйвер OceanStor_UltraPath_21.6.3 для VMware_ESXi;

- семь ВМ VDbench (8vCPU, 24GB RAM, 16GB disk, 4x600GB тестовые диски с контроллером VMware Paravirtual SCSI).

Дополнительно на существующем оборудовании заказчика развернуты две ВМ:

- Одна для управления VDbench;

- Одна для сервера Quorum кластера Huawei HyperMetro.

Серверное оборудование обновлено последними версиями прошивок. На ESXi устанавлены версии драйверов в соответствии с таблицами совместимости Huawei.

На коммутаторах SAN настроено зонирование, обеспечивающее связь.

Описание настроек кластера Huawei HyperMetro для VMware:

- Все NVMe-диски собираны в один StoragePool в RAID5 с политикой резервирования дисков High;

- Создан HyperMetro домен из двух СХД Huawei с Quorum сервером, доступным через порты управления обоих контроллеров. Для данного домена создан отдельный пользователь на СХД. Обе СХД осуществляют репликацию через 4 выделенных порта для репликации;

- Созданы две пары LUN на СХД:

- На первой СХД – LUN1_pri и LUN2_sec по 21TB;

- На второй СХД – LUN1_sec и LUN2_pri по 21TB;

- Из этих LUN собраны две пары HyperMetro, в которых LUN1 назначена роль Preffered на первой СХД, а LUN2 – роль Preffered на второй СХД. Скорость репликации – Highest. Политика восстановления – Automatic.

- Созданные LUN презентованы хостам с одинаковым LUN ID (10 для LUN1, 11 для LUN2), которые настроены таким образом, чтобы пути к СХД, расположенной на одной площадке с сервером были выбраны как активные, а пути к уделенной СХД как резервные. Для презентации LUN хостам используются 4 выделенных порта для данных:

- На первой СХД:

- Сервер Hua2288h-01

- HyperMetro Working Mode: Local preferred mode

- OS Setting: VMware ESXi

- Host Access Mode: Asymmetric

- Preferred Path for HyperMetro: Yes

- На второй СХД:

- Сервер Hua2288h-01

- HyperMetro Working Mode: Local preferred mode

- OS Setting: VMware ESXi

- Host Access Mode: Asymmetric

- Preferred Path for HyperMetro: No

- На ESXi выставлен автоматический режим работы MPIO Huawei UltraPath:

- Сервер Hua2288h-01

- Сервер Hua2288h-01

- На первой СХД:

|

1 |

esxcli upadm set hypermetro workingmode -m auto |

Тестовые диски ВМ размещаются на Preffered LUN локальной СХД. Нумерация ВМ с 8 по 14 на Hua2288h-01.

Схема демо-стенда представлена на рисунке ниже.

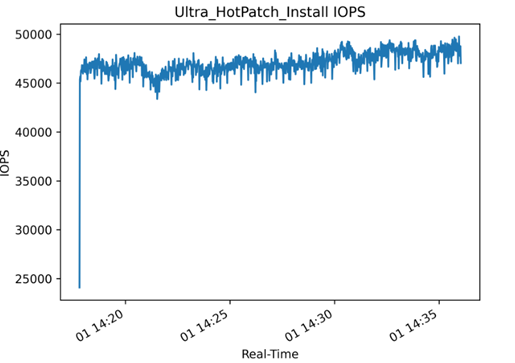

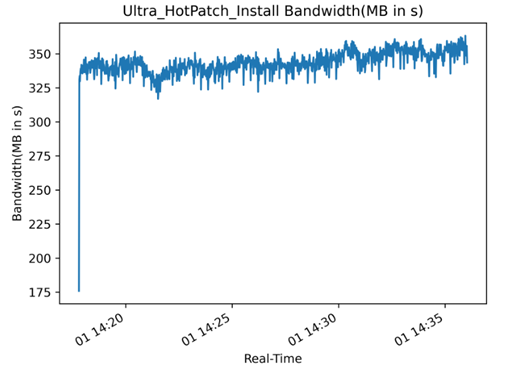

Приложение 8. Первоначальное тестирование

В ходе первоначального тестирования проводится наполнение дисков тестовых ВМ vdbench случайными данными и определяется служебный параметр – число потоков vdbench (в конфигурации профиля нагрузки заказчика) при котором достигается нагрузка с максимально оптимальным сочетанием IOPS/Latency. Данный параметр устанавливается равным 2.

Таблица тестирования с различным числом потоков.

| BlockSize | Thread | AverageIOPS | AverageLatency | AverageMBsec |

| 7653 | 1 | 51220,8 | 0,544 | 373,87 |

| 7654 | 2 | 62022,8 | 0,9 | 452,73 |

| 7654 | 4 | 62189,9 | 1,796 | 453,97 |

| 7654 | 8 | 62258,3 | 3,59 | 454,47 |

| 7654 | 16 | 62486,7 | 7,154 | 456,14 |

| 7654 | 32 | 62403,1 | 14,317 | 455,52 |

| 7654 | 64 | 62490,6 | 28,43 | 456,18 |

| 7654 | 128 | 62389,5 | 56,795 | 455,46 |

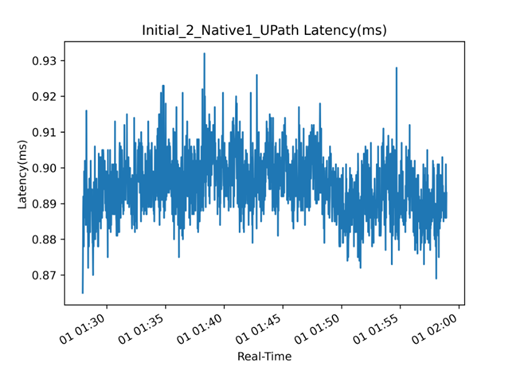

Графики IOPS, Bandwidth, latency для числа потоков = 2:

Приложение 9. Протокол теста «Huawei MPIO. Имитация отказа СХД №1»

Для текущего теста стенд описан в Приложении 6. Выбор служебных параметров VDbench описан в Приложении 6.1.

Протокол теста:

- В 10:56 запущен VDbench со следующими параметрами производительности 57k IOPS 420MB/s в конфигурации профиля нагрузки заказчика (Oracle DB) на 7-ми ВМ.

- В 10:57 сервер Quorum отключен, в интерфейсе СХД зафиксировано появление ошибки о недоступности Quorum:

- Деградации производительности не обнаружено.

- В 10:58 сервер Quorum включен, в интерфейсе СХД зафиксировано отсутствие ошибки о недоступности Quorum:

- Деградации производительности не обнаружено.

- В 11:03 путем полного отключения электропитания сымитирован отказ СХД №1, зафиксировано:

- Пути на гипервизорах ESXi до СХД №1 перешли в состояние Dead;

- Полная приостановка ввода-вывода к дискам ВМ на 13 секунд;

- После возобновления ввода-вывода, зафиксирован рост производительности (IOPS) на 2% с 57000 до 59000, при этом значительных колебаний времени отклика от диска не обнаружено.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| 11:02:52.007 | 439 | 57242.0 | 418.11 | 7659 | 68.71 | 0.975 | 0.994 | 0.932 | 16.50 | 11.86 | 0.440 | 55.8 | 2.5 | 1.8 |

| 11:02:53.007 | 440 | 57266.0 | 417.65 | 7647 | 68.81 | 0.975 | 0.992 | 0.937 | 11.47 | 14.23 | 0.394 | 55.8 | 2.4 | 1.8 |

| 11:02:54.008 | 441 | 58179.0 | 424.30 | 7647 | 69.14 | 0.961 | 0.977 | 0.925 | 18.26 | 12.50 | 0.374 | 55.9 | 2.6 | 1.8 |

| 11:02:55.007 | 442 | 57771.0 | 421.64 | 7652 | 68.88 | 0.966 | 0.985 | 0.926 | 10.95 | 14.45 | 0.349 | 55.8 | 2.4 | 1.7 |

| 11:02:56.007 | 443 | 57951.0 | 423.50 | 7662 | 69.16 | 0.964 | 0.982 | 0.926 | 11.34 | 11.62 | 0.342 | 55.9 | 2.4 | 1.8 |

| 11:02:57.008 | 444 | 58261.0 | 425.25 | 7653 | 69.04 | 0.960 | 0.976 | 0.924 | 12.23 | 11.53 | 0.364 | 55.9 | 2.6 | 1.9 |

| 11:02:58.007 | 445 | 41604.0 | 303.48 | 7648 | 68.88 | 0.973 | 0.992 | 0.930 | 9.80 | 16.20 | 0.358 | 55.9 | 2.0 | 1.5 |

| 11:02:59.009 | 446 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 11:03:00.009 | 447 | 82.0 | 0.63 | 8004 | 100.00 | 1003.11 | 1003.11 | 0.000 2 | 165.08 | 0.00 1 | 080.38 | 56.0 | 0.1 | 0.1 |

| 11:03:01.008 | 448 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.0 | 0.0 |

| 11:03:02.007 | 449 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 11:03:03.007 | 450 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.1 |

| 11:03:05.007 | 452 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 11:03:06.008 | 453 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.1 |

| 11:03:07.007 | 454 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 11:03:08.007 | 455 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 11:03:09.007 | 456 | 1.0 | 0.01 | 8192 | 100.00 | 8807.22 | 8807.22 | 0.000 8 | 807.22 | 0.00 | 0.000 | 56.0 | 0.0 | 0.0 |

| 11:03:10.007 | 457 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.0 | 0.0 |

| 11:03:11.009 | 458 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 11:03:12.007 | 459 | 5308.0 | 38.47 | 7598 | 67.92 | 133.44 | 56.10 | 297.156 11 | 857.82 1 | 4245.07 1 | 279.79 | 56.0 | 0.5 | 0.4 |

| 11:03:13.010 | 460 | 55399.0 | 404.64 | 7658 | 69.34 | 1.010 | 1.164 | 0.659 | 13.65 | 6.33 | 0.587 | 55.9 | 3.5 | 2.3 |

| 11:03:14.008 | 461 | 55272.0 | 404.55 | 7674 | 69.47 | 1.011 | 1.163 | 0.665 | 19.57 | 4.85 | 0.588 | 55.9 | 2.5 | 1.7 |

| 11:03:15.008 | 462 | 57447.0 | 419.62 | 7659 | 68.65 | 0.973 | 1.123 | 0.645 | 14.68 | 9.70 | 0.508 | 55.9 | 2.6 | 1.9 |

| 11:03:16.008 | 463 | 56160.0 | 410.22 | 7659 | 69.00 | 0.996 | 1.147 | 0.658 | 14.68 | 8.24 | 0.553 | 55.9 | 2.4 | 1.7 |

| 11:03:17.008 | 464 | 55914.0 | 408.08 | 7652 | 69.38 | 1.000 | 1.150 | 0.660 | 10.36 | 5.05 | 0.534 | 55.9 | 2.6 | 1.9 |

| 11:03:18.008 | 465 | 55523.0 | 405.55 | 7658 | 68.93 | 1.006 | 1.157 | 0.671 | 14.10 | 9.14 | 0.541 | 55.9 | 2.4 | 1.8 |

| 11:03:19.008 | 466 | 56820.0 | 414.06 | 7641 | 69.25 | 0.981 | 1.127 | 0.653 | 5.85 | 3.27 | 0.497 | 55.9 | 2.3 | 1.7 |

| 11:03:20.008 | 467 | 55732.0 | 406.37 | 7645 | 68.74 | 1.004 | 1.156 | 0.671 | 21.42 | 9.76 | 0.635 | 55.8 | 2.5 | 1.9 |

| 11:03:21.008 | 468 | 58948.0 | 429.56 | 7641 | 68.81 | 0.948 | 1.090 | 0.635 | 11.39 | 2.09 | 0.479 | 55.9 | 2.7 | 1.9 |

| 11:03:22.008 | 469 | 56811.0 | 415.52 | 7669 | 68.90 | 0.984 | 1.133 | 0.653 | 16.04 | 6.16 | 0.571 | 55.9 | 2.4 | 1.8 |

| 11:03:23.008 | 470 | 58032.0 | 423.70 | 7655 | 69.31 | 0.963 | 1.107 | 0.638 | 12.60 | 2.92 | 0.512 | 55.9 | 2.6 | 1.9 |

- В 11:10 было подано электропитание на СХД №1, через 10 минут система автоматически запустилась. В 11:22:14 автоматически запустилась синхронизация LUN’ов кластера HyperMetro (Режим работы Automatic, скорость репликации Highest), в результате чего было зафиксировано:

- Снижение производительности (IOPS) на 16% с 59000 до 49000, при этом значительных колебаний времени отклика от диска не обнаружено;

- Незначительные колебания загруженности процессора на контроллерах СХД с 25-30% до 40-45%;

- Загруженность линка SAN между площадками составляет не более 4Gb/s.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| 11:22:08.010 | 1595 | 58904.0 | 429.03 | 7637 | 68.63 | 0.948 | 1.088 | 0.641 | 36.22 | 11.07 | 0.700 | 55.8 | 2.5 | 1.9 |

| 11:22:09.008 | 1596 | 59473.0 | 434.04 | 7652 | 69.22 | 0.936 | 1.070 | 0.636 | 17.11 | 9.84 | 0.465 | 55.7 | 2.4 | 1.8 |

| 11:22:10.008 | 1597 | 58811.0 | 429.14 | 7651 | 68.81 | 0.948 | 1.087 | 0.642 | 9.66 | 2.54 | 0.465 | 55.8 | 2.6 | 1.9 |

| 11:22:11.008 | 1598 | 58640.0 | 428.61 | 7664 | 68.93 | 0.95 | 1.094 | 0.64 | 16.42 | 4.29 | 0.531 | 55.9 | 2.4 | 1.8 |

| 11:22:12.008 | 1599 | 59221.0 | 432.47 | 7657 | 68.79 | 0.944 | 1.083 | 0.637 | 19.60 | 4.37 | 0.502 | 55.9 | 2.6 | 1.9 |

| 11:22:13.008 | 1600 | 59493.0 | 434.47 | 7657 | 69.04 | 0.940 | 1.076 | 0.635 | 12.08 | 7.99 | 0.486 | 55.9 | 2.5 | 1.8 |

| 11:22:14.007 | 1601 | 52570.0 | 383.85 | 7656 | 69.32 | 1.063 | 1.137 | 0.895 | 16.14 | 101.68 | 0.647 | 55.9 | 2.3 | 1.7 |

| 11:22:15.007 | 1602 | 50158.0 | 365.77 | 7646 | 68.84 | 1.115 | 1.153 | 1.030 | 7.65 | 3.94 | 0.41 | 55.9 | 2.2 | 1.7 |

| 11:22:16.008 | 1603 | 49160.0 | 358.11 | 7638 | 69.19 | 1.138 | 1.178 | 1.048 | 12.42 | 10.98 | 0.442 | 55.9 | 2.3 | 1.7 |

| 11:22:17.008 | 1604 | 49811.0 | 363.13 | 7644 | 68.66 | 1.123 | 1.166 | 1.029 | 11.61 | 8.04 | 0.428 | 55.9 | 2.4 | 1.8 |

| 11:22:18.008 | 1605 | 49202.0 | 359.53 | 7662 | 69.51 | 1.136 | 1.177 | 1.044 | 18.33 | 12.63 | 0.461 | 55.9 | 2.4 | 1.8 |

| 11:22:19.007 | 1606 | 50652.0 | 369.72 | 7653 | 68.91 | 1.104 | 1.139 | 1.025 | 14.79 | 16.75 | 0.407 | 55.9 | 2.4 | 1.8 |

| 11:22:20.007 | 1607 | 49604.0 | 362.48 | 7662 | 69.26 | 1.126 | 1.165 | 1.039 | 12.75 | 7.09 | 0.452 | 55.9 | 2.2 | 1.6 |

| 11:22:21.008 | 1608 | 50163.0 | 365.41 | 7638 | 68.74 | 1.115 | 1.152 | 1.033 | 16.49 | 11.75 | 0.461 | 55.9 | 2.3 | 1.7 |

| 11:22:22.007 | 1609 | 49263.0 | 360.35 | 7670 | 69.04 | 1.135 | 1.174 | 1.047 | 12.70 | 12.15 | 0.486 | 55.9 | 2.2 | 1.6 |

| 11:22:23.008 | 1610 | 49301.0 | 358.62 | 7627 | 69.19 | 1.134 | 1.173 | 1.046 | 11.16 | 16.58 | 0.480 | 55.9 | 2.4 | 1.7 |

| 11:22:24.008 | 1611 | 49644.0 | 362.56 | 7657 | 68.65 | 1.125 | 1.162 | 1.043 | 16.74 | 11.76 | 0.460 | 55.8 | 2.3 | 1.6 |

| 11:22:25.008 | 1612 | 49059.0 | 358.34 | 7659 | 68.77 | 1.140 | 1.184 | 1.044 | 11.31 | 10.70 | 0.458 | 55.9 | 2.2 | 1.6 |

| 11:22:26.008 | 1613 | 49102.0 | 358.14 | 7648 | 69.04 | 1.137 | 1.177 | 1.047 | 15.21 | 11.30 | 0.489 | 55.8 | 2.2 | 1.6 |

- В 12:16 был завершен процесс синхронизации LUN’ов кластера HyperMetro, в результате чего было зафиксировано возвращение путей на ESXi в исходное состояние:

- Пути на гипервизорах ESXi до СХД №1 перешли в состояние Active;

- Загруженность линка SAN между площадками сократилась до 1Gb/s.

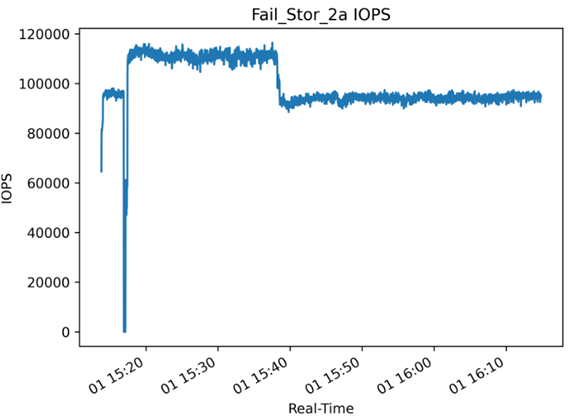

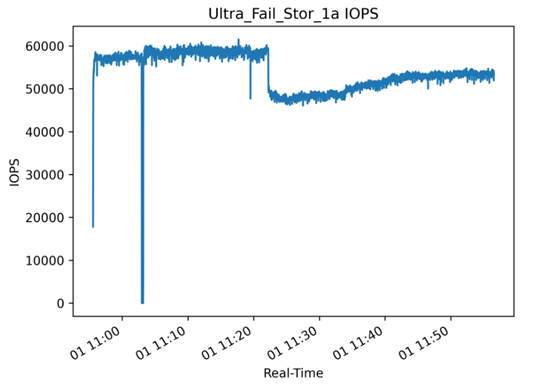

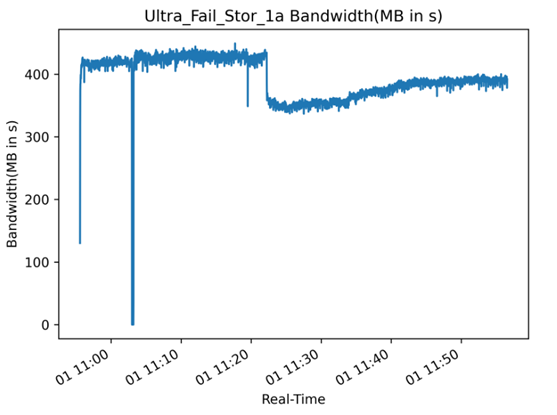

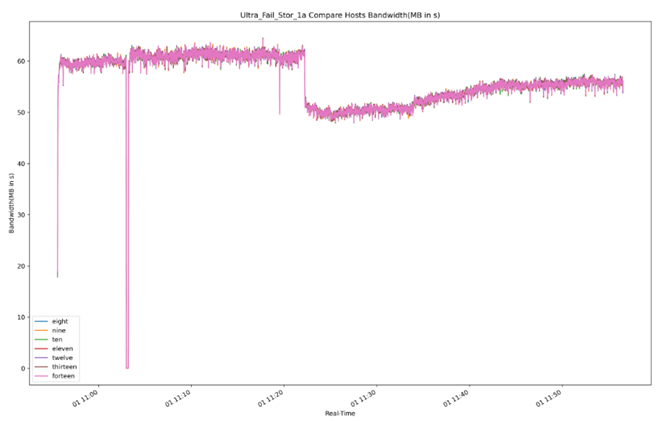

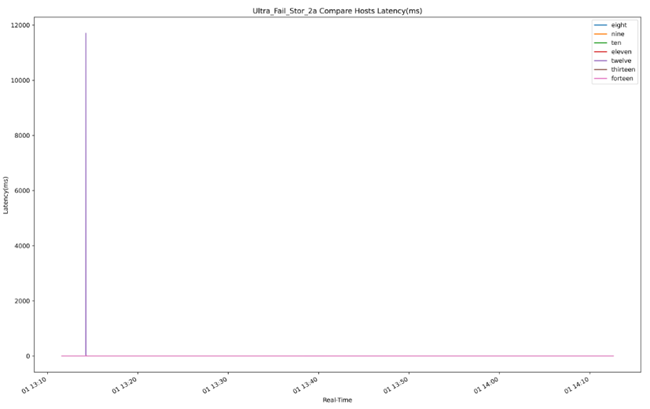

Суммарные графики IOPS, Bandwidth, latency во время отключения/включения СХД:

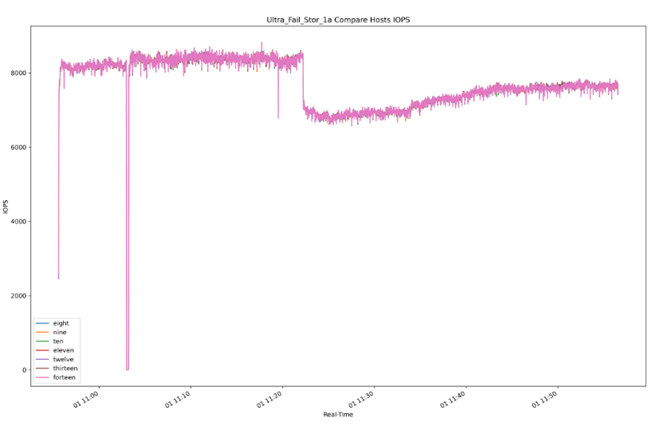

Графики IOPS, Bandwidth, latency во время отключения/включения СХД для ВМ:

Приложение 10. Протокол теста «Huawei MPIO. Имитация отказа СХД №2»

Для текущего теста стенд описан в Приложении 7. Выбор служебных параметров VDbench описан в Приложении 9.

Протокол теста:

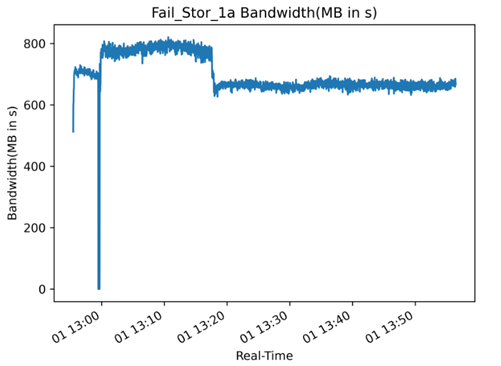

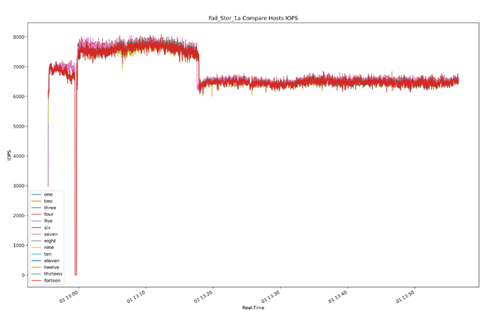

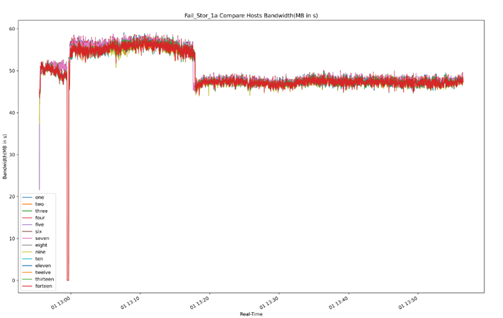

- В 13:11 запущен VDbench со следующими параметрами производительности 57k IOPS 420MB/s в конфигурации профиля нагрузки заказчика (Oracle DB) на7-ти ВМ.

- В 13:14 путем полного отключения электропитания сымитирован отказ СХД №2, зафиксировано:

- Пути на гипервизорах ESXi до СХД №2 перешли в состояние Dead;

- Полная приостановка ввода-вывода к дискам ВМ на 13 секунд, после чего, зафиксирован рост производительности (IOPS) на 16% с 55000 до 66000, при этом значительных колебаний времени отклика от диска не обнаружено.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| 13:14:03.009 | 148 | 56568.0 | 413.12 | 7657 | 69.14 | 0.988 | 1.007 | 0.94 | 16.65 | 10.49 | 0.38 | 55.9 | 2.7 | 1.9 |

| 13:14:04.009 | 149 | 55441.0 | 404.65 | 7653 | 69.44 | 1.01 | 1.04 | 0.9 | 10.98 | 12.51 | 0.46 | 55.9 | 2.6 | 1.8 |

| 13:14:05.009 | 150 | 15041.0 | 110.16 | 7679 | 69.44 | 0.99 | 1.004 | 0.94 | 7.17 | 4.87 | 0.35 | 55.9 | 0.9 | 0.6 |

| 13:14:06.014 | 151 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.0 | 0.0 |

| 13:14:07.009 | 152 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 13:14:08.009 | 153 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.0 | 0.0 |

| 13:14:09.010 | 154 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.1 | 0.1 | 0.1 |

| 13:14:10.009 | 155 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 55.9 | 0.0 | 0.0 |

| 13:14:11.010 | 156 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.1 | 0.1 | 0.1 |

| 13:14:12.009 | 157 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 55.9 | 0.1 | 0.1 |

| 13:14:13.008 | 158 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.0 | 0.0 |

| 13:14:14.009 | 159 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 13:14:15.027 | 160 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.6 | 0.0 | 0.0 |

| 13:14:16.010 | 161 | 1.0 | 0.01 | 8192 | 100.00 | 11707.89 | 11707.89 | 0.000 | 11707.89 | 0.00 | 0.000 | 55.4 | 0.0 | 0.0 |

| 13:14:17.008 | 162 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 13:14:18.008 | 163 | 0.0 | 0.00 | 0 | 0.00 | 0.000 | 0.000 | 0.000 | 0.00 | 0.00 | 0.000 | 56.0 | 0.1 | 0.0 |

| 13:14:19.008 | 164 | 35429.0 | 258.13 | 7639 | 68.86 | 22.96 | 11.56 | 48.15 | 14134.03 | 14222.77 | 552.44 | 55.9 | 1.9 | 1.3 |

| 13:14:20.008 | 165 | 55527.0 | 404.71 | 7642 | 68.96 | 1.006 | 1.127 | 0.736 | 11.02 | 4.01 | 0.474 | 55.9 | 3.0 | 1.8 |

| 13:14:21.008 | 166 | 53062.0 | 387.34 | 7654 | 69.19 | 1.054 | 1.189 | 0.751 | 12.67 | 5.28 | 0.563 | 55.9 | 2.8 | 1.9 |

| 13:14:22.008 | 167 | 53469.0 | 390.76 | 7663 | 69.19 | 1.045 | 1.177 | 0.749 | 22.82 | 5.36 | 0.594 | 55.9 | 2.6 | 1.9 |

| 13:14:23.008 | 168 | 53242.0 | 388.85 | 7658 | 69.46 | 1.051 | 1.185 | 0.746 | 13.48 | 6.54 | 0.560 | 55.9 | 2.7 | 1.9 |

| 13:14:24.008 | 169 | 52069.0 | 380.77 | 7668 | 69.47 | 1.073 | 1.200 | 0.785 | 9.94 | 9.99 | 0.498 | 55.9 | 2.4 | 1.7 |

| 13:14:25.008 | 170 | 50329.0 | 368.21 | 7671 | 68.99 | 1.111 | 1.224 | 0.858 | 11.98 | 7.78 | 0.513 | 55.9 | 2.3 | 1.6 |

| 13:14:26.007 | 171 | 50040.0 | 365.83 | 7665 | 69.34 | 1.117 | 1.242 | 0.835 | 11.30 | 2.57 | 0.522 | 55.9 | 2.1 | 1.5 |

| 13:14:27.010 | 172 | 52695.0 | 385.09 | 7662 | 68.96 | 1.062 | 1.198 | 0.759 | 12.11 | 4.36 | 0.561 | 55.9 | 2.2 | 1.6 |

| 13:14:28.009 | 173 | 55019.0 | 402.22 | 7665 | 69.43 | 1.016 | 1.142 | 0.730 | 21.22 | 4.90 | 0.535 | 55.9 | 2.5 | 1.8 |

| 13:14:29.008 | 174 | 55311.0 | 403.68 | 7652 | 69.31 | 1.010 | 1.132 | 0.735 | 12.54 | 10.55 | 0.529 | 55.9 | 2.5 | 1.7 |

| 13:14:30.008 | 175 | 56289.0 | 411.48 | 7665 | 69.29 | 0.993 | 1.114 | 0.718 | 12.66 | 3.09 | 0.457 | 55.9 | 2.6 | 1.9 |

| 13:14:31.008 | 176 | 56541.0 | 412.59 | 7651 | 68.59 | 0.989 | 1.112 | 0.718 | 17.35 | 2.48 | 0.495 | 55.9 | 2.7 | 1.9 |

| 13:14:32.008 | 177 | 57060.0 | 416.28 | 7649 | 68.68 | 0.979 | 1.101 | 0.713 | 10.45 | 2.89 | 0.452 | 55.9 | 2.6 | 1.9 |

| 13:14:33.007 | 178 | 57545.0 | 419.77 | 7648 | 69.02 | 0.971 | 1.090 | 0.707 | 13.28 | 14.46 | 0.449 | 55.9 | 2.5 | 1.8 |

| 13:14:34.007 | 179 | 58552.0 | 427.36 | 7653 | 69.03 | 0.955 | 1.067 | 0.703 | 12.15 | 7.75 | 0.424 | 55.9 | 2.6 | 1.8 |

| 13:14:35.008 | 180 | 58938.0 | 430.11 | 7652 | 68.98 | 0.948 | 1.061 | 0.697 | 9.64 | 6.33 | 0.436 | 55.9 | 2.7 | 2.0 |

| 13:14:36.010 | 181 | 58682.0 | 428.15 | 7650 | 68.85 | 0.952 | 1.065 | 0.703 | 12.24 | 3.22 | 0.454 | 55.9 | 2.8 | 1.9 |

| 13:14:37.008 | 182 | 60001.0 | 438.40 | 7661 | 69.23 | 0.932 | 1.037 | 0.697 | 10.81 | 9.52 | 0.409 | 55.9 | 3.8 | 1.9 |

| 13:14:38.008 | 183 | 59407.0 | 434.02 | 7660 | 69.18 | 0.941 | 1.050 | 0.696 | 11.76 | 9.93 | 0.453 | 55.9 | 2.3 | 1.7 |

| 13:14:39.008 | 184 | 59776.0 | 436.56 | 7658 | 69.09 | 0.935 | 1.043 | 0.693 | 11.99 | 2.95 | 0.431 | 55.9 | 4.1 | 1.9 |

| 13:14:40.009 | 185 | 59742.0 | 436.30 | 7657 | 68.84 | 0.935 | 1.044 | 0.695 | 17.22 | 9.91 | 0.456 | 55.9 | 2.8 | 2.0 |

| 13:14:41.008 | 186 | 60138.0 | 438.41 | 7644 | 68.77 | 0.929 | 1.037 | 0.692 | 13.27 | 10.68 | 0.446 | 55.9 | 2.8 | 2.0 |

| 13:14:42.008 | 187 | 59885.0 | 437.78 | 7665 | 69.32 | 0.933 | 1.039 | 0.693 | 16.37 | 9.79 | 0.450 | 55.9 | 2.5 | 1.8 |

| 13:14:43.008 | 188 | 59821.0 | 436.55 | 7652 | 68.86 | 0.934 | 1.043 | 0.694 | 12.39 | 3.10 | 0.449 | 55.9 | 2.6 | 1.8 |

| 13:14:44.008 | 189 | 62053.0 | 452.88 | 7652 | 69.00 | 0.900 | 1.010 | 0.657 | 10.98 | 10.00 | 0.438 | 55.9 | 2.5 | 1.8 |

| 13:14:45.008 | 190 | 67798.0 | 494.75 | 7651 | 69.14 | 0.824 | 0.932 | 0.584 | 16.89 | 10.96 | 0.408 | 55.9 | 2.7 | 1.9 |

| 13:14:46.008 | 191 | 68041.0 | 496.81 | 7656 | 68.98 | 0.821 | 0.929 | 0.581 | 15.08 | 11.39 | 0.418 | 55.9 | 2.9 | 2.1 |

| 13:14:47.010 | 192 | 66568.0 | 485.58 | 7648 | 68.99 | 0.839 | 0.952 | 0.588 | 47.36 | 7.08 | 0.755 | 55.9 | 3.2 | 2.3 |

- В 13:22 было подано электропитание на СХД №2, через 10 минут система автоматически запустилась. В 13:35:24 автоматически запустилась синхронизация LUN’ов кластера HyperMetro (Режим работы Automatic, скорость репликации Highest), в результате чего было зафиксировано:

- Снижение производительности (IOPS) на 16% с 66000 до 55000, при этом значительных колебаний времени отклика от диска не обнаружено;

- Незначительные колебания загруженности процессора на контроллерах СХД с 25-30% до 40-45%;

- Загруженность SAN – линка между площадками составляет не более 4Gb/s.

| Aug 14, 2020 | interval | i/o | MB/sec | bytes | read | resp | read | write | read | write | resp | queue | cpu% | cpu% |

| rate | 1024**2 | i/o | pct | time | resp | resp | max | max | stddev | depth | sys+u | sys | ||

| 13:35:17.008 | 1422 | 66577.0 | 486.37 | 7660 | 69.05 | 0.838 | 0.949 | 0.591 | 13.01 | 10.69 | 0.416 | 55.8 | 2.9 | 2.2 |

| 13:35:18.007 | 1423 | 66501.0 | 485.93 | 7662 | 69.16 | 0.839 | 0.952 | 0.588 | 15.44 | 5.02 | 0.430 | 55.8 | 2.9 | 2.1 |

| 13:35:19.007 | 1424 | 67157.0 | 489.94 | 7649 | 68.71 | 0.832 | 0.943 | 0.589 | 10.89 | 9.31 | 0.407 | 55.9 | 2.8 | 2.1 |

| 13:35:20.008 | 1425 | 66308.0 | 483.90 | 7652 | 69.18 | 0.843 | 0.955 | 0.591 | 15.36 | 3.95 | 0.427 | 55.9 | 2.7 | 2.0 |

| 13:35:21.007 | 1426 | 66555.0 | 485.98 | 7656 | 68.88 | 0.839 | 0.952 | 0.589 | 11.02 | 2.25 | 0.400 | 55.9 | 2.7 | 2.1 |

| 13:35:22.008 | 1427 | 67180.0 | 489.97 | 7647 | 68.81 | 0.831 | 0.943 | 0.586 | 10.87 | 9.86 | 0.404 | 55.8 | 2.8 | 2.1 |

| 13:35:23.007 | 1428 | 65991.0 | 481.30 | 7647 | 68.99 | 0.845 | 0.960 | 0.589 | 9.96 | 9.39 | 0.434 | 55.8 | 2.6 | 2.0 |

| 13:35:24.007 | 1429 | 57036.0 | 416.56 | 7658 | 69.21 | 0.979 | 1.015 | 0.900 | 10.75 | 104.95 | 0.725 | 55.9 | 2.5 | 1.9 |

| 13:35:25.007 | 1430 | 55709.0 | 406.16 | 7644 | 68.97 | 1.003 | 1.018 | 0.971 | 11.80 | 11.35 | 0.375 | 55.9 | 2.6 | 1.9 |

| 13:35:26.007 | 1431 | 54863.0 | 399.85 | 7642 | 68.54 | 1.018 | 1.035 | 0.982 | 11.37 | 11.34 | 0.402 | 55.8 | 2.5 | 1.9 |

| 13:35:27.007 | 1432 | 55112.0 | 402.72 | 7662 | 69.04 | 1.013 | 1.029 | 0.977 | 13.07 | 8.76 | 0.420 | 55.8 | 2.3 | 1.7 |

| 13:35:28.007 | 1433 | 55488.0 | 404.75 | 7648 | 68.65 | 1.005 | 1.020 | 0.972 | 12.09 | 11.10 | 0.382 | 55.8 | 2.5 | 1.8 |

| 13:35:29.007 | 1434 | 54963.0 | 401.55 | 7660 | 69.08 | 1.017 | 1.034 | 0.978 | 11.52 | 9.94 | 0.409 | 55.9 | 2.6 | 2.0 |

| 13:35:30.007 | 1435 | 55591.0 | 405.77 | 7653 | 68.84 | 1.006 | 1.019 | 0.976 | 11.07 | 15.70 | 0.366 | 55.9 | 2.4 | 1.8 |

| 13:35:31.007 | 1436 | 55593.0 | 405.92 | 7656 | 68.61 | 1.004 | 1.019 | 0.971 | 14.32 | 10.01 | 0.376 | 55.8 | 2.4 | 1.8 |

| 13:35:32.007 | 1437 | 55107.0 | 402.44 | 7657 | 68.96 | 1.014 | 1.030 | 0.977 | 10.58 | 10.87 | 0.372 | 55.9 | 2.4 | 1.8 |

| 13:35:33.007 | 1438 | 55189.0 | 402.94 | 7655 | 68.84 | 1.012 | 1.028 | 0.976 | 17.11 | 10.74 | 0.401 | 55.9 | 2.3 | 1.7 |

| 13:35:34.007 | 1439 | 54306.0 | 396.32 | 7652 | 68.88 | 1.029 | 1.047 | 0.989 | 10.65 | 10.62 | 0.409 | 55.8 | 2.5 | 1.9 |

- В 14:26 был завершен процесс синхронизации LUN’ов кластера HyperMetro, в результате чего было зафиксировано возвращение путей на ESXi в исходное состояние:

- Пути на гипервизорах ESXi до СХД №2 перешли в состояние Active;

- Загруженность SAN – линка между площадками сократилась до 1Gb/s.

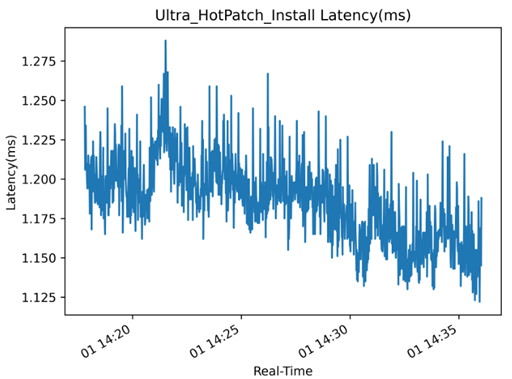

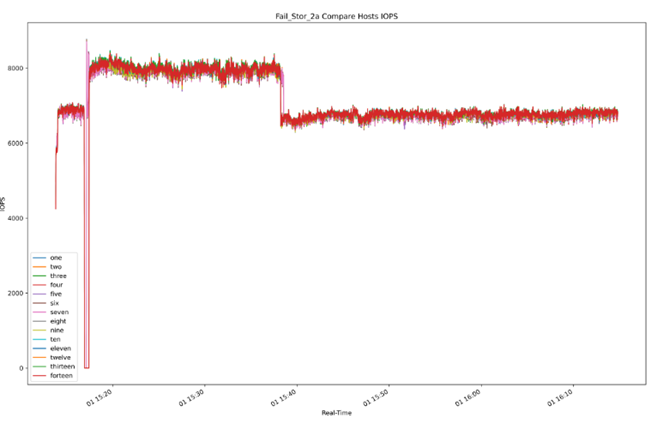

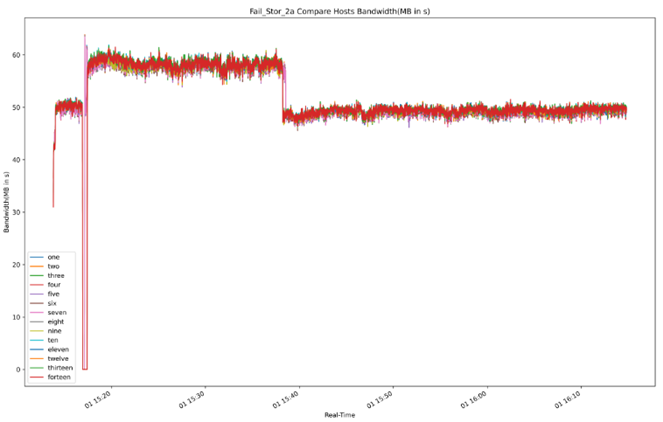

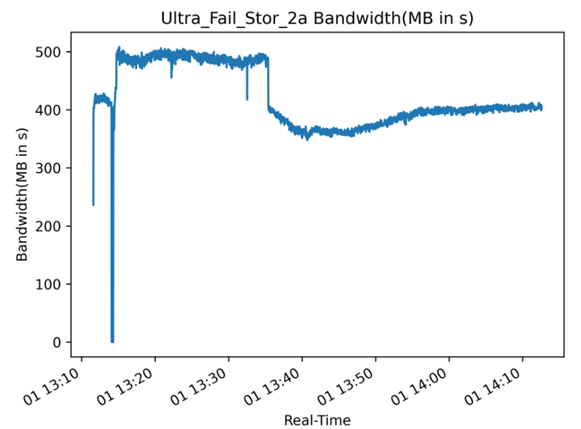

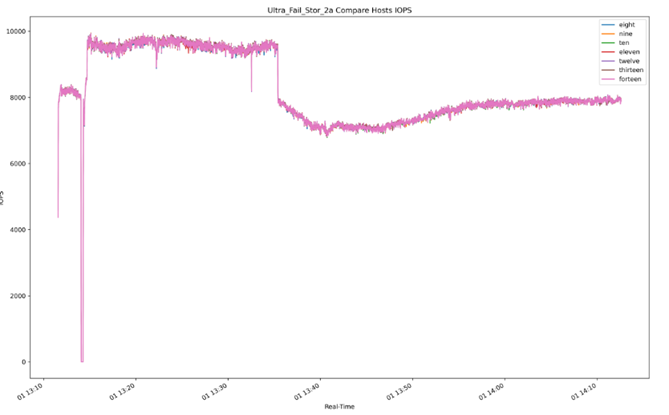

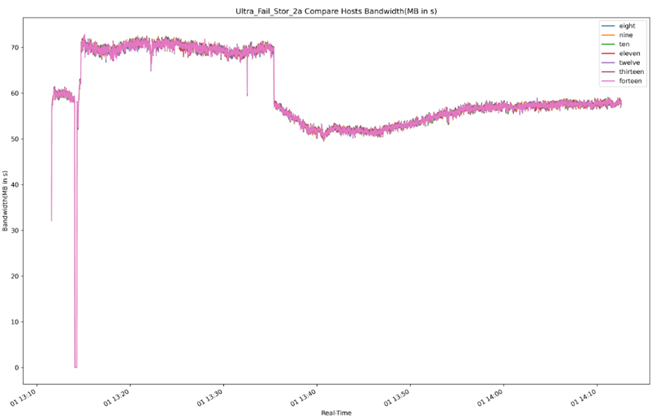

Суммарные графики IOPS, Bandwidth, latency во время отключения/включения СХД:

Графики IOPS, Bandwidth, latency во время отключения/включения СХД для ВМ:

Графики IOPS, Bandwidth, latency во время отключения/включения СХД для ВМ:

Приложение 11. Протокол теста «Native MPIO-драйвер. Влияние функции виртуализации СХД Huawei на производительность»

Приложение 11. Протокол теста «Native MPIO-драйвер. Влияние функции виртуализации СХД Huawei на производительность»

За основу взят стенд, описанный в Приложении 2 со следующими корректировками:

- В сети SAN добавлены зоны от сервера SR650-1 до существующей СХД VNX5700 и от СХД Huawei Dorado 5000v6 №2 до существующей СХД VNX5700;

- С СХД VNX5700 вышеуказанному оборудованию был презентован LUN на 8TB.

Протокол теста:

- Том с СХД VNX5700 на ESXi сервере SR650-1 форматируется в VMFS. Каждой из семи тестовых ВМ VDbench, расположенных на сервере SR650-1, выделяется один диск на 1TB на данном VMFS Datastore;

- Запускается тестирование, в ходе которого проводится наполнение дисков тестовых ВМ vdbench случайными данными и определяется служебный параметр – число потоков vdbench (в конфигурации профиля нагрузки заказчика), при котором достигается нагрузка с максимально оптимальным сочетанием IOPS/Latency. В ходе первоначального тестирования данный параметр устанавливается равным 4.

Таблица тестирования с различным числом потоков:

| TestName | IOPS | MBsec | AverageRespTime | RespTime<1ms | RespTime>1ms<2ms | RespTime>2ms<4ms | RespTime>4ms |

| Initial_1_Native1_Virt | 1820,8 | 13,29 | 3,83 | 31,5702 | 1,2344 | 20,3022 | 46,8932 |

| Initial_1_Native2_Virt | 1809,5 | 13,21 | 3,854 | 31,6028 | 1,2138 | 20,203 | 46,9804 |

| Initial_1_Native3_Virt | 1815,5 | 13,25 | 3,842 | 31,6535 | 1,1844 | 20,2211 | 46,941 |

| Initial_2_Native1_Virt | 3115,8 | 22,74 | 4,48 | 31,5352 | 0,8479 | 16,6688 | 50,9481 |

| Initial_2_Native2_Virt | 3074 | 22,44 | 4,541 | 31,5038 | 0,837 | 16,3411 | 51,3181 |

| Initial_2_Native3_Virt | 3070 | 22,41 | 4,547 | 31,515 | 0,8259 | 16,3966 | 51,2625 |

| Initial_4_Native1_Virt | 4891,1 | 35,71 | 5,714 | 30,4533 | 1,0372 | 12,8924 | 55,6171 |

| Initial_4_Native2_Virt | 4879,5 | 35,62 | 5,727 | 30,4191 | 1,0421 | 12,7068 | 55,832 |

| Initial_4_Native3_Virt | 4873,8 | 35,58 | 5,734 | 30,4468 | 1,0327 | 12,6609 | 55,8596 |

| Initial_8_Native1_Virt | 5088,9 | 37,15 | 10,991 | 0,3765 | 1,0297 | 5,6413 | 92,9525 |

| Initial_8_Native2_Virt | 5067 | 36,98 | 11,039 | 0,3871 | 1,0242 | 5,6161 | 92,9726 |

| Initial_8_Native3_Virt | 5079,8 | 37,08 | 11,011 | 0,3707 | 1,038 | 5,6303 | 92,961 |

| Initial_16_Native1_Virt | 5072,7 | 37,03 | 22,064 | 0 | 0 | 0 | 100 |

| Initial_16_Native2_Virt | 5084,6 | 37,12 | 22,013 | 0 | 0 | 0 | 100 |

| Initial_16_Native3_Virt | 5083,6 | 37,11 | 22,017 | 0 | 0 | 0 | 100 |

| Initial_32_Native1_Virt | 5068,1 | 36,99 | 44,183 | 0 | 0 | 0 | 100 |

| Initial_32_Native2_Virt | 5079,6 | 37,08 | 44,083 | 0 | 0 | 0 | 100 |

| Initial_32_Native3_Virt | 5065,8 | 36,98 | 44,203 | 0 | 0 | 0 | 100 |

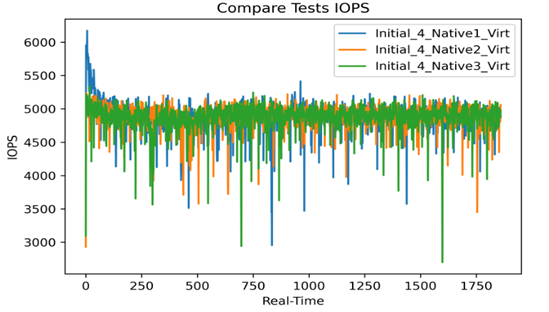

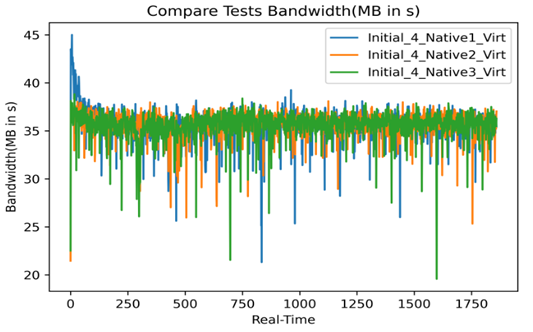

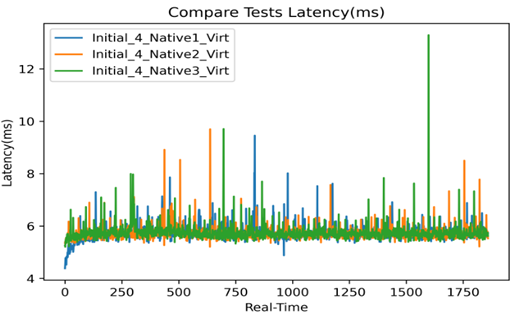

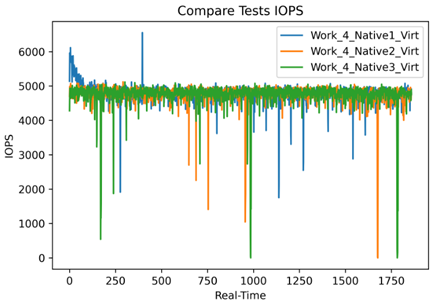

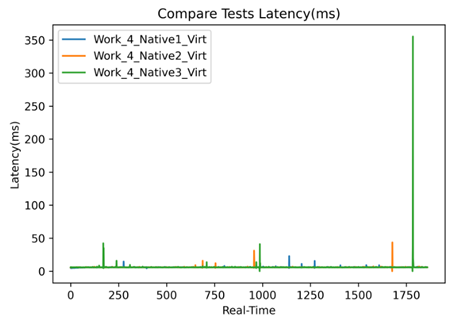

Графики IOPS, Bandwidth, latency для числа потоков = 4 для трех первоначальных тестов:

- Том СХД VNX5700 на ESXi сервере SR650-1 отсоединяется, виртуализуется через СХД Huawei Dorado 5000v6 №2 и вновь презентуется серверу c LUN ID аналогичным СХД VNX5700. Виртуализованный том монтируется на ESXi с опцией «Keep existing signature» с прежним именем Datastore;

- Проводится повторное тестирование с установленным ранее числом потоков. В результате сравнения результатов:

- Зафиксировано незначительное увеличение времени отклика на 2%, с 5,72 до 5,86, также зафиксированы всплески во времени отклика;

- Зафиксировано незначительное ухудшение производительности (IOPS) на 2%, с 4881 до 4764.

Результаты тестирования:

| TestName | IOPS | MBsec | Average RespTime |

RespTime<1ms | RespTime>1ms<2ms | RespTime>2ms<4ms | RespTime>4ms |

| Work_4_Native1_Virt | 4787,9 | 34,95 | 5,837 | 27,7205 | 4,007 | 11,0207 | 57,2518 |

| Work_4_Native2_Virt | 4760,8 | 34,75 | 5,87 | 27,761 | 3,9537 | 11,0475 | 57,2378 |

| Work_4_Native3_Virt | 4746,9 | 34,65 | 5,887 | 27,6923 | 4,0415 | 10,9868 | 57,2794 |

Графики IOPS, Bandwidth, latency:

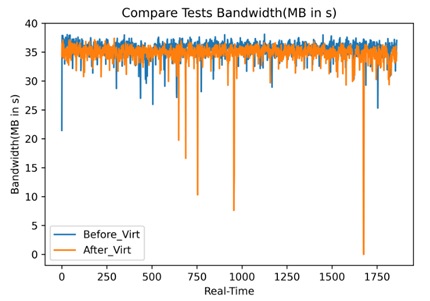

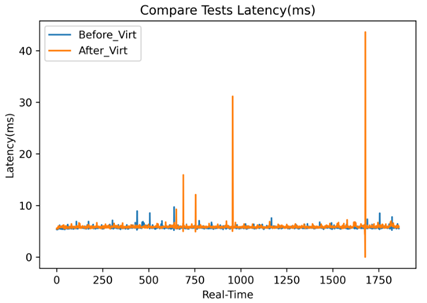

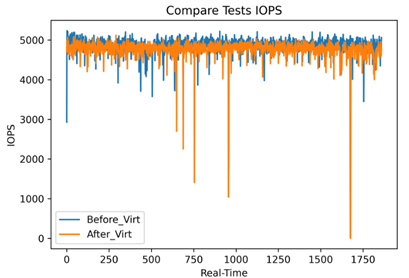

Графики IOPS, Bandwidth, latency со сравнением до и после виртуализации:

Приложение 12. Протокол теста «Native MPIO. Влияние процесса создание и удаления моментальных снимков (снапшотов) на производительность ВМ»

Для текущего теста стенд описан в Приложении 2. Выбор служебных параметров VDbench описан в Приложении 3.

Протокол теста:

- В тестовом стенде на сервере SR650-01 на ВМ slave07 (8xCPU, 96GB Memory, 16GB System Disk) был создан тестовый диск размером 5TB, который был наполнен случайными данными;