Коллеги поделились решением проблемы установки ESXi на HPE Superdom в режиме Boot from SAN.

—

У нас есть партиция Superdom из двух лезвий gen8, процессоры серии Intel Xeon E7-2800 v2 и HBA Qlogic HP QMH2672 16Gb с версией fw 8.07.16.

Я хотел установить туда HPE ESXi 6.0u3 (preGen9), так как именно она является последней поддерживаемой версией по данным матриц совместимости HPE и VMware.

При установке столкнулся с тем, что Wizard не видит презентованный диск для установки в режиме Boot from FC SAN.

Рядом стоит точно такая же партиция, состоящая из одного лезвия с такой же HBA. Проблем при установке ESXi там не было.

В поисках решения я перепробовал все сборки HPE’шных образов ESXi (а также оригинальных) – только HPE 6.7U1 увидел диск для установки, но его поставить нельзя 🙂

Я начал сравнивать драйверы для QMH2672 в различных образах ESXi и выяснил, что:

- в 6.7 U1 драйвер версии 3.1.16;

- в 6.5 U2 – 2.1.81;

- в 6.0 U3 – 2.1.50.

В VMware HCL написано, при HBA с прошивкой 8.07.xx в ESXi 6.0U3 должны работать версии драйвера от 2.1.63 до 2.1.70.

Странно – на первую патрицию успешно установился ESXi с версией драйвера 2.1.50, которая отсутствует в HCL 🙂

Затем я попробовал собрать свой образ с драйвером 3.1.16 из offline bundle, но при сборке получил ошибку зависимости, которой нет в 6.0. Не зря этот драйвер входит только в дистрибутив 6.7 😉

На всякий случай, для чистоты эксперимента я снес все зоны и сделал только зонинг только на одну систему хранения, где расположен загрузочный LUN.

УРА! После перезагрузки хост успешно увидел LUN для установки 🙂

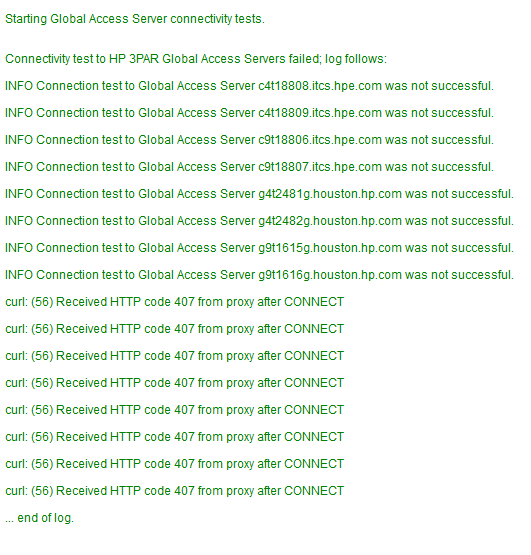

Продолжив эксперименты, я нашел причину такого поведения – HPE StoreOnce!!!111

В ESXi до версии 6.7 существует ограничение в 1024 пути. Catalyst, расположенный на StoreOnce, с лихвой переполнял это ограничение.

И только в ESXi 6.7 количество возможных путей увеличено до 4096, вследствие чего хост нормально видел загрузочный лун!