Так уж вышло, что я работаю в компании, являющейся счастливым обладателем HP Data Protector 8.0. Я уже ранее сравнивал его с Veeam при резервном копировании виртуальных машин VMware. Сейчас же я хочу рассказать про свой опыт резервного копирования файл-серверов.

Category: Hardware

Проброс видеокарты NVIDIA в VMware ESXi 6.0

diz решил поделиться своим опытом проброса видеокарты NVDIA GTX в ESXi 6.0.

Добрый день, дорогие друзья!

Говорят, что с 2015-ого года работодатели стали сразу выгонять с собеседования ИТ-шников, если вдруг выясняется, что у них нет личного сервера с развернутым частным облаком.

Чтобы не выбиваться из тренда, я собрал дома небольшой двухпроцессорный сервер на базе материнской платы SUPERMICRO X9DRI-F и пары Xeon E5-2670. Т.к. несколько лет своей жизни я посвятил, в т.ч. администрированию инфраструктуры VMWare, то в качестве гипервизора виртуализации был выбран именно ESXi.

Частное облако-домашняя лаба – это, конечно, замечательно и здорово, однако, для комфортной повседневной работы и StarCraft2 желательно иметь доступ к дискретной видеокарте.

Тому, как задружить “бытовую” nVidia GTX и ESXi 6 и посвящается данная статья – краткий проводник-путеводитель по граблям.

Первое, что вам захочется сделать после установки дискретной видеокарты в сервер – переключить приоритет инициализации видеокарты в BIOS в пользу внешней, чтобы видеть POST прямо на экране подключенного к ней монитора. Этого делать не стоит, т.к. в таком случае вы потеряете возможность использовать iKVM материнской платы.

Итак, приступаем к пробросу видеокарты в виртуальную машину с MS Windows 10. Увидев web-интерфейс ESXi 6 я искренне обрадовался тому, что завязал с системным администрированием четыре года назад. Откладываем этот замечательный интерфейс в сторону, т.к. проброс видеокарты через него вы настроить не сможете, при старте виртуальная машина будет ругаться на несоответствие идентификатора устройства PCIe (PCIe passthrough device id invalid) и переключаемся на старый добрый и толстый клиент: Continue reading “Проброс видеокарты NVIDIA в VMware ESXi 6.0”

IBM HS23, vSphere и 10 GbE. Борьба продолжается…

В 2013 году столкнулись с парой проблем с сетевыми картами Emulex 10 GbE – одна проблема описана в статье IBM HS23, vSphere и 10 GbE, вторая была – неожиданная сетевая изоляция хостов.

Спустя 3 года ситуация повторяется – хост внезапно уходит в сетевую изоляцию. Подозрения сразу пали на сетевую карту Emulex.

Подтверждение проблемы обнаружено в логе vmkernel.log:

|

1 2 |

WARNING: elxnet: elxnet_detectDumpUe:275: [vmnic3] UE Detected!! elxnet: elxnet_detectDumpUe:287: 0000:16:00.5: Forcing Link Down as Unrecoverable Error detected in chip/fw. |

Некие намёки в БЗ VMware:

- ESXi 5.5/6.0 hosts running Emulex HBAs become unresponsive in vCenter Server during periods of high I/O

- Packet drops and connectivity issues when using Emulex elxnet Driver version 10.2.298.5 or earlier on OCe10102 and OCe11102 adapters or OEM equivalents

Заметка в бложике:

ESXi 5.5 and Emulex OneConnect 10Gb NIC

В качестве решения – замена прошивки, обновление драйвера.

Вдогонку за кроликом или fiber-channel, linux и много-много google

Эта статья описывает муки настройки fiber channel target поверх Centos.

Коллегам, хорошо разбирающимся в линукс, можно читать в качестве анекдота 🙂

Continue reading “Вдогонку за кроликом или fiber-channel, linux и много-много google”

Подсчет стоимости виртуальной машины

Mr. Nobody нашел симпатичную статью про то, сколько же стоит виртуальная машина.

Переведу 🙂

Сколько стоит виртуальная машина? Хотя вопрос и простой, ответ на него может оказаться гораздо сложнее, так как требует понимания стоимости вычислений, количества ресурсов и ожидаемых потребностей в вычислительных мощностях.

Хотя разговор о стоимости лучше оставить экономистам, именно у ИТ есть все данные, необходимые для точных вычислений, являющихся основой для процедур оценки. Давайте разберем пример.

Пара мыслей про HP StoreOnce Catalyst

Не реклама :)))))

В комментариях готов обсудить, чем данное средство лучше/хуже самосбора на базе кучи дисков с дедупликацией…

В качестве хранилища резервных копий пару лет назад мы выбрали HP StoreOnce 4700. Выбор был обусловлен тем, что наше средство резервного копирования хорошо заточено на ленты, и мы достаточно продуктивно ранее работали с HP VLS 6500. StoreOnce отличается достаточно высокой ценой, при этом обладает рядом преимуществ:

- встроенная дедупликация и неплохие показатели скорости резервного копирования (до 8 Тб/час на 8 дисковых полок или примерно 16Гбит/с – для 4700);

- дополнительно приобретаемая лицензия репликации, которая интегрируется с дедупликацией;

- дополнительная лицензия Catalyst, позволяющая осуществлять дедупликацию перед передачей данных на StoreOnce. Заявлена скорость резервного копирования до 22Тб/ч; :))

- централизованная и, вроде бы, удаленная поддержка от вендора

Помимо достаточно негуманного ценника за аппаратное решение, есть программные версии до 50Тб, в том числе и бесплатная – на 1 Тб, разворачиваемые в виде виртуальных машин vSphere, Hyper-V и KVM.

В программных решениях все дополнительные лицензии включены (репликация), но производительность значительно ниже (до 120Мб/с).

В нашей поставке StoreOnce выглядит как HP’шный сервер и две дисковые полки (2*2Тб*12). Используемой емкости внутри порядка 37Тб.

Обновление прошивки MSA P2000 G3 и закрытие бэкдора

Дошли руки обновить прошивку MSA P2000 G3 до TS252R007.

Обновилось все замечательно, вот только после обновления отмер веб-интерфейс.

Поддержка сказала, что это не баг, а фича, и дала ссылку про то, что покрошился сертификат.

Команда show certificate показала, что действительно оба контроллера сидят с непойми чем.

Вот только выполнение рекомендаций на контроллере A мне не помогло – сертификат не пересоздался. Выполнение рекомендаций на контроллере B – частично помогло – пересоздался сертификат только на контроллере B.

# show certificate

Certificate Status

——————

Controller: A

Certificate Status: Unknown status

Time Created:

Certificate Text: none

Certificate Status

——————

Controller: B

Certificate Status: System-generated

Time Created: 2015-09-02 22:15:58

Certificate Text: Certificate:

Техподдержка радостно предлагает засунуть сертификат на контроллер через FTP (ВАУ) 🙂

Временно включил по их совету доступ через HTTP, чтобы проверить работоспособность веб-служб.

Сертификат через FTP не засовывается.

Помогло отключение NTP и сброс таймзоны

#set controller-date ntp disabled timezone 0

Пересоздаем сертификат

#create certificate unique both

Перезагружаем Management Controllers

# restart mc both

2) Закрыл бакдор, описанный тут.

У MSA’шки есть пользователь admin с паролем !admin.

Может зайти телнетом, web и так далее.

Для смены пароля необходимо зайти в шелл.

# set password admin

Enter new password: ****************************

Re-enter new password: ****************************

Success: Command completed successfully. (admin) — The password was changed.

3) Попутно решил обновить прошивку дисков, но невнимательно читал гайд: прошивка дисков осуществляется БЕЗ нагрузки на СХД. Один из гипервизоров потерял лун с VMFS, размещенный на этих дисках – помог только ребут гипервизора.

Увеличение размера диска HP Smart Array P400i

Жил-был сервер HP DL360 G5 с рейд-контроллером HP Smart Array P400i и двумя дисками HP 68GB, объединенными в Raid1.

И так достала нас нехватка места на дисках, что решили мы заменить диски на HP 146GB.

Воткнули один диск 146Гб вместо старого, дождались синхронизации. Воткнули второй – дождались ребилда рейд-массива.

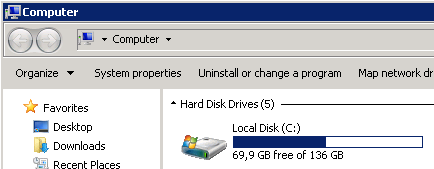

Получили два диска 146Гб в Raid1, на которых занята примерно половина места.

Тыкаемся в HP Array Control Utility, а увеличения размера логического рейд-диска нет.

Обновил прошивку рейд-контроллера и утилиту – не помогло.

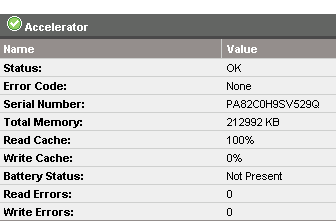

Начал гуглить – народ утверждает, что увеличение размера логического рейд-диска доступно при наличии батарейки. Посмотрел через HP System Management Homepage – батарейки нет.

Поставили батарейку, она зарядилась, и мы смогли расширить диск.

Veeam B&R v8, v9 и HP StoreOnce

Сегодня я хочу рассказать две вещи про Вим.

1) В этом году компания Veeam обещает выпустить девятую версию своего флагманского продукта – Backup and Replication. Больше всего из заявленного функционала мне нравится запись на ленты в несколько приводов и консоль администрирования сервера. Я тестировал запись на свои ленты в v7 и v8 – скорость записи на один привод удручает. 🙁

А если бы Вим научился работать с лентами напрямую, минуя жесткий диск, то и мечтать о большем было бы не нужно. Я, конечно, понимаю, что у всех разные ситуации, но у меня ситуация такая, что есть много терабайт в VTL или MSL и немного терабайт на СХД. И мне как раз актуальнее система резервного копирования, которая умеет работать с лентами напрямую. Прямо сейчас это освободило бы мне десяток терабайт…

2) А еще я протестировал работу механизма Backup Copy в Veeam Backup and Replication v8, призванного реализовать схему GFS (дед, отец, сын) для резервного копирования.

Смысл этого механизма в том, чтобы на регулярной основе “откладывать” в сторону недельные, месячные, квартальные и годовые резервные копии на другое хранилище.

В отличие от обычного бэкапа на ленту (Backup to Tape) – это обыкновенный бэкап, который вы спокойно можете использовать для восстановления данных.

Мне интересно было проверить работу этой схемы, после постановки задачи по наличию месячных резервных копий за последние полгода. Чтобы не заниматься долгим процессом восстановления (бэкапа с ленты -> почтовых баз Exchange из бэкапа -> Clean Shutdown -> восстановления информации из базы в пользовательский ящик) я решил посмотреть – получится ли у меня отложить месячную резервную копию и использовать ее в Veeam Explorer for Exchange.

В качестве репозитория была подключена сетевая папка с системы HP StoreOnce 4500 с функционалом дедупликации.

Для повышения эффективности “аппаратной” дедупликации Veeam складывает на папку бэкап в несжатом состоянии. Такой функционал есть при архивации на HP StoreOnce и EMC Data Domain. Это можно заметить, сравнив размер полной резервной копии на StoreOnce и на обычном хранилище. Я же хочу поделиться цифрами по двум месячным резервным копиям для почты и виртуальных машин.

– два бэкапа Exchange. На StoreOnce лежат два файла: 5,7Тб и 4,5Тб. Полная резервная копия и инкремент до следующей месячной копии. Согласно данным в консоли StoreOnce: User Data – 11,3Тб; Data on Disk = 5,2Tb. Одна полная копия Exchange на обычном хранилище (то есть с сжатием и дедупликацией от Veeam) – 5Тб.

– два бэкапа виртуальной инфраструктуры. На StoreOnce лежат два файла: 3,9Тб и 1,5Тб. Аналогично – Full+Incr. Согласно данным в консоли StoreOnce: User Data – 5,9Тб; Data on Disk = 1,7Tb. Одна полная копия инфраструктуры на обычном хранилище – 2,2Тб.

Я считаю, цифры просто фантастичны. HP StoreOnce круче дедуплицирует, чем Veeam 🙂

Лицензирование Oracle под VMware vSphere

Доля тяжёлых RISC-системы падает (из RISC-овых архитектур растёт только ARM), а вот x86 занимает всё больше ниш, в том числе с такими ресурсоёмкими приложениями, как Oracle DB.

На данный момент у меня Oracle DB работает на серверах с архитектурой IBM Power7. Данная платформа имеет отличную фишку по экономии средств на лицензирование СУБД за счет использования hard partitioning в соответствии с Oracle Partitioning Policy. При создании виртуальной машины (LPAR) в IBM PowerVM достаточно указать, что процессоры “выделенные” (Dedicated), не разрешать живую миграцию (Live Partition Mobility) и спокойно можно использовать 10 лицензий на 16 ядерном сервере.

А вот на плаформе x86 с политикой лицензирования Oracle полная каша. Возникает вопрос в определении – что используется в текущий момент soft или hard partitioning? Ответ не так прост, так как всё зависит от настроек.

Честный hard partioning на платформе x86

Вариантов мне известно два:

- Использование серверов Fujitsu или Hitachi с функцией logical partitioning.

- Отключить процессор в BIOS/UEFI.

Hard partioning на платформе x86 для своих

Использование CPU Affinity в Oracle VM. Также рекомендую статью Hard and Soft Partitioning with Oracle VM.

Для Microsoft Azure разрешена license mobility.

Альтернативное лицензирование

Специальная политика лицензирования для облачных провайдеров.

Как превратить soft partitioning в hard при использовании VMware vSphere?

VMware выпускает специальный документ Understanding Oracle Certification, Support and Licensing for VMware Environments, который даёт ответ, что использованиие CPU Affinity по аналогии с Oracle VM позволяет лицензировать под Oracle DB только используемые ядра.

Юридическая сторона вопрос разобрана специалистами компании House of Brick Technologies, занимающейся аудитом использования лицензий, в статье Oracle Licensing: Soft Partitioning on VMware is Your Contractual Right.

Вывод

Для легального использования лицензий Oracle DB по количеству используемых ядер в виртуальной среде VMware vSphere необходимо:

- отключить применение технологий vMotion, DPM, DRS для виртуальных машин с Oracle DB;

- назначить посредством CPU Affinity необходимое количество ядер виртуальной машине, при включенном HT – можно добавлять допольнительно нечётные ядра;

- в случае аудита лицензий, должна быть возможность трекинга перемещений виртуальной машины, что можно выполнить в vSphere без особых проблем.

На первый взгляд, кажется, что после прочтения всей этой кучи документов вопросов не осталось. Как бы не так….

Осталась ещё одна функия – HA, с точки зрения использования Oracle VM нет прямого запрета в документах Oracle использовать данный функционал и он разрешен, а вот VMware считает это перемещением виртуальной машины и советует отключать.

Если же под ногами денег куры не клюют и очень хочется использовать механизмы автоматического размещения и миграции виртуальных машин, то необходимо лицензировать все ядра на всех хостах, где может оказаться Oracle DB.