diz решил поделиться своим опытом проброса видеокарты NVDIA GTX в ESXi 6.0.

Добрый день, дорогие друзья!

Говорят, что с 2015-ого года работодатели стали сразу выгонять с собеседования ИТ-шников, если вдруг выясняется, что у них нет личного сервера с развернутым частным облаком.

Чтобы не выбиваться из тренда, я собрал дома небольшой двухпроцессорный сервер на базе материнской платы SUPERMICRO X9DRI-F и пары Xeon E5-2670. Т.к. несколько лет своей жизни я посвятил, в т.ч. администрированию инфраструктуры VMWare, то в качестве гипервизора виртуализации был выбран именно ESXi.

Частное облако-домашняя лаба – это, конечно, замечательно и здорово, однако, для комфортной повседневной работы и StarCraft2 желательно иметь доступ к дискретной видеокарте.

Тому, как задружить “бытовую” nVidia GTX и ESXi 6 и посвящается данная статья – краткий проводник-путеводитель по граблям.

Первое, что вам захочется сделать после установки дискретной видеокарты в сервер – переключить приоритет инициализации видеокарты в BIOS в пользу внешней, чтобы видеть POST прямо на экране подключенного к ней монитора. Этого делать не стоит, т.к. в таком случае вы потеряете возможность использовать iKVM материнской платы.

Итак, приступаем к пробросу видеокарты в виртуальную машину с MS Windows 10. Увидев web-интерфейс ESXi 6 я искренне обрадовался тому, что завязал с системным администрированием четыре года назад. Откладываем этот замечательный интерфейс в сторону, т.к. проброс видеокарты через него вы настроить не сможете, при старте виртуальная машина будет ругаться на несоответствие идентификатора устройства PCIe (PCIe passthrough device id invalid) и переключаемся на старый добрый и толстый клиент:

Жмем “Edit..”:  И ставим галочки только напротив видеокарты и связанного HD AUDIO. Яочень рекомендую сперва добиться ее работоспособности, а уже потом пробрасывать мышку-клаву и звук.

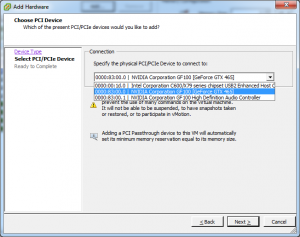

И ставим галочки только напротив видеокарты и связанного HD AUDIO. Яочень рекомендую сперва добиться ее работоспособности, а уже потом пробрасывать мышку-клаву и звук.  Затем переходим к добавлению PCIe устройства в виртуальную машину:

Затем переходим к добавлению PCIe устройства в виртуальную машину:

В мире розовых пони, где nVidia не жлобы, а VMWare тестируют свои продукты перед релизом, на этом все бы и закончилось. В нашем реальном мире грабли только начинаются. Сперва выясняется, что мы выдали виртуальной машине >2 Гб памяти и теперь она не может поделить адресное пространство с видеокартой. SUPERMICRO протягивает свой FAQ помощи http://www.supermicro.com/support/faqs/results.cfm?id=34 Цитирую:

“We need to make sure GPU BARs are memory mapped above 4GB and to enable EFI firmware add the following 3 lines to configuration (.vmx) file of VM: “pciPassthru.use64bitMMIO = “TRUE” “, “firmware = “efi” ” and “vmci.msix = FALSE “.”

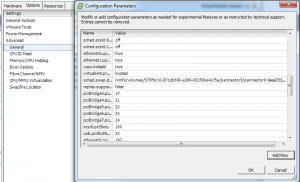

VMX файл можно отредактировать руками, а можно в настройках виртуальной машины:

Еще раз обращу внимание, что тип firmware виртуальной машины должен быть “EFI”, кстати, его можно поменять только через web gui, если будете пытаться менять его через толстый клиент, то он перескочит обратно на “BIOS”.

Далее наша виртуальная машина должна успешно запуститься, а драйвер видеокарты порадовать нас такой ошибкой: Суть проблемы: nVidia хочет чтобы все покупали видеокарты серий TESLA и QUADRO и выступает против того, чтобы пользователи занимались виртуализацией видеокарт “бытовых” серий. Драйвер детектит запуск в виртуальной машине и не дает видеокарте стартовать. Обходится при помощи того же трюка, который используется в nested виртуализации – прописыванием строчки hypervisor.cpuid.v0 = “FALSE” в vmx файле виртуальной машины.

Суть проблемы: nVidia хочет чтобы все покупали видеокарты серий TESLA и QUADRO и выступает против того, чтобы пользователи занимались виртуализацией видеокарт “бытовых” серий. Драйвер детектит запуск в виртуальной машине и не дает видеокарте стартовать. Обходится при помощи того же трюка, который используется в nested виртуализации – прописыванием строчки hypervisor.cpuid.v0 = “FALSE” в vmx файле виртуальной машины.

Почти все. Теперь при включении виртуальной машины у нас всего-навсего наглухо виснет гипервизор, даже не выкидывая PSOD. Просто все замирает без каких-либо записей в логах. Можно притвориться умным и сказать, что эту проблему мне помогло решить чтение главы “Problems with Device Assignment Dependencies” документа “Configuration Examples and Troubleshooting for VMDirectPath”, доступного по ссылке http://www.vmware.com/content/dam/digitalmarketing/vmware/en/pdf/techpaper/vsp-4-vmdirectpath-host-technical-note.pdf, но нет. Форумы в интернете забиты вопросами по этим симптомам с криками о том, что при переходе с версии 5.0 к более старшим VMWare сломала passthrough видеокарт (это относится как к nVidia, так и к ATI) и только один человек c ником mvrk нашел решение: необходимо отредактировать файл по пути /etc/vmware/passthru.map хоста виртуализации и исправить для нашей видеокарты режим проброса с bridge на link:

|

1 2 |

# NVIDIA 10de ffff link false |

Вот теперь можно переходить к пробросу мышки и клавиатуры. Тут тоже не обошлось без “особенностей”: когда я пробросил оба USB контроллера материнской платы в vm, драйвер видеокарты снова стал падать с 43й ошибкой. Решилось пробросом только одного контроллера, к портам которого я подключил оба устройства.

Спасибо за внимание и всего хорошего!

P.S. Как здорово, что я больше не админ.

классно, и как работает в итоге? производительность сильно пострадала? были какие то тесты?

Могу прогнать тесты, если есть интерес и если есть с чем сравнить. StarCraft2 LotV идет на максимальных настройках в разрешении 1440×900 (больше не поддерживает мой монитор), показывая 70-100 fps, но это игра с относительно низкими системными требованиями.

Я оценивал производительность по игре Deus Ex 3 – в Hyper-V SharedVGA через WiFi было FPS 10-20 (игра ощутимо подтормаживала при каждом движении).

Тут у нас прямой проброс видео, снижение производительности, по идее, должно быть небольшое.

Отличная статья, я в свое время остановился на падении ESXI 😉

но подглядел, что можно vmware обмануть с помощью паяльника

например https://geektimes.ru/post/173545/

К теме с паяльником есть целая ветка на одном форуме.

http://www.eevblog.com/forum/chat/hacking-nvidia-cards-into-their-professional-counterparts/?PHPSESSID=b032509aafb8eb447da909cb114b6efb

Здравствуйте! сделал все по описанию, но карточка у меня GeForce GT610 от Асуса…

но карточка все равно не работает и показывает ошибку 43 …

Добрый день!

Загрузите vmx файл и скриншоты настроек проброса видеокарты куда-нть.

Добрый день!

Вчера пробросил аудио, звук есть но со скрипом и шумом, уши вянут.

Есть ли у вас на этот счет решение?

Материнка Asus H97M-Plus

К сожалению, кроме как обновить драйвера, а затем открыть документ, ссылку на который я приводил в статье и тупо перебирать параметры о которых там идет речь, посоветовать ни чего не могу.

Добрый день!

Подскажите пожалуйста как можно получить доступ к файлу по адресу

/etc/vmware/passthru.map ?

1. Включить SSH доступ через клиент ESXi

2. Подключиться по SSH

3. Отредактировать файл при помощи текстового редактора VI

Доброго вечера. А можно ли прокинуть видеокарту на сразу 4 виртуалки, чтобы они ее юзали и дать каждой виртуалке свой видеовыход?

Нет.

А подскажите, если удается ли задействовать одну обычную видеокарту сразу в нескольких виртуальных машинах?

Добрый день, Василий.

Нет, не удастся.

На крайние 2 вопроса все говорят “нет” и “не удастся”, но это не свосем верно.

Обычный vmware драйвер поддерживает DirectX 10 и OpenGL ES 2.0, используа аппаратные ресурсы установленной видеокарты. Что позволяет нормально играть во что-то не особо требовательные. Это работает сразу и не требует проброса видеокарт и прочих танцев с бубном.

1. На вопрос “предоставить каждой виртуалке свой видеовыход видеокарты” – ответ однозначно нет. Либо всю видеокарту одной виртуалке, либо вообще никакого видеовыхода.

2. Обычный драйвер не будет использовать аппартные ресурсы видеокарты. То о чем вы пишете “сразу и не требует проброса видеокарт и прочих танцев с бубном.” – это будет обычный софтварный рендеринг. Средствами процессора, не видеокарты.

Для того чтобы использовать ресурсы видеокарты (это называется vSGA) вы дложны установить на esxi драйвер видеокарты и запустить xorg.

Официально вы можете это сделать ТОЛЬКО для видеокарт Nvidia Grid, а не любой “обычной видеокарты”. Для этого скачать и установить пакет vib с драйвером и запустить сервис xorg.

Есть варианты заставить работать vSGA с более широким набором видеокарт, но мы же обсуждаем “без танцев с бубном” не так ли?

Хорошая статья:

https://kb.vmware.com/selfservice/microsites/search.do?language=en_US&cmd=displayKC&externalId=2142307

Прислали ещё пару советов:

https://icebow.ru/portal/display/VMWKB/vDGA+PCoIP+NVIDIA+GRID+K1+core+errors

https://icebow.ru/portal/display/VMWKB/VMWare+ESXi+6+NVIDIA+GRID+vGPU+Code+43

Добрый день. Выучил эту статью уже наизусть, но никак не могу заставить виртуалку работать верно. Видюху пробросил, драйвер, вроде, работает, но мониторов в списке хоть ты тресни – нет и все. Подключено 2 монитора: по hdmi и vga.

VMware ESXi, 6.5.0, 4564106

S1200BTL (чип c204)

Xeon(R) CPU E31220 @ 3.10GHz

видеокарта msi (nvidia 710) для pcie x8

Виртуалка – win 7 х64; память 4gb, зарезервирована, в диспетчере устройств видюха определяется.

Еще, перепробовал на трех контроллерах: z97, z87, b85; ставил другие видюхи, 6 штук перепробовал (ati и nvidia), esxi 5.1, 5.5, 6.5, пробовал другие гостевые системы – gentoo, ubuntu, даже XP. Могу уже свою таблицу составить, если заработает.

Единственный раз, когда заработало – на тестовом стенде, когда только я начал ковыряться, с чипсетом z97 (asus z97-p)/i5-4690 с относительно коротким кабелем (стандартным 1,8м).

У меня же кабели vga – 15м, hdmi – 5 метров. Сами кабели и мониторы проверенные – вчера, до того, как я начал в очередной раз экспериментировать, были подключены к другому системнику и прекрасно работали.

Исходя из количества тестов, кроме длины кабеля в общем-то и вариантов нет. Прошу помощи, может, кто подскажет, что еще можно проверить.

Опишите подробно действия, и скриншоты бы не помещали.

На z97-p сделал проброс видюхи, добавил через веб-интерфейс видюху в виртуалку и все заработало.

В остальных случаях я пробовал как штатно, так и прямо по тексту, за исключением проброса видюхи через веб – оно работает и ни на что не ругается. Я также в нескольких случаях устанавливал vmware tools, но после установки и запуска виртуалка падала в бсод. Отключение программного адаптера от vmware делу не помогло: рабочий стол можно лицезреть через клиент vmware (при этом мониторов в списке вообще нет); включение и отключение поддержки 3d приводит либо к бсоду, либо просто не помогает.

Я также несколько раз тестировал изменение строчки в /etc/vmware/passthru.map, разницы для nvidia 710 нет. Сейчас стоит bridge.

Скрин:

http://2421329.ru/vmscr.png

Какие еще сделать?

Сегодня мне подкинули еще один монитор, который собираюсь подключить коротким кабелем. Расскажу вечером, что получится – самому интересно.

идея с коротким кабелем не прошла – ничего не изменилось

Поменял на link, перезагрузил хост – не помогло. Поставил в той же машине win 10 x64 – заработало. Хотите верьте, хотите – нет. В этой же виртуалке пробовал win 7 x64, win 7 x32, centos 7 x64, ubuntu 16, ubuntu 14. Все с проприетарными драйверами. Получается, проблема решена. Спасибо за небезразличие.

Если не секрет – а какие цели в такой реализации?

Не секрет. Сделал виртуалку в основном для интерактивного зеркала себе в ванну. Зеркало-шпион 5% (5% светопропускаемости маловато, кстати, – буду менять на 12%), за ним монитор.

Второй же монитор в виртуалке подключен на кухне для того, чтобы жена могла смотреть рецептики всякие.

А сам сервак постоянно работает – на нем почта, в-центр, торренты качаются и тд. Так что подумал: “что памяти зазря пропадать?”.

Кстати, не хочу, если честно проверять еще пару моментов, которые имели место вчера быть: подключая клавиатуру с мышкой для проброса в виртуалку, заодно поправил монитор, который подключен к встроенной видюхе (на котором сам гипервизор; ранее, видимо, я его задел и, вполне вероятно, был отключен) и после перезагрузки все опять сломалось. Я также добавил внутрь виртуалки один из контроллеров юсб, который, кстати, не появился в системе. И добавил hdmi звук видюхи.

Чтобы все вернуть я не стал экспериментировать и удалил все, что добавил (юсб + hdmi), вытащил кабель и вуаля:

http://2421329.ru/15.52.20.jpeg

http://2421329.ru/15.52.15.jpeg

Нашёл старенький 8400 GS, попробовал прокинуть в гостевую win10x64 на vSphere 6.5 (asus h81m + i5-4440 ). Получил BSOD “video_tdr_failure.” Делал всё по инструкции. Печалька.

Ставьте заново без вмтулз

Andrey Kouznetsov, я так и делал.

Вротмненоги. Счастье было так близко.

Видеокарта мифическим образом исчезла из гостевой после недели работы.

Пропала бесшумно и безапелляционно. Пока был в отъезде.

Из гостевой, той самой, на которой все заработало. Win10 x64.

Покопался в логах, нашел интересный момент.

Лог включения:

—

2017-04-19T21:52:02.917Z cpu3:193202)VSCSI: 2611: handle 8203(vscsi0:0):Reset request on FSS handle 85787877 (0 outstanding commands) from (vmm0:win_bath)

2017-04-19T21:52:02.917Z cpu3:65697)VSCSI: 2891: handle 8203(vscsi0:0):Reset [Retries: 0/0] from (vmm0:win_bath)

2017-04-19T21:52:02.917Z cpu3:65697)VSCSI: 2679: handle 8203(vscsi0:0):Completing reset (0 outstanding commands)

2017-04-19T21:52:06.702Z cpu0:193197)NetPort: 1879: disabled port 0x200000b

2017-04-19T21:52:06.702Z cpu0:193197)Net: 3732: disconnected client from port 0x200000b

2017-04-19T21:52:06.702Z cpu0:193197)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.1

2017-04-19T21:52:11.703Z cpu1:193197)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:52:11.703Z cpu1:193197)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.1 after reset

2017-04-19T21:52:11.738Z cpu2:65594)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.0

2017-04-19T21:52:16.739Z cpu3:65594)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.0 after reset

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: VmMemPin: 368: vm 193198: bpn 0x1000000e0 count was zero (count=0)

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: VmMemPin: 368: vm 193198: bpn 0x1000000e1 count was zero (count=1)

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: VmMemPin: 368: vm 193198: bpn 0x1000000e2 count was zero (count=2)

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: VmMemPin: 368: vm 193198: bpn 0x1000000e3 count was zero (count=3)

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: VmMemPin: 368: vm 193198: bpn 0x1000000e9 count was zero (count=9)

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: VmMemPin: 368: vm 193198: bpn 0x1000000f3 count was zero (count=19)

2017-04-19T21:52:16.739Z cpu3:65594)WARNING: VmMemPin: 368: vm 193198: bpn 0x1000000fd count was zero (count=29)

2017-04-19T21:52:38.955Z cpu0:67592 opID=4c55a784)World: 12230: VC opID 818da587 maps to vmkernel opID 4c55a784

2017-04-19T21:52:38.955Z cpu0:67592 opID=4c55a784)Config: 706: “SIOControlFlag2” = 1, Old Value: 0, (Status: 0x0)

2017-04-19T21:52:39.732Z cpu0:193492)MemSched: vm 193492: 6366: extended swap to 28160 pgs

2017-04-19T21:52:40.997Z cpu3:193492)World: vm 193493: 7375: Starting world vmm0:win_bath of type 8

2017-04-19T21:52:40.997Z cpu3:193492)Sched: vm 193493: 6184: Adding world ‘vmm0:win_bath’, group ‘host/user’, cpu: shares=-3 min=0 minLimit=-1 max=-1, mem: shares=-3 min=1048576 minLimit=-1 max=-1

2017-04-19T21:52:40.997Z cpu3:193492)Sched: vm 193493: 6199: renamed group 533824 to vm.193492

2017-04-19T21:52:40.997Z cpu3:193492)Sched: vm 193493: 6216: group 533824 is located under group 4

2017-04-19T21:52:41.183Z cpu0:193492)World: vm 193496: 7375: Starting world vmm1:win_bath of type 8

2017-04-19T21:52:41.183Z cpu0:193492)World: vm 193497: 7375: Starting world vmm2:win_bath of type 8

2017-04-19T21:52:41.183Z cpu0:193492)World: vm 193498: 7375: Starting world vmm3:win_bath of type 8

2017-04-19T21:52:42.825Z cpu2:193492)VSCSI: 3787: handle 8204(vscsi0:0):Creating Virtual Device for world 193493 (FSS handle 346686371) numBlocks=67108864 (bs=512)

2017-04-19T21:52:42.825Z cpu2:193492)VSCSI: 273: handle 8204(vscsi0:0):Input values: res=0 limit=-2 bw=-1 Shares=1000

2017-04-19T21:52:42.830Z cpu2:193492)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.0

2017-04-19T21:52:47.830Z cpu0:193492)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:52:47.830Z cpu0:193492)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.0 after reset

2017-04-19T21:52:47.831Z cpu0:193492)IOMMU: 2176: Device 0000:01:00.0 placed in new domain 0x430331c38a40.

2017-04-19T21:52:47.831Z cpu0:193492)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.1

2017-04-19T21:52:52.832Z cpu0:193492)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:52:52.832Z cpu0:193492)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.1 after reset

2017-04-19T21:52:52.885Z cpu1:193493)VMMVMKCall: 218: Received INIT from world 193493

2017-04-19T21:52:52.885Z cpu1:193493)CpuSched: 692: user latency of 193626 LSI-193493:0 0 changed by 193493 vmm0:win_bath -6

2017-04-19T21:52:52.885Z cpu1:193493)LSI: 1805: LSI: Initialized rings for scsi0 async=1

2017-04-19T21:52:52.886Z cpu2:193496)VMMVMKCall: 218: Received INIT from world 193496

2017-04-19T21:52:52.886Z cpu3:193497)VMMVMKCall: 218: Received INIT from world 193497

2017-04-19T21:52:52.886Z cpu0:193498)VMMVMKCall: 218: Received INIT from world 193498

2017-04-19T21:52:52.886Z cpu1:193625)WARNING: NetDVS: 681: portAlias is NULL

2017-04-19T21:52:52.886Z cpu1:193625)Net: 2524: connected win_bath eth0 to VM Network, portID 0x200000c

2017-04-19T21:52:52.886Z cpu1:193625)CpuSched: 692: user latency of 193494 NetWorld-VM-193493 0 changed by 193625 vmx-vcpu-0:win_bath -6

2017-04-19T21:52:52.886Z cpu1:193625)NetPort: 1660: enabled port 0x200000c with mac 00:00:00:00:00:00

2017-04-19T21:52:52.904Z cpu3:67605)Config: 706: “SIOControlFlag2” = 0, Old Value: 1, (Status: 0x0)

2017-04-19T21:52:53.469Z cpu1:193625)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.0

2017-04-19T21:52:58.470Z cpu3:193625)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:52:58.470Z cpu3:193625)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.0 after reset

2017-04-19T21:52:58.470Z cpu3:193625)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.0

2017-04-19T21:53:03.471Z cpu2:193625)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:53:03.471Z cpu2:193625)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.0 after reset

2017-04-19T21:53:03.474Z cpu2:193625)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.1

2017-04-19T21:53:08.475Z cpu2:193625)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:53:08.475Z cpu2:193625)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.1 after reset

2017-04-19T21:53:08.475Z cpu2:193625)WARNING: PCI: 780: Reporting transaction pending on device 0000:01:00.1

2017-04-19T21:53:13.476Z cpu1:193625)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

2017-04-19T21:53:13.476Z cpu1:193625)WARNING: PCI: 813: Detected transaction pending on device 0000:01:00.1 after reset

2017-04-19T21:53:14.375Z cpu3:193493)VSCSI: 2611: handle 8204(vscsi0:0):Reset request on FSS handle 346686371 (0 outstanding commands) from (vmm0:win_bath)

2017-04-19T21:53:14.375Z cpu0:65697)VSCSI: 2891: handle 8204(vscsi0:0):Reset [Retries: 0/0] from (vmm0:win_bath)

2017-04-19T21:53:14.375Z cpu0:65697)VSCSI: 2679: handle 8204(vscsi0:0):Completing reset (0 outstanding commands)

2017-04-19T21:53:14.375Z cpu3:193493)VSCSI: 2611: handle 8204(vscsi0:0):Reset request on FSS handle 346686371 (0 outstanding commands) from (vmm0:win_bath)

2017-04-19T21:53:14.375Z cpu0:65697)VSCSI: 2891: handle 8204(vscsi0:0):Reset [Retries: 0/0] from (vmm0:win_bath)

2017-04-19T21:53:14.375Z cpu0:65697)VSCSI: 2679: handle 8204(vscsi0:0):Completing reset (0 outstanding commands)

2017-04-19T21:53:20.116Z cpu1:193497)VSCSI: 2611: handle 8204(vscsi0:0):Reset request on FSS handle 346686371 (0 outstanding commands) from (vmm0:win_bath)

2017-04-19T21:53:20.116Z cpu0:65697)VSCSI: 2891: handle 8204(vscsi0:0):Reset [Retries: 0/0] from (vmm0:win_bath)

2017-04-19T21:53:20.116Z cpu0:65697)VSCSI: 2679: handle 8204(vscsi0:0):Completing reset (0 outstanding commands)

—

Вот здесь явно какая-то проблема:

2017-04-19T21:53:13.476Z cpu1:193625)PCI: 649: Device 0000:01:00.0: restoring TV/VC Map (0xff) to offset 114

Думаю, что по какой-то причине при включении гостевой ОС, esxi не пробрасывает внутрь видюху; например из-за проверки ACS. Метод выключения проверки нашел только для 5.5: esxcfg-advcfg -k TRUE disableACSCheck. После перезагрузки хоста, наверняка, все заработает (потому что после прошлого включения все было в порядке примерно неделю). Но почему сейчас видюхи нет в списке устройств? Кто-нибудь встречал подобное поведение?

Замечательная статья. Вот пытаюсь прокинуть NVIDIA QUADRO 600 в Microserver G8, на ESXi 6.5. Если у VM памяти 2Гб, то прокидывается без проблем, а вот при увеличении памяти у VM, она перестаёт запускаться, пишет:

Error message from localhost.localdomain: We will respond on the basis of your support entitlement. error

Выставлял:

pciPassthru.use64bitMMIO = TRUE

firmware = efi

vmci.msix = FALSE

hypervisor.cpuid.v0 = FALSE

но не помогает. Может кто подскажет, как это вылечить?

Отвечаю на свой комментарий. В логах VM была следующая ошибка:

vcpu-0| I125: Failed to adjust IOMMU: Failure

vcpu-0| W115: MONITOR PANIC: vcpu-0:PCIPassthru: failed to adjust IOMMU mappings.

…

vcpu-0| I125+ vcpu-0:PCIPassthru: failed to adjust IOMMU mappings.

VM успешно запустилась при указании только одного параметра (кстати, успешно работает и на VM без EFI):

pciHole.start = 2048

подробности в kb2142307. Но к большому сожалению, хоть видеокарта успешно пробросилась в виртуалку, там она корректно не заработала (при любых запусках тестов, писалось, что видеокарта не обнаружена).

Действительно работает – проверял на VM 6.0:

1) На Гипервизоре – первым делом прописал “link” (в /etc/vmware/passthru.map):

# NVIDIA

10de ffff link false

Далее перезагрузил гипер-визор.

2) В файле виртуальной машины (.vmx) прописал вот это:

pciPassthru.use64bitMMIO = “TRUE”

vmci.msix = “FALSE”

3) Далее в виртуальную машину – добавил оба PCI-Ex устройства (карта+HDMI звук)

4) Вот это – firmware = “efi” – не понадобилось (т.к. моя виртуалка уже была установлена на BIOS (классическом) загрузчике и после установки в EFI перестала загружаться. Поэтому это отключил обратно на BIOS (EFI не стал включать):

5) Далее включил виртуалку и там появилась некая-видеокатра. Поставил к ней родные драйвера. После перезагрузки – определилась верно, но “устройство было выключено (из-за неполадок)”.

Не страшно – выключил машину и прописал в конец (.vmx) файла:

hypervisor.cpuid.v0 = “FALSE”

6) Далее включил виртуалку = всё работает!

Единственно через GUI (vSphere Client) управление консолью машины

стало не удобно, т.к. “уехала” мышка. В принципе не суть – через любой удалённый администратор нормально управляется.

7) Приложения которые перестали ругаться на отсутствие поддержки аппаратного ускорителя (до этого ругались 🙂

– Автокад 16-й,

– Фотошоп 2015.

Без firmware = «efi» у меня не работало. Судя по сообщениям и по тому, что я намониторил, пока писал статью, вся тема с пробросом видео в виртуалку – люто кривая.

NVIDIA QUADRO 600 проброс в ESXi 6.0 на Windows 7 у кого то получилось, есть тесты?

ESXi 6.0 + NVIDIA QUADRO 600 + Windows 10

Пробовал всё но виртуальную машину не запускало в логах

PCIPassthru: 0000:81:00.0 : Device BAR 1 requested 64-bit memory address that exceeded MPN type (62122138533888).

Помогло только на уровне BIOS в SUPERMICRO

MMIOHBase – 512G (default 56T)

https://octo.vmware.com/enable-compute-accelerators-vsphere-6-5-machine-learning-hpc-workloads/

Пытаюсь найти решение проблемы PSOD при перезагрузке VM c проброшенной видеокартой. Может кто подскажет, куда копать?

Было: esxi 5.5 + WS460 Gen8 + Quadro 1000M, VM на RHEL6 (bios boot) с проброшенной Quadro работали великолепно.

Стало: esxi 6.5 + тоже самое железо, VM c тем же линуксом и проброшенной quadro загружается и работает отлично. Стоит дать виртуальной машине команду reboot (или shutdown с последующим включением) происходит PSOD в момент, когда второй раз (после загрузки хоста) инициализируется драйвер видеокарты внутри VM. Т.е. этакий хост с виртуализацией, при которой перезагрузка VM приводит к перезагрузке самого хоста.

Перепробовал всё: d3d0 и link в passthru.map, hypervisor.cpuid.v0, pciPassthru.use64bitMMIO, pciHole.start/end, в bios хоста включал-выключал BAR, менял linux драйверы nvidia внутри VM, инсталлировал RHEL на EFI – результат один и тот же: ребут хоста при второй загрузке VM (при втором по счету старте драйвера quadro внутри VM после загрузки хоста)

help…

Очень смущает низкий Performance svga, используется очень мощная карта FirePro S9050. Но по факту оно едва ползает, по сравнению с обычными картами.

NVIDIA VIB разных версий пробовали?

а при чем тут vib? Это же драйверы для самого хоста esxi (для vSGA режима, когда запросы к вирутальной видеокарте от нескольких VM обрабатываются одной хостовой видеокартой). В описанной выше проблеме речь идет о режиме vDGA (GPU passthrough), при котором хостовой видеокартой монопольно владеет одна VM.

Мне PSOD хоста в вашем описании не нравится, я бы поставил vib.

Здравствуйте, Mister Nobody!

Я правильно понял, что в статье пробрасывалась единственная видеокарта в системе?

У меня имеется материнка MSI B75MA-P45 (MS-7798) и процессор i5-2500 с интегрированным видео.

Возможно ли пробросить интегрированное видео, отобрав его у ESXi 6.5 ?

Привет!

Вам очень повезло, т.к. в Windows всё решилось более-менее просто в части установки драйверов. Я решил сделать тоже самое для гостевой Ubuntu в хосте ESXi и наткнулся на кучу проблем и моментов, которые, конечно, гуглятся, но на это тратится множество времени.

Специально оформил проброс видеокарты в Ubuntu в виде пошагового руководства и выложил у себя в блоге, если вы не против – оставлю ссылку на свою публикацию здесь, т.к. желающие сделать тоже самое – наверняка вначале найдут вашу статью, т.к. блог более авторитетный 🙂

Моя статья: https://vk.com/@lord.alfred-nvidia-passthrough-to-ubuntu-in-vmware-esxi

2Lord_Alfred Если разрешите, то мы можем опубликовать Вашу статью на нашем бложике.

@Mister Nobody, я буду только рад 🙂 Единственное, что хотелось бы – чтоб осталась ссылка на мою статью/блог, т.к. я не постоянный читатель вашего блога и если будут вопросы – вряд ли смогу своевременно ответить.

Отпишитесь со своей почты на мою почту – я в течении пары дней перепишу под ваш блог вводную и выводы, чтоб у нас они хоть как-то различались. И, да, – скорее всего потребуется много времени чтобы красиво перенести оформление основной части статьи… Можете начинать это делать, в принципе в рамках черновика у себя в блоге (я буду не против, а наоборот только рад, если вы вставите свои примечания по каким-то пунктам, т.к. в ESXi я нуб-нубом и мог где-то неправильно описать функционал).

Добрый день!

Diz! Отличная статья – пройденный путь вызывает уважение!

Я столкнулся с аналогичной проблемой – Код 43 – когда драйвер детектит запуск в виртуальной машине и не дает видеокарте стартовать. Только пробросс я делаю на гипервизоре XenServer. Не смогли бы вы пояснить, что означают строчки hypervisor.cpuid.v0 = “FALSE” в vmx файле виртуальной машины для ESXi, чтобы я смог выставить аналогичные настройки в XenServer.

В догонку к предыдущему посту…

Я пробрасывал NV GeForce GT 240 (DDR5-512Mb). Причем после замены ее на ATI Radeon HD4650 (DDR3-256Mb) – все прошло на ура.

Gf210 win7 работает

Gf1030 win7 работает

Gf210 ubuntu16.4 работает

Gf1030 ubuntu16.4 неделя рванных бубнов,волос на голове и ниже. Пока ошибка инициализации.

Покурил тему “как замаскировать виртуальную машину” – пришел к выводу, что видимо будет проще либо в драйвере запатчить определение виртуальности, либо GF перепрошить в Quadro, либо использовать AMD.

Хорошая статья. Помогла прокинуть карту в виртуальную машину. У меня карта Tesla K80. Запустил потом ролик 4К точно так же тормозит как и на обычной виртуальной машине. Температура карты не изменилась после такой нагрузки. Вывод она у меня не используется.

вопрос: Как использовать в виртуальной машине прокинутую как PCI устройство видеокарту?

а можно ли QUADRO или amd pro прокинуть на несколько виртуалок?

2Виктор На предыдущей страницы комментариев ответ дан.

Считается, что нет.

https://www.virtuallyghetto.com/2019/01/gpu-passthrough-of-radeon-rx-vega-m-in-intel-hades-canyon.html

Что такое “толстый клиент”. Пробую ESXI6.7. Спасибо.

Добрый вечер, Равиль.

“Толстый” клиент – это .NET клиент, который устанавливался на MS Windows.

На текущий момент он позволяет подключаться только к vSphere 6.0 или более старым версиям. С v6.7/v6.5 – он не работает, пробуйте эти же настройки в веб-клиенте.

http://blog.vmpress.org/2019/04/vdga.html

Здравствуйте! Написал Вам, с надеждой на совет -текст ниже.

Занимаюсь частичным видеореставрированием – пример Неподсуден (1969) https://youtu.be/cr1pPr1XWN8 Для таких дел нужны большие вычислительные мощности.

Подскажите, кто может мне помочь в “виртуальном” увеличение вычислительных мощностей и их целесообразности на моем железе?

Моё железо:

Тип ЦП QuadCore Intel Core i7-3770, 3700 MHz (37 x 100) Встроенная в процессор графика HD Graphics 4000

Системная плата Asus P8H77-V LE (3 PCI, 2 PCI-E x1, 2 PCI-E x16, 4 DDR3 DIMM, Audio, Video, Gigabit LAN)

Чипсет системной платы Intel Panther Point H77, Intel Ivy Bridge

Системная память 24518 МБ (DDR3-1600)

Дисковый накопитель R3SL120G (111 ГБ)

Дисковый накопитель ST2000DM001-1CH164 (2 ТБ, 7200 RPM, SATA-III)

Дисковый накопитель ST2000DM006-2DM164 (2 ТБ, 7200 RPM, SATA-III)

Видеоадаптер GeForce RTX 2060 (6 ГБ)

Добрый день, Евгений.

Не совсем понял вашего вопроса. Виртуализация не увеличивает вычислительные мощности – она позволяет использовать их более эффективно за счет создания множества изолированных операционных систем (виртуальных машин).

Грубо говоря, вместо утилизации одной вычислительной системой 10% ЦП вы запускаете параллельно 8 вычислительных систем, за счет чего утилизируете примерно 88% ЦП (8*10%*110%), где 110% – усредненные накладные расходы виртуализации.

Данная статья про один из подвидов виртуализации – проброс графического адаптера в одну из виртуальных машин, чтобы запускать ресурсоемкие графические приложения.

Если у вас всего одна ресурсоемкая операция, которая упирается в производительность ЦП/памяти/GeForce, то виртуализация тут вам не поможет (и даже сделает хуже).

Спасибо Андрей!

Ваше письмо попало в спам, поэтому сразу не поблагодарил. Смысл моего вопроса в том, что программное обеспечение поддерживает только видеокарты Quadro, хотя некоторые умудряются использовать Titan (We recommend the Quadro series GPU’s. GTX Cards are not tested, however customers do use the Titan with Nucoda) http://www.digitalvision.tv/w/index.php?title=Support:Drivers#NVIDIA_GTX_Series_including_Titan

Поэтому я Вас и спросил.

Евгений

Низкий поклон вам, за то что поделились столь специфической информацией!)

Неделю совокуплений не давали результата пока не нашел ваш форум)

По инструкции с экспериментальной GTX570 все отлично получилось!

П.С. Возможно кому пригодится, пока не воткнул в разъем видяхи монитор, она хоть и определялась нормально, но фактически не работала, все бенчмарки проходили на софтверной, хотя в самих тестах фигурировала моя 570я. Но фпс в том же анреал бенчмарке был 5-6, после подключения монитора 70+.

Возможно у кого нибудь получилось обойти данный затык, буду признателен если поделитесь.

Добрый вечер. Все сделал по инструкции, но все равно висит ошибка 43 (

Карта GT340, hypervisor.cpuid.v0=FALSE не помог.

Подскажите, какие есть варианты решения проблемы?

Евгений, если вам нужны большие вычислительные мощности GPU карт, то следует обратится в профильную компанию, которая занимается сдачей в аренду GPU серверов, например: iqhost.ru, hostkey.ru, selectel.ru

Спустя 5 лет ситуация начинает меняться

https://nvidia.custhelp.com/app/answers/detail/a_id/5173/~/geforce-gpu-passthrough-for-windows-virtual-machine-(beta)

Добрый вечер. Можно ли пробросив целиком одну видяху (квадру) в один хост на венде10 использовать выходы видеокарты и брать с них видеосигнал? (Например, подключить физически 3 монитора)?

Проверьте и нам расскажите.

Прекрасная статья! Спасибо за информацию!

Есть у меня один вопрос: после проброса карты в Windows Server 2019 я получил 2 видеокарты: VMWare Virtual VideoCard и NVidia Quadro 2000. Теперь загвоздка в следующем: я хочу заставить эти карты миррорить изображение между собой (желательно с использованием ресурсов квадры), но в стандартных настройках винды такой опции нет 🙁 Есть возможность подсказать, как это сделать другими средствами?

Здравствуйте, выполнил по инструкции.

Dell power edge 210; Esxi 6.0; xeon 3470; Виртуалка win 10 pro x64; карта nvidia vs300; Пробросил карту и usb контроллер, установил драйверы, ошибок нет. Но при загрузке винды падает в синий экран. В хосте и виртуалке параметры поправил.

Serj, а вы исправляли в файле passthru именно эту строчку?

# NVIDIA

10de ffff link false

Мне что-то подсказывает, что “10de” (а возможно и кусок с ffff) могут как-то пересекаться с vendor ID && Device ID, и в вашем случае они могут отличаться от значений в статье.