У нас неожиданно стал прекращать работать VCSA, а конкретно сервис VPXD.

Стартнёшь ручонками – работает то десяток часов, то 20 минут. Из warning’ов – мало места для базы данных (List of VMDKs/Partitions for a vCenter Server Appliance 6.7 – Size Mount point and Purpose (70625)). VAMI показывает, что места в SEAT занято 90%. Также не работает Update Manager даже при запущенном VPXD. Все логи vpxd.log перебрали – ничего не заметили, как будто штатный останов.

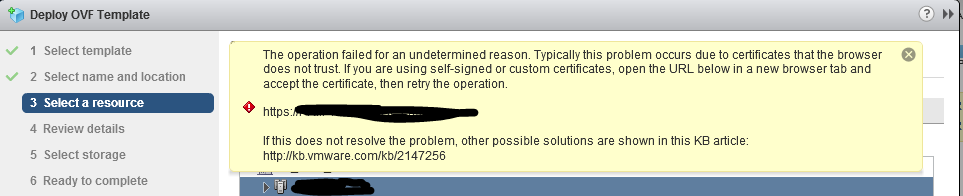

Написали в техподдержку – те попросили логи собрать, а как их соберёшь, если vCenter то потухнет, то погаснет. Кое-как собрали через VAMI, да и те оказались не полные, пришлось ручонками скопировать с помощью WinSCP папку логов VPXD.

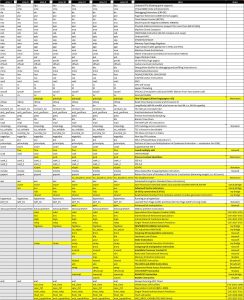

Поддержка логи смотрела внимательнее и нашла:

|

1 2 3 |

2019-08-27T06:50:34.343Z error vpxd[102197] [Originator@6876 sub=vpxdVdb] Shutting down the VC as there is not enough free space for the Database(used: 95%; threshold: 95%). 2019-08-27T06:50:34.343Z info vpxd[102197] [Originator@6876 sub=Default] Initiating VMware VirtualCenter shutdown 2019-08-27T06:50:35.412Z error vpxd[102111] [Originator@6876 sub=vpxdVdb] Insufficient free space for the Database (used: 95%; threshold: 95%) |

Действительно, места не хватает и VPXD сам себя отправляет отдыхать. Описание поведения vCenter есть КБ-шечке “Shutting down the VC as there is not enough free space for the Database” error (67017). Вот только она про /storage/db, а про /storage/seat умалчивает.

Добавили место у диска SEAT по инструкции Increasing the disk space for the VMware vCenter Server Appliance in vSphere 6.5 and 6.7 (2145603). Перезагрузили VCSA и всё заработало.

P.S. Так и не понял – с каких пор 90%=>95%?

P.P.S. Андрей подсказал откуда разница в процентах (данные после увеличения диска):

Вывод в VAMI: seat Total space 54.0 GB Used space 32.4 GB Available space 21.6 GB 60.1% of 54.0 GB

Вывод в df -h: /dev/mapper/seat_vg-seat 55G 33G 19G 64% /storage/seat