При подключении к Программе повышения эффективности работы заказчиков (Customer Experience Improvement Program, CEIP), вы может проверить здоровье вашей vSphere через онлайн-анализатор.

Проверки с проблемами пишутся все, а вот беспроблемные только частично. Меня интересовало – что ещё проверяется?

Итак список проверок на момент публикации статьи:

- ESXi host with i40e driver and TCP Segmentation Offload

(TSO) enabled KB 2126909 - ESXi with HP ILO driver version 10.0.1-24 KB 2148123

- Intel IOMMU interrupt remapper is disabled for ESXi hosts on

HP ProLiant Gen8 servers KB 2149043 - ESXi host dvfilter vmci socket deregistration KB 2149242

- ESXi 6.0 Update 2 when hardware Large Receive Offload

(LRO) is ‘enabled KB 2144968 - Network redundancy check when configuring VMware High

Availability in vCenter Server KB 1004700 - ESXi 6.5.x has 10Gb Physical Nic and NetQueue is enabled KB 2151749

- ScratchConfig.CurrentScratchLocation is set to “/scratch” on

ESXi version 6.0.0 and 6.5.0 KB 2151209 - ESXi maximum number of supported storage devices KB 2150280

- ESXi 6.5 or 6.7 host with IPv6 disabled KB 2150794

- ESXi system logs on vSAN datastore KB 2147541

- ESXi host with native Intel X710 driver and VLAN tagging KB 2149781

- ESXi with bad brcmfcoe or lpfc driver versions KB 2151391

- SearchLow I/O performance using intel-nvme drivers 1.3.2.8-

1OEM and 1.3.2.4-1OEM with block sizes larger than 4K KB 55693 - Host experiences PF Exception 14 with

bnx2x_netq_free_rx_queue_single in backtrace KB 53353 - Virtual machine operations on an ESXi 6.0 host fails KB 2113450

- Sequential-context attack vector vulnerability in Intel

processors KB 55806 - Concurrent-context attack vector vulnerability in Intel

processors KB 55806 - ESXi unable to save hostd service state to /bootbank KB 2057826

- VMDK corruption after canceling a snapshot removal task KB 2146319

- Disk space check for VMware vCenter Server Appliance KB 2145603

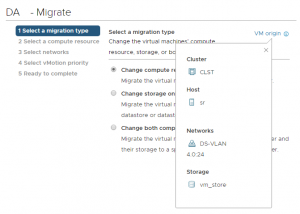

- vMotion network configuration check for vSphere Standard

Switch KB 2120640 - vMotion network configuration check for vSphere Distributed

Switch KB 2120640 - Selective deletion of tasks, events, and historical performance

data in vSphere 5.x and 6.x KB 2110031 - Host participating in VM-based replication KB 55650

- ESXi on host with AMD EPYC 7xx1 CPU KB 52045

- vMotion of virtual machines from ESXi 6.0 to 6.5 KB 59723

- End of General Support for vSphere 6.0 KB 66977

- Deprecation of the external Platform Services Controller

deployment model KB 60229 - Maximum number of ESXi hosts per cluster Max Config

- ESXi host connectivity with vCenter Server KB 1005757

- Enable SCAv2 for optimal hyperthreading performance KB 55806

- Unsupported address family with dvSwitch in ESXi 6.0 KB 2117308

- Host PSOD on QFLE3I driver on QLogic 57840 10/20 Gigabit

Ethernet Adapter KB 56357 - vCenter Server version compatibility check KB 68174