Дошли руки обновить прошивку MSA P2000 G3 до TS252R007.

Обновилось все замечательно, вот только после обновления отмер веб-интерфейс.

Поддержка сказала, что это не баг, а фича, и дала ссылку про то, что покрошился сертификат.

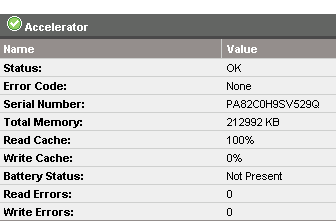

Команда show certificate показала, что действительно оба контроллера сидят с непойми чем.

Вот только выполнение рекомендаций на контроллере A мне не помогло – сертификат не пересоздался. Выполнение рекомендаций на контроллере B – частично помогло – пересоздался сертификат только на контроллере B.

# show certificate

Certificate Status

——————

Controller: A

Certificate Status: Unknown status

Time Created:

Certificate Text: none

Certificate Status

——————

Controller: B

Certificate Status: System-generated

Time Created: 2015-09-02 22:15:58

Certificate Text: Certificate:

Техподдержка радостно предлагает засунуть сертификат на контроллер через FTP (ВАУ) 🙂

Временно включил по их совету доступ через HTTP, чтобы проверить работоспособность веб-служб.

Сертификат через FTP не засовывается.

Помогло отключение NTP и сброс таймзоны

#set controller-date ntp disabled timezone 0

Пересоздаем сертификат

#create certificate unique both

Перезагружаем Management Controllers

# restart mc both

2) Закрыл бакдор, описанный тут.

У MSA’шки есть пользователь admin с паролем !admin.

Может зайти телнетом, web и так далее.

Для смены пароля необходимо зайти в шелл.

# set password admin

Enter new password: ****************************

Re-enter new password: ****************************

Success: Command completed successfully. (admin) — The password was changed.

3) Попутно решил обновить прошивку дисков, но невнимательно читал гайд: прошивка дисков осуществляется БЕЗ нагрузки на СХД. Один из гипервизоров потерял лун с VMFS, размещенный на этих дисках – помог только ребут гипервизора.