Disclaimer: статья основана на следующих источниках:

NVMeoF vVols

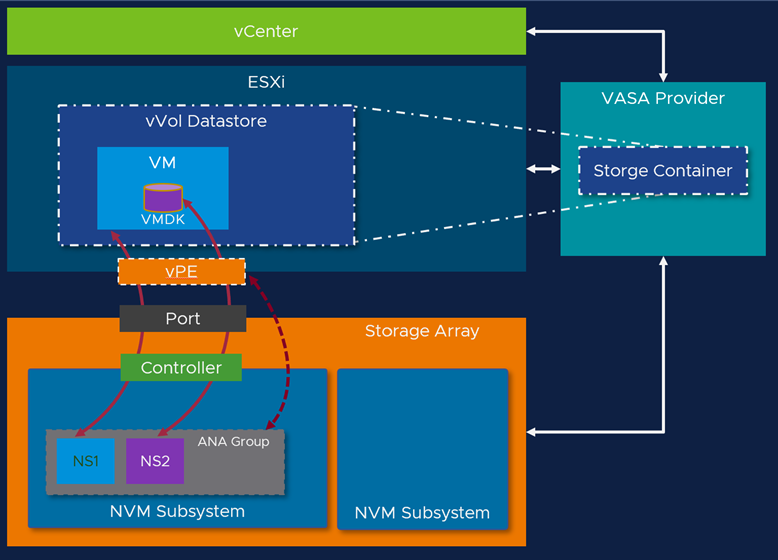

Виртуальные тома vVols были основным направлением в разработке систем хранения VMware в течение последних нескольких релизов, и в vSphere 8.0 это не изменилось. Самым крупным анонсом в подсистеме хранения vSphere 8.0 (core storage) является добавление поддержки vVols в NVMeoF. Первоначально будет поддерживаться только FC, но в дальнейшем будут проверять и поддерживать другие протоколы, поддерживаемые vSphere NVMeoF. Это новая спецификация vVols Spec, фреймворк VASA/VC – VASA 4.0/vVols 3.0.

Причина добавления поддержки vVols в NVMeoF заключается в том, что многие поставщики массивов и вся отрасль переходят к использованию или, по крайней мере, добавлению поддержки NVMeoF для повышения производительности и пропускной способности. Таким образом, VMware следит за тем, чтобы технология vVols оставалась актуальной для новейших технологий хранения данных.

Еще одним преимуществом NVMeoF vVols является настройка. При развертывании, после регистрации VASA, базовая настройка выполняется в фоновом режиме, необходимо только создать хранилище данных. Виртуальные конечные точки протокола (vPE) и соединения обрабатываются VASA, что упрощает настройку.

Группа ANA (асимметричный доступ к пространству имен)

В NVMeoF реализация vVols немного отличается. В традиционных vVols на базе SCSI контейнер хранения (Storage Container) представляет собой логическую группировку самих объектов vVol. В NVMeoF это будет зависеть от того, как это реализует производитель массива. Но в целом, в массиве группа ANA – это группировка пространств имен vVol. Массив определяет количество групп ANA, каждая из которых имеет уникальный ANAGRPID в подсистеме NVM. Пространства имен выделяются и становятся активными только по BIND-запросу к поставщику VASA (VP, VASA Provider). Пространства имен также добавляются в группу ANA по BIND-запросу к VP. Пространство имен остается выделенным/активным до тех пор, пока последний хост не разблокирует vVol.

vPE (virtual Protocol Endpoint, виртуальная конечная точка протокола)

В традиционных vVol, основанных на SCSI, конечная точка протокола (Protocol Endpoint, PE) представляет собой физический LUN или том на массиве и отображается на устройствах хранения на хостах. С NVMEoF vVols физического представления PE не существует, PE теперь является логическим объектным представлением группы ANA, в которой находятся vVols. Фактически, пока ВМ не включена, vPE не существует. Массив принимает решение о количестве групп ANA, каждая из которых имеет уникальный ANAGRPID в подсистеме NVM. После включения ВМ создается vPE, чтобы хост мог получить доступ к vVol в группе ANA. На схеме видно, что vPE указывает на группу ANA на массиве.

NS (namespace, пространство имен, эквивалент LUN для NVMe)

Каждый тип vVol (Config, Swap, Data, Mem), созданный и используемый ВМ, создает NS, который находится в группе ANA. Соотношение vVol и NS составляет 1:1. Это позволяет производителям легко масштабировать объекты vVol. Обычно производители поддерживают тысячи и даже сотни тысяч NS. Пределы NS зависят от производителя массива.

Здесь на диаграмме видно, что сама виртуальная машина является NS, это Config vVol, а диск – это другой NS, vVol с данными.

Усовершенствования NVMeoF

Поддержка 256 пространств имен и 2K путей с NVMe-TCP и NVMe-FC

NVMe over Fabrics (NVMeoF, NVMe поверх фабрики) продолжает набирать популярность по очевидным причинам. Более высокая производительность и пропускная способность по сравнению с традиционным подключением SCSI или NFS. Многие партнеры по хранению данных также переходят на массивы NVMe, а использование SCSI для доступа к флэш-памяти NVMe является узким местом для потенциального выигрыша.

- Постоянно добавляя функции и улучшения, VMware увеличила количество поддерживаемых пространств имен и путей для NVMe-FC и TCP.

Расширение поддержки резервирования для устройств NVMe

Поддержка команд резервирования NVMe для таких решений, как WSFC. Это позволит клиентам использовать возможности Clustered VMDK для использования в Microsoft WSFC с хранилищами NVMeoF Datastores. В релизе vSphere 8 поддерживается только FC-фабрика.

Поддержка службы автоматического обнаружения NVMe Discovery Service в ESXi

- Расширенная поддержка NVMe-oF Discovery Service в ESXi обеспечивает динамическое обнаружение совместимой со стандартами NVMe Discovery Service.

- ESXi использует службу mDNS/DNS-SD для получения информации, такой как IP-адрес и номер порта активных служб обнаружения NVMe-oF в сети.

ESXi отправляет многоадресный запрос DNS (multicast mDNS), запрашивая информацию у сущностей, предоставляющих (NVMe) службу обнаружения (DNS-SD). Если такая сущность активна в сети (на которой был отправлен запрос), она отправит (одноадресный, unicast) ответ хосту с запрашиваемой информацией – IP-адресом и номером порта, на котором запущена служба.

vVols

Улучшения в системе VM Swap

- Улучшена производительность включения/выключения питания

- Улучшена производительность vMotion

Изменения в способе предоставления/уничтожения свопа vVols помогли улучшить включение/выключение питания, а также производительность vMotion и svMotion.

Настройка vVol для сохранения привязки

- Помогает сократить время запроса при поиске информации о ВМ.

- Кэширование различных атрибутов vVol размер, имя и т.д.

Конфигурационный vVol (config-vvol)- это место, где хранятся домашние данные ВМ (vmx, nvrams, журналы и т.д.) и обычно к нему обращаются только при загрузке или изменении. Ранее мы делали так называемое “ленивое отвязывание” и отвязывали config-vvol, когда он не использовался. В некоторых случаях некоторые приложения периодически обращались к config-vvol, и требовалась новая операция привязки. Сохранение привязки config-vvol уменьшает задержки при доступе к домашним данным ВМ.

Улучшение рекультивации пространства Unmap

Снижение минимальной скорости рекультивации(Reclamation) до 10MBPS

Начиная с vSphere 6.7 мы добавили функцию, позволяющую настраивать скорость операции unmap (возвращение удалённых блоков данных в тонкий диск/LUN) на уровне хранилища данных. Благодаря этому усовершенствованию клиенты могут изменять скорость операции unmap, наиболее подходящую для возможностей их массива и рекомендаций производителя. Повышение скорости операции unmap помогло многим поставщикам массивов быстро освободить пространство. Но мы слышали от некоторых клиентов, что даже при самой низкой скорости рекультивации 25 МБ/с эта скорость может нарушить работу массива, когда несколько узлов одновременно отправляют команды unmap. Сбои могут увеличиваться при увеличении количества хостов на одно хранилище данных.

Пример потенциальной перегрузки: 25 МБ/с * 100 хранилищ данных * 40 хостов ~ 104 ГБ/с.

Чтобы помочь клиентам в ситуациях, когда скорость рекультивации 25 МБ/с может привести к сбоям, мы снизили минимальную скорость до 10 МБ/с, настраиваемую для каждого хранилища данных.

Это позволяет клиентам уменьшить потенциальное воздействие многочисленных команд unmap, отправляемых на одно хранилище данных. При необходимости вы также можете полностью отключить рекультивацию пространства для данного хранилища данных.

Выделенная очередь рекультивации по расписанию

Выделенная очередь рекультивации по расписанию позволяет отделить высокоприоритетные запросы метаданных VMFS и обслуживать их из отдельных schedQueues, чтобы предотвратить их истощение после команд UNMAP.

Контейнерное хранилище CNS/CSI

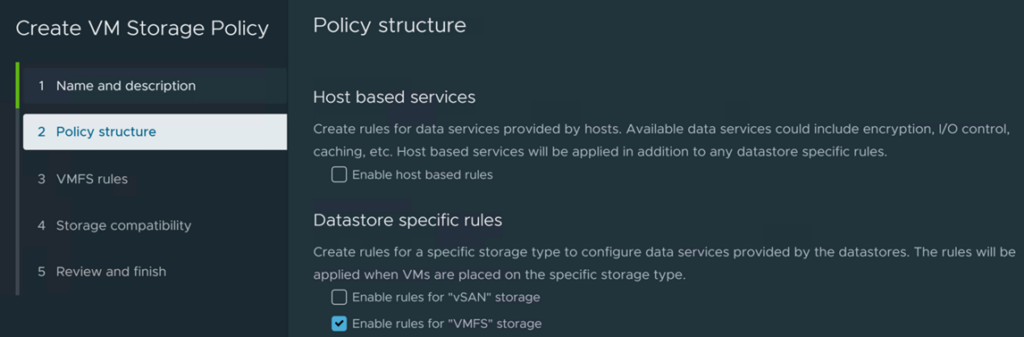

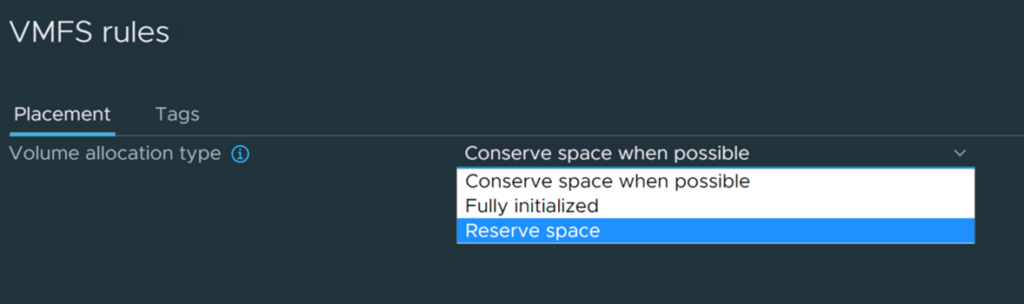

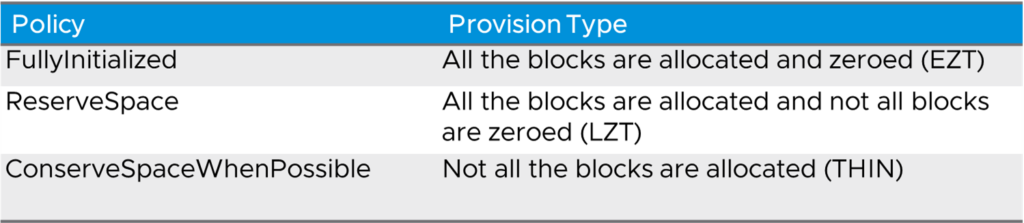

VMFS и vSANDirect Disk Provisioning Storage Policy

Доступен выбор EZT, LZT или Thin provisioning через SPBM-политику для CNS/Tanzu.

Цель – добавить возможность SPBM для поддержки создания/изменения правил политики хранения для указания вариантов распределения томов. Это также облегчит проверку соответствия в SPBM правил распределения томов в политике хранения.

- Для виртуальных дисков поддерживаются следующие операции: создание, изменение конфигурации, клонирование и перемещение.

- Для FCD поддерживаются следующие операции: создание, обновление политики хранения, клонирование и перемещение.

Использование правил инициализации SPBM для создания томов и поддержка проверок соответствия.

Усовершенствования NFS

Инженеры VMware постоянно работают над повышением отказоустойчивости хранилищ. В vSphere 8 добавили усовершенствования NFS, повышающие отказоустойчивость с помощью служб, проверок и подтверждения разрешений.

- Повторное монтирование NFS при сбое

- Проверка монтирования NFS