vMind: 10 years challenge

10 лет назад, 12 марта 2009 года, появились первые статьи на нашем бложике. По модной в этом году тенденции присоединимся к 10 years challenge.

2008-2009

Сезон 2008-2009 для нашей команды выдался на редкость революционным с точки зрения технологий. С августа 2008 мы начали тестирование MS Hyper-V 1.0 и VMware ESXi 3.5 Update 2. Мы были молоды и круты – одни из первых в Перми, кто перешёл на настоящие гипервизоры, а не ваши домашние Virtual PC и VMware Workstation. Желание показать себя и привело к созданию данного блога.

Вход в технологию был очень быстр – два проекта в среднем бизнесе по полному переходу на vSphere. В технологию тогда мало кто верил, мы друзей приглашали смотреть на демонстрацию vMotion – видели бы вы их открытые рты при миграции включенной ВМ с хоста на хост без останова сервисов. Ну, как без останова – MS Exchange Server с несколькими сотнями пользователей минуты 2-3 после vMotion очухивался.

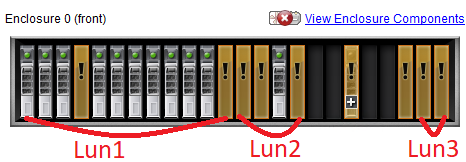

Также показывали блейд-центр и внешнюю систему хранения – про блейды ходило куча мифов, которые приходилось развенчивать, а на поверку они мало чем отличались от рэковых серверов.

Операционные системы от MS дали в этот период сбой – Vista и WS 2008 никак не хотели внедряться – все упрямо сидели и продолжали внедрять WS2003.

К середине 2009 вышел MS 2008 R2, который впечатлил RemoteApp и порадовал Корзиной AD. Hyper-V научился Live Migration и Cluster Shared Volumes – и стал конкурентом бесплатного ESXi. Заодно стало понятно, 32-бита помирают – серверные ОСи стали 64-битные.

MS стали проявлять активность по принуждению к лицензированию, бизнес ставил задачу – либо найти компромисс в лицензировании, либо поискать аналоги продуктов. Поиск аналогов показал, что OpenOffice.org был редкостным УГ, для Visio альтернатив не было. Среди антивирусов была война – NOD32 vs Kaspersky AVP, остальные уже начали сливать рынок. Народ начал переходить на 1с8 после 6 лет выхода. Из-за курса доллара стали рассматриваться и другие отечественные продукты.

Андрей решил после сертификация MCP по WinXP дальше сертифицироваться по серверным продуктам, чтобы повысить свою ценность на рынке труда. Сертификация стоит разумных денег – в 2008 году экзамен по Microsoft можно было сдать за 1500 рублей.

2018-2019

В 2018-2019 тенденция к внедрению отечественных продуктов под эгидой импортозамещения продолжается. Номенклатура продуктов значительно расширилась – конфигураций 1С стало больше. Антивируса в стране осталось 2 с половиной – Касперский, NOD32 и местами супердешёвый Dr.Web, все остальные забились в ниши.

Вместо OpenOffie.org стал LibreOffice – Visio-файлы для просмотра уже открываются. Расплодились российские дистрибутивы Linux – ценник впечатляет, Windows дешевле.

Вместо терминальных серверов многие мигрировали на VDI, которая в наших проектах поделилась на 2 части: офисная с поддержкой legacy ПО в виде 32-битной Windows 7 и тяжелая для САПР с поддержкой NVIDIA GRID на виртуализированных видеокартах. Теперь можно делать vMotion c 3D-графикой – снова Вау-эффект в действии.

Hyper-V не победил и даже не догнал, практика использования показала, что vSphere в частных ЦОДах живее всех живых, а основная конкурентная война ушла в облака.

С серверными ОСями от MS, как и с клиентскими, со всех сторон сплоные непонятки: в РФ основной корпоративной клиентской ОСью остаётся в ближайшие лет 5 Windows 7, а вот с серверами ситуация разнообразнее – WS 2003 всё ещё не умер, многие сидят на WS 2008R2, часть мигрирует на WS 2012R2, а что делать с WS2016/2019 – мало кому понятно. Основная проблема с последними, кроме совместимости с legacy ПО, IMHO, лицензионная – раньше сервисные пакеты не требовали лицензии при отсутствии поддержки, а теперь каждый билд легален только при SA да ещё и по ядрам разбили – тут никаких денег не хватит.

Блейды не захватили весь мир оборудования, рэковые серверы оказались на редкость живучими, как минимум, автономными и без привязки к производителю. Это может быть важным в рамках ухода от американских производителей.

Системы хранения получили сильную конкуренцию со стороны программноопределяемых хранилищ. Внедрение VSAN уже встречается то тут, то там.

Андрей собрал CCNA, MCSA (Win2k3), 4 MCTS, VCP (4, 5, 6), VCAP5:DCA, 10 лет подряд становился vExpert, но разочаровался в дальнейшем процессе сертификации. В немалой степени этому поспособствовал рост стоимости сертификации. В 2019 году экзамен можно сдать через интернет за 5300 рублей, интересный статус как и прежде насчитывает несколько экзаменов.

А что с самим бложиком за 10 лет?

Блог создавался в 2009 году для того, чтобы писать про виртуализацию. Было актуально сравнение VMware/Hyper-V, иногда XEN. За 10 лет актуальность сравнений снизилась, а на рынке появилась “интересная” альтернатива в виде KVM/Nutanix AHV.

Помимо виртуализации на бложике было опубликовано множество других статей (Skype for Business, бэкапы, СХД).

Технически блог продолжил эволюционировать вместе с WordPress. За эти годы были различные попытки оптимизировать производительность, закончившиеся переездом на отдельный VPS-сервер. Появился форум по обмену мнениями.

Проект как был основан, так и остался любительским – пишем по мере желания и интересных находок, в соцсети не пошли – формат остаётся олдскульным.

10 лет пролетели мигом!