По сообщению от Virtual Geek вышла новая версия EMC Storage Viewer 2.1. В данной версии добавлена поддержка vSphere 4 update 1, детальная информация о состоянии репликации, средства просмотра многопутевого ввода-вывода, автоматическое обнаружение массивов.

Author: Mister Nobody

Новая версия виртуального коммутатора Cisco Nexus 1000V

Вышла версия 1.2 виртуального коммутатора Cisco Nexus 1000V.

Из нового:

- GUI Set Up Following Software Installation

- Layer 3 Control

- Virtual Service Domain

- iSCSI Multipath

- XML API

- DHCP Snooping

- Dynamic ARP Inspection

- IP Source Guard

- MAC Pinning

- Static Pinning

Подробности тут.

Диаграмма работы VMware High Availability

Hany Michael опубликовал обновленную версию диаграммы работы HA в гипервизоре vSphere 4 на примере реально существующего кластера. Диаграмма позволяет понять архитектуру и логику высокой доступности от компании VMware.

P.S.

Другие диаграммы:

Новая справочная карта по vSphere

Вышла версия 2.0 справочной карты по vSphere от сайта vreference.com.

Из нового:

- Проведена большая работа над оформлением

- Актуализированы лимиты по ESX 4 Update 1.

- Раскрыта информация по: PVLAN, определениям dvUplink и Network VMotion, опциям vDS VLAN, TPGS, ALUA и прочее.

Всем брать тут.

Вышел ESX 4.0 Update 1A

В связи с обнаруженными косяками при обновлении до Update 1, компания VMware выпустила ESX 4.0 Update 1A.

Качать тут.

Проблема ODBC 32-64 бита в Vmware View 4.0

Филипп Зыков, как обычно, встал на грабли, о месторасположении которых решил поделится.

Еще одно подтверждение важного Issue, который был описан в этой статье.

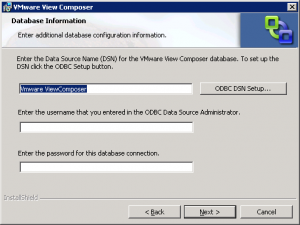

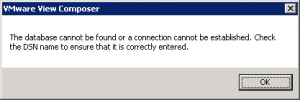

Если вы ставите VmwareView 4.0 на 64-бит систему, где установлен VspherevCenter4.0 Update 1, то будьте готовы к следующему сюрпризу – VspherevCenter4.0 Update 1 требует для своей работы ODBC 32, а VmwareViewComposer из состава VmwareView 4.0 – ODBC 64 бита, и явно это в документации не указано. Об этом вы узнаете на этапе установкиVmwareViewComposer, если попробуете воспользоваться кнопкой ODBCDSNSetup

и будете недоумевать почему ничего не работает и вы получаете следующую надпись.

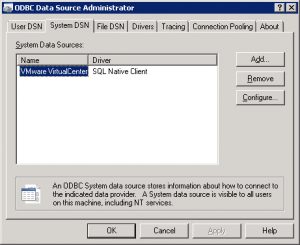

Решить это затруднение на самом деле очень просто – ODBC-подключение для VmwareView 4.0нужно просто заранее подготовить черезStart/AdministrativeTools/ DataSources (ODBC)/SystemDSN. Оно создает ODBCподключение 64-бит по-умолчанию.

И потом при инсталляцииVmwareViewComposerимя созданного SystemDSNи нужно вводить в поле: EntertheDataSourceName (DSN)….

Для справки:VmwareViewComposer ставится локально на систему где установлен VMwareVirtualCenter (так написано в документации).

Реклама Citrix Xen Server Essential

Интересная рекламка от Citrix, направленная против VMware.

Несколько обновлений

Обновились продукты от компании VMware:

- VMware ESX 4.0 Update 1. Подробности.

- VMware vCenter Server 4.0 Update 1. Подробности.

- VMware vCenter Server Heartbeat 5.5 Update 2. Подробности.

- VMware Data Recovery 1.1. Подробности.

- VMware vSphere PowerCLI 4.0 Update 1. Подробности.

Вышел StarWind 5.0 iSCSI SAN

Вышла новая версия StarWind 5.0 iSCSI SAN. Основные изменения:

- Синхронное зеркалирование с автоматическим переход при отказе (Synchronous Mirroring with Automatic Failover)

- Быстрая синхронизация при восстановлении оригинального хранилища после сбоя (Failback with Fast Synchronization)

- Удалённая репликация через Интернет (Remote Replication across a WAN)

- CDP & Snapshots

- Серверная кластеризация(Windows Server 2008, Hyper-V, VMware ESX vSphere 4.0 и приложения)

- Обновленный дизайн

Бесплатная версия также обновилась… дизайном.

Такая разная доступность

Беседуя с различными людьми, часто встречаешь непонимание разницы в механизмах высокой доступности, предоставляемой службами кластера MS и средами виртуализации. Точно такие люди встречаются и с известными ИТ-гуру, в частности, Scott Lowe, который написал небольшую статейку о различиях HA.

Приведу краткий пересказ:

С выходом VMware vSphere 4 в этом году, компания VMware представила технологию VMware Fault Tolerance (VMware FT) – новый механизм, предоставляющий экстремально высокий уровень доступности виртуальных машин. Разговоры с заказчиками, показали мне растущее количество клиентов, которые не понимают разницы в типах высокой доступности, которые даёт VMware(HA и FT) и кластеризация на уровне операционной системы (например, Microsoft Windows Failover Clustering). Хотя, оба типа технологий предназначены для увеличения доступности и уменьшения простоев, они отличны и предоставляют различный уровень функциональности.

Рассмотрим различия:

- VMware HA защищает ESX/ESXi хосты от сбоев, но, по умолчанию, не защищает от сбоев на уровне операционной системы. С другой стороны, кластеры уровня ОС защищают от сбоев ОС. +1 в пользу ОС-кластеров.

- При использовании VMware HA можно выбрать механизм VM Failure Monitoring и получить некий уровень защиты от сбоев на уровнн ОС, но по-прежнему приложения будут не защищены в отличии от кластеров уровня ОС. +1 в пользу ОС-кластеров.

- Такие же аргументы применимы и у к VMware FT. VMware FT не защищает от сбоев ОС — крах ОС произойдет одновременно на основной и вторичной виртуальной машине, тоже самое и со сбоями в приложениях. +1 в пользу ОС-кластеров.

- Вы не сможете переключиться на другую ноду для обновления ОС или применения патчей при использование VMware HA или VMware FT. +1 в пользу ОС-кластеров.

- Аналогично, вы не сможете переключиться на другую ноду для обновления приложений при использование VMware HA или VMware FT. +1 в пользу ОС-кластеров.

- Конечно, и технологии VMware имеют преимущества. VMware HA и VMware FT намного проще включить и сконфигурировать, чем кластер уровня ОС. +1 в пользу VMware.

- VMware HA и VMware FT не требуют поддержки приложений для их защиты. +1 в пользу VMware.

- Ни VMware HA, ни VMware FT не требуют лицензировать специальные редакции ОС или приложений для использования своих преимуществ. +1 в пользу VMware.

- VMware HA может выдать большую нагрузку, чем ОС-кластер. +1 в пользу VMware.

- VMware FT даёт самый высокий уровень доступности по сравнению с существующими кластерными решениями уровня ОС. +1 в пользу VMware.

Заметка не направлена против какой-либо технологии —VMware HA, VMware FT или кластеров уровня ОС, она описывает их достоинства, недостатки, аналогии, различия. Надеюсь, это поможет сделать правильное решение в выборе технологий при разворачивании ЦОД. (Подсказка: Возможно, Вам понадобятся все.)