Филипп Зыков, как обычно, встал на грабли, о месторасположении которых решил поделится.

Еще одно подтверждение важного Issue, который был описан в этой статье.

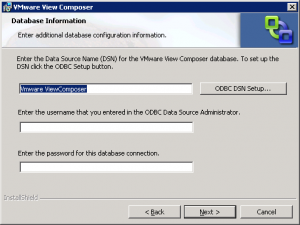

Если вы ставите VmwareView 4.0 на 64-бит систему, где установлен VspherevCenter4.0 Update 1, то будьте готовы к следующему сюрпризу – VspherevCenter4.0 Update 1 требует для своей работы ODBC 32, а VmwareViewComposer из состава VmwareView 4.0 – ODBC 64 бита, и явно это в документации не указано. Об этом вы узнаете на этапе установкиVmwareViewComposer, если попробуете воспользоваться кнопкой ODBCDSNSetup

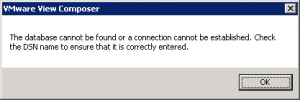

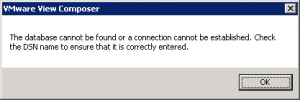

и будете недоумевать почему ничего не работает и вы получаете следующую надпись.

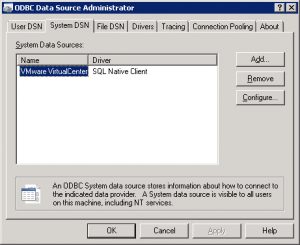

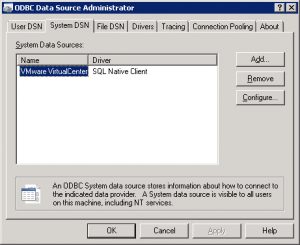

Решить это затруднение на самом деле очень просто – ODBC-подключение для VmwareView 4.0нужно просто заранее подготовить черезStart/AdministrativeTools/ DataSources (ODBC)/SystemDSN. Оно создает ODBCподключение 64-бит по-умолчанию.

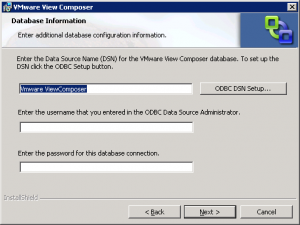

И потом при инсталляцииVmwareViewComposerимя созданного SystemDSNи нужно вводить в поле: EntertheDataSourceName (DSN)….

Для справки:VmwareViewComposer ставится локально на систему где установлен VMwareVirtualCenter (так написано в документации).